【摘要】本文系统梳理了AI技术进步对就业结构、人才需求、伦理治理、数据安全与算法透明性等多维度的深刻影响,结合最新行业数据与案例,探讨了AI驱动下社会变革的机遇与挑战,并提出多方协同应对策略,旨在为技术从业者、管理者和政策制定者提供全面参考。

引言

人工智能(AI)正以前所未有的速度重塑全球经济与社会结构。2024年,微软、谷歌、Meta等科技巨头的裁员潮引发了“AI是否取代程序员”的热议,AI自动化对传统岗位的冲击成为行业关注的焦点。与此同时,AI伦理、数据安全、算法透明性等议题也日益成为社会各界讨论的核心。AI不仅是技术革命的引擎,更是社会治理、就业结构和人类价值观的深度变革者。本文将从AI对就业市场的双重影响、人才结构性短缺、伦理与治理挑战、应对策略等多个维度,深度剖析AI技术进步下的社会变革,力求为技术论坛读者呈现一份兼具技术深度与广度的行业洞察。

一、🚀AI技术进步对就业市场的双重影响

1.1 岗位替代与结构性变革

1.1.1 自动化冲击:科技巨头裁员与岗位变迁

2024年,微软宣布裁员约6000人,其中软件职位占比高达40%,谷歌、Meta等公司也纷纷通过AI自动化优化组织结构。这一系列动作不仅反映了AI对传统岗位的显著替代作用,也揭示了全球就业市场的深刻变革。美国程序员就业人数降至1980年以来最低,2023年年均就业人数骤降27.5%。制造业中,约30%的流水线岗位已被AI和机器人取代,数据录入、客服等重复性岗位同样面临被边缘化的风险。

1.1.2 K型分化与技能重构

AI推动就业结构向“高技能+创造力”倾斜,低技能岗位萎缩,高技能和复合型岗位需求激增,形成“K型分化”格局。AI工程师、机器学习架构师等职位薪资年增长率超25%,但全球合格人才缺口达百万级。与此同时,AI辅助编程、自动化测试等工具的普及,使得普通人与职业程序员的技能鸿沟逐步缩小,推动了技能重构和岗位升级。

1.1.3 效率提升与人力解放

尽管媒体普遍渲染AI大规模替代就业,但国际劳工组织的研究显示,全球仅1%-4%的工作面临高风险被自动化替代,25%为中风险,大多数工作仍需人工参与。AI更多是提升效率、解放人力,让人类能够从繁琐、重复的劳动中解放出来,投入到更具创造性和价值的领域。

1.2 新兴职业与人才结构性短缺

1.2.1 新职业的崛起

AI技术的普及催生了大量新兴职业,如数据标注师、AI训练师、AI伦理官、提示词工程师等。2024年,数据标注岗位需求同比增长55.7%,AI训练师年薪可达12-18万美元,伦理官年薪高达15-25万美元。这些新职业不仅满足了AI系统对高质量数据和伦理治理的需求,也为就业市场注入了新的活力。

1.2.2 复合型与垂直行业人才需求

AI人才需求正从通用技术向垂直行业拓展,AI+医疗、AI+金融、AI+制造等领域的复合型专家炙手可热。企业更看重“人机协作”与跨界能力。例如,医疗AI训练师需标注大量CT影像,教育领域需AI课程设计师,金融领域则需要既懂AI又懂金融风控的复合型人才。

1.2.3 人才缺口与薪资溢价

麦肯锡预测,2030年中国AI人才需求将达600万,缺口高达400万。顶尖AI人才跳槽薪资涨幅可达30%-50%,强化学习、大模型算法方向尤甚。AI职位中约47%要求硕博学历,人才供需矛盾日益突出。

1.2.4 新兴职业与传统岗位的对比表

1.3 就业结构变化的社会挑战

1.3.1 收入不平等与再培训压力

AI加剧了高低技能岗位的分化,中间技能劳动者面临被挤出主流岗位的风险。高技能人才享受薪资溢价,而低技能岗位则被边缘化。再培训和终身学习成为适应AI时代的关键,企业和政府需加大对职业转型和技能提升的投入。

1.3.2 社会保障与心理适应

就业结构的剧变带来社会保障体系的压力,失业、转岗、心理健康等问题日益突出。如何通过社会政策、心理疏导和职业规划,帮助劳动者顺利过渡,是AI时代亟需解决的社会课题。

二、🛡️AI伦理、数据安全与算法透明性挑战

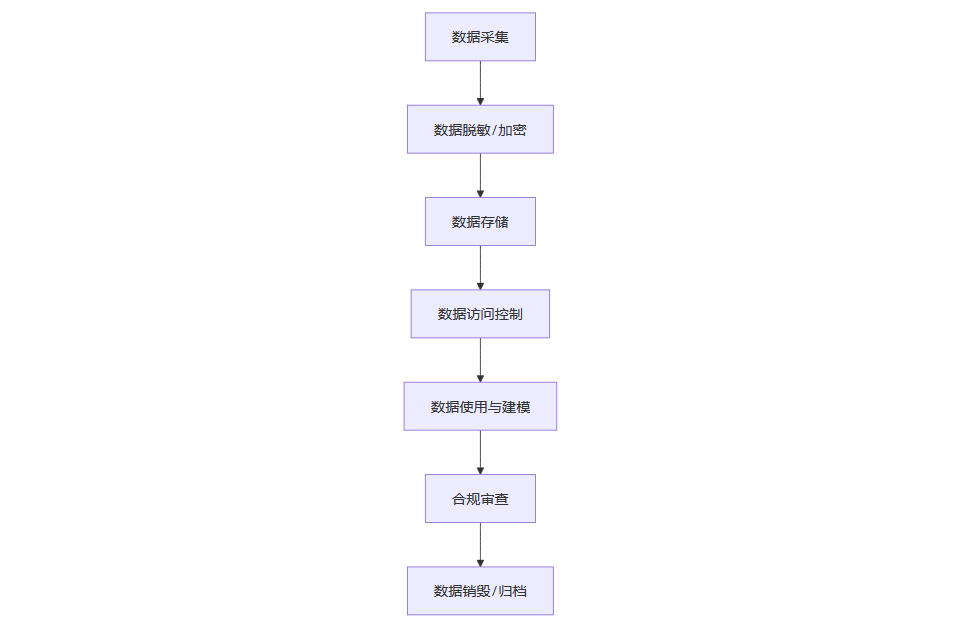

2.1 数据安全与隐私保护

2.1.1 数据依赖与风险

AI系统依赖海量数据,带来隐私泄露、未经同意的数据收集、数据滥用等风险。2023年,ChatGPT数据泄露事件、苹果Siri无意录音等案例引发全球关注。医疗AI违规使用患者数据、金融领域“大数据杀熟”也引发公众不满,数据安全成为AI应用的核心挑战。

2.1.2 技术与法律应对

为应对数据安全风险,差分隐私、联邦学习等技术被广泛应用,既保护了数据隐私,又提升了模型效能。欧盟GDPR强化数据主权,要求用户有权知晓和控制个人数据的使用。中国则要求关键数据本地化存储,并实施生成式AI备案制,强化数据合规管理。

2.1.3 数据安全治理流程图

2.2 算法透明性与可解释性

2.2.1 “黑箱”困境

深度学习模型决策过程难以解释,导致信任危机。美国法院AI风险评估系统COMPAS对黑人误判率高达45%,暴露算法歧视问题。欧盟《AI法案》要求高风险AI系统提供“解释性报告”,中国推动可解释性AI技术和算法备案,提升算法透明度。

2.2.2 可解释性工具与实践

LIME、SHAP等可解释性工具被广泛应用于模型解释,帮助开发者和用户理解AI决策逻辑。企业需建立算法公平性审查机制,定期评估和优化模型,防止算法偏见和歧视。

2.2.3 算法可解释性提升措施列表

引入LIME、SHAP等可解释性工具

建立算法公平性审查机制

定期开展算法偏见检测

公示算法基本原理和决策逻辑

设立用户申诉和人工复核通道

2.3 算法公平性与歧视

2.3.1 数据偏见风险

AI招聘工具因历史数据偏见倾向于推荐男性,面部识别系统对有色人种误判率高。算法偏见不仅损害了个体权益,也影响了AI系统的公信力和社会接受度。

2.3.2 公平性保障措施

企业和监管机构需建立多元化数据采集机制,优化训练数据结构,定期开展算法公平性评估,确保AI系统在性别、种族、年龄等方面的公正性。

2.4 深度伪造与虚假信息

2.4.1 社会信任威胁

生成式AI和深度伪造技术带来虚假音视频泛滥风险,威胁社会秩序和公共安全。AI生成的虚假新闻、伪造证据等问题日益突出,公众对信息真实性的信任度下降。

2.4.2 应对策略

开发数字水印检测工具,提升伪造内容识别能力

利用区块链技术验证信息来源

制定法律严惩虚假信息传播

通过公众教育提升信息鉴别能力

2.5 伦理治理与全球协同

2.5.1 治理模式多元

欧盟通过《AI法案》实施风险分级监管,强调透明度和可解释性;美国以行业自律为主,鼓励企业自主制定伦理规范;中国推行“敏捷治理”,通过沙盒试点和场景分级实现动态监管。G20推动跨境数据流动规则协调,联合国教科文组织提出AI伦理全球标准。

2.5.2 全球协作与挑战

国际社会在法律、伦理、风险监管等方面的协同合作仍显不足,全球统一治理标准亟待建立。各国需加强沟通与协作,共同应对AI带来的跨境风险和伦理挑战。

三、🌱应对策略:多方协同与未来展望

3.1 教育体系改革与终身学习

3.1.1 多学科融合与人才培养

高校需加强AI专业建设,注重STEM与伦理学、社会学等多学科交叉,培养基础研究型、应用复合型和伦理治理型人才。中国设立“AI伦理实验室”,年投入5亿元用于技术与伦理研究,推动AI人才培养与伦理治理并重。

3.1.2 企业培训与个人转型

企业如亚马逊投入12亿美元培训员工转型为机器人协调员,推动员工技能升级和岗位转型。个人需主动提升AI应用能力、跨界整合力和软技能,终身学习成为生存之道。

3.1.3 教育与培训举措表

3.2 企业转型与技术创新

3.2.1 AI与业务深度融合

企业加大AI研发投入,推动AI与业务流程深度融合,关注员工职业发展,构建AI人才生态。AI不仅提升了企业效率,也为员工提供了更多成长和转型的机会。

3.2.2 伦理嵌入与绿色AI

企业如华为通过“可信AI委员会”降低大模型碳足迹,推动技术创新与伦理责任并重。绿色AI、可持续发展成为企业创新的重要方向。

3.3 政策监管与全球协作

3.3.1 法律法规完善

加快AI伦理法规制定,完善数据安全、算法透明、责任归属等治理体系。推动全球协同治理,建立统一标准,提升AI治理的科学性和有效性。

3.3.2 风险分级与动态监管

欧盟实施风险分级监管,禁止社会评分和实时生物识别(反恐除外);中国采用“敏捷治理”模式,动态调整监管,确保AI技术安全可控。

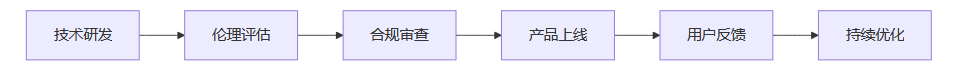

3.4 技术创新与伦理护航

3.4.1 技术与伦理并重

推动差分隐私、联邦学习等前沿技术,强化伦理护航,防止技术滥用。企业、政府、学界和公众需共同参与AI治理,确保技术进步与社会价值的和谐共存。

3.4.2 技术创新与伦理治理流程图

结论

AI技术正深刻重塑社会结构、就业市场和伦理治理体系。它既是“就业杀手”,也是“创新引擎”。面对技术进步带来的机遇与挑战,唯有坚持创新驱动与伦理护航并重,推动教育、法律、产业和社会多方协同,才能实现AI技术的健康可持续发展,真正服务于全人类的福祉。历史经验表明,技术革命的终局并非零和博弈,而是社会效率与人文价值的共同提升。未来的关键在于以伦理为舵,引导AI技术向善而行,构建“人类独有能力+AI工具”的新型职场生态,拥抱变革,共创未来。

💬 【省心锐评】

“AI不会取代人类,但会用AI的人终将取代不用AI的人。技术伦理不是绊脚石,而是确保创新不脱轨的导航系统。”

.png)

评论