【摘要】Manus智能体平台在经历爆火、裁员与社交账号清空后,首次系统性复盘其技术路线与经验教训。本文深度剖析Manus在Agent系统上下文工程、KV缓存、工具管理、外部化记忆、错误处理等方面的创新实践与反思,全面展现AI Agent研发的挑战与未来方向。

引言

2024年,AI智能体(Agent)领域风起云涌。Manus,这个由Monica团队孵化、号称“全球首款通用智能体”的项目,在短短数月内从默默无闻到全球刷屏,成为AI圈的现象级产品。它不仅在GAIA等基准测试中超越OpenAI DeepResearch,更以邀请制引发全球用户的狂热追捧。然而,热潮之下,Manus也经历了裁员、社交账号清空等风波。就在外界对其未来充满疑问时,Manus联合创始人季逸超罕见地发布了长篇技术博客,首次系统性复盘了Manus从爆火到低谷的技术路线、架构演进与深刻教训。

本文将以Manus的技术复盘为主线,深度剖析AI Agent系统在上下文工程、KV缓存、工具管理、外部化记忆、错误处理等关键环节的创新实践与反思,结合行业发展趋势,探讨通用智能体的未来可能性。文章力求结构严谨、逻辑清晰、语言流畅,既有技术深度,也兼具行业广度,旨在为AI开发者、产品经理及关注智能体未来的读者,提供一份兼具参考价值与启发意义的深度读本。

一、Manus的技术抉择与Agent系统的本质

%20%E6%8B%B7%E8%B4%9D-fhun.jpg)

1.1 端到端模型还是上下文工程?AI Agent的路线之争

1.1.1 时代背景:从BERT到LLM的范式转移

回顾NLP技术的十年演进,BERT时代的模型需要针对每个新任务进行微调和评估,迭代周期长、反馈缓慢,极大限制了产品创新速度。随着GPT-3、Flan-T5等大模型的出现,上下文学习(Contextual Learning)成为新范式,模型无需微调即可通过提示工程适应新任务。这一变革为Agent系统的快速迭代和大规模应用奠定了基础。

1.1.2 Manus的选择:押注上下文工程

Manus团队深刻吸取了前一轮创业中“自研模型被淘汰”的教训,果断放弃端到端自训练Agentic模型的路线,转而押注于上下文工程(Context Engineering)。这一决策的核心逻辑在于:

极大缩短产品迭代周期:从数周缩短到数小时,快速响应用户需求。

与底层模型解耦:底层模型进步时,Manus作为“船”随潮水而动,而非“搁浅的柱子”。

灵活适配多模型生态:无论是自托管还是API调用,均可无缝切换。

1.1.3 上下文工程的挑战与本质

上下文工程并非简单的提示堆砌,而是一门实验科学。Manus团队在短时间内重构了四次Agent框架,每一次都是对上下文塑造方式的深度反思与优化。其本质是通过架构搜索、提示调整和经验猜测的“手工随机梯度下降”,在实践中不断逼近局部最优解。

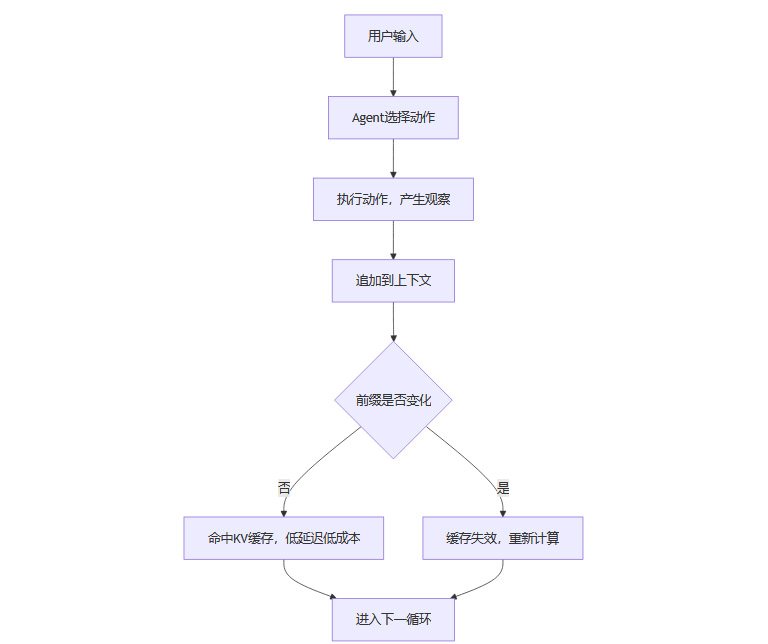

1.2 Agent系统的核心循环与上下文膨胀

1.2.1 Agent的工作流程

一个典型的Agent系统,其核心循环如下:

用户输入任务。

Agent根据当前上下文,从预定义的动作空间中选择一个动作。

动作在环境(如虚拟机沙箱)中执行,产生观察结果。

动作与观察结果被追加到上下文,作为下一步输入。

循环往复,直至任务完成。

这一循环导致上下文不断膨胀,输入token远超输出token,极大考验模型的上下文处理能力与系统的工程优化。

1.2.2 KV缓存:Agent系统的性能生命线

在Agent系统中,KV缓存(Key-Value Cache)命中率成为影响延迟与成本的关键指标。以Manus为例,平均输入与输出的token比例高达100:1。通过高命中率的KV缓存,可将推理成本降低10倍以上(如Claude Sonnet,缓存输入0.3美元/百万token,未缓存3美元/百万token)。

二、上下文工程的五大核心实践

2.1 围绕KV缓存进行系统设计

2.1.1 KV缓存的原理与价值

KV缓存通过存储模型前缀的中间状态,实现重复前缀的高效复用,极大降低首token生成时间(TTFT)和推理成本。对于Agent系统这种“长输入、短输出”的场景,KV缓存的优化价值尤为突出。

2.1.2 提高KV缓存命中率的关键实践

保持提示前缀稳定:避免在系统提示中引入时间戳等动态内容,哪怕一个token的差异也会导致缓存失效。

上下文仅追加,不修改历史:确保序列化过程确定性,避免JSON键顺序变化等隐性破坏缓存的因素。

显式标记缓存断点:部分推理框架需手动插入断点,合理分配以防缓存过期。

分布式一致性路由:自托管模型时,需通过会话ID等方式确保跨工作器的缓存一致性。

2.1.3 KV缓存优化流程图

2.2 工具管理:屏蔽而非移除

2.2.1 动作空间膨胀的困境

随着Agent能力扩展,工具数量爆炸式增长,用户自定义工具更是加剧了动作空间的复杂性。过多的工具导致模型选择错误动作、路径低效,Agent“全副武装反而更笨”。

2.2.2 动态动作空间的陷阱

动态增删工具破坏KV缓存:工具定义通常位于上下文前部,任何变动都会导致后续缓存失效。

上下文引用失效引发模型困惑:历史操作引用已删除工具,易导致模式冲突或幻觉动作。

2.2.3 Manus的解决方案:上下文感知的状态机与token屏蔽

Manus采用上下文感知的状态机管理工具可用性,不直接删除工具,而是在解码期间通过屏蔽token logits约束动作选择。具体做法包括:

设计一致前缀的动作名称(如browser_、shell_),便于分组屏蔽。

利用响应预填充机制,灵活实现自动、必需、指定三种函数调用模式。

保持工具定义稳定,最大化KV缓存命中率。

2.2.4 工具管理模式对比表

2.3 外部化记忆:文件系统即上下文

2.3.1 长上下文的三大痛点

观察结果庞大,易超上下文窗口(如网页、PDF)。

上下文过长,模型性能下降。

长输入即便缓存,传输与预填充成本高昂。

2.3.2 传统压缩策略的局限

上下文截断或压缩虽可缓解窗口压力,但不可逆压缩必然带来信息丢失,影响Agent长期决策的准确性。

2.3.3 Manus的创新:文件系统作为无限外部化记忆

Manus将文件系统视为“终极上下文”,模型可按需读写文件,将长期状态外部化。压缩策略始终可恢复,如保留URL即可删除网页内容,保留路径即可省略文档内容。这样既缩短了上下文长度,又不丢失关键信息。

2.3.4 外部化记忆的未来展望

如果未来的状态空间模型(SSM)能掌握基于文件的外部化记忆,将有望突破Transformer的长期依赖瓶颈,成为新一代高效Agent架构的基础。

2.4 操纵注意力:通过“背诵”强化目标

2.4.1 任务漂移的风险

复杂任务往往需要数十次工具调用,LLM驱动的Agent极易“跑题”或遗忘早期目标,尤其在长上下文下更为突出。

2.4.2 Manus的实践:动态复述目标

Manus在处理复杂任务时,会不断重写todo.md文件,将全局计划复述到上下文末尾。这样做的效果是:

将任务目标推送到模型近期注意力范围,减少“迷失在中间”。

利用自然语言强化模型对目标的关注,无需架构改动。

2.4.3 注意力操纵的启示

通过“背诵”机制,Agent可在长循环中保持目标一致性,显著提升多步任务的完成率与鲁棒性。

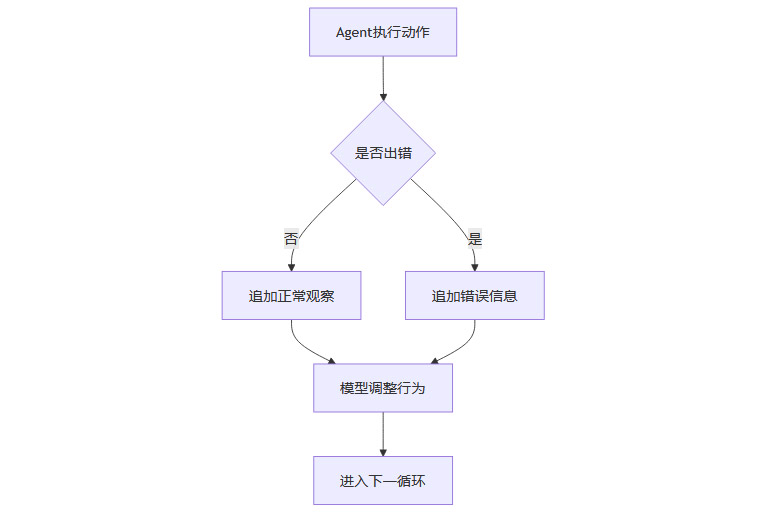

2.5 错误处理:保留而非隐藏

2.5.1 错误是Agent的常态

多步骤任务中,模型幻觉、环境异常、工具故障等错误在所难免。隐藏错误虽可“美化”表现,但会剥夺模型自我修正的机会。

2.5.2 保留错误的价值

将失败操作及其观察结果保留在上下文中,模型可隐式调整内部信念,降低重复犯错概率。错误恢复能力是智能体“真正智能”的标志,远比理想条件下的任务成功更具现实意义。

2.5.3 错误处理流程图

三、上下文多样性与Agent鲁棒性

%20拷贝-iltz.jpg)

3.1 少样本提示的陷阱

3.1.1 模型的模仿本能

LLM善于模仿上下文中的行为模式,少样本提示虽可提升输出质量,但在Agent系统中,过于统一的上下文会导致模型陷入“节奏陷阱”,重复非最优操作。

3.1.2 多样性引入的必要性

Manus通过在行动与观察中引入结构化变化(如不同模板、措辞、顺序、格式噪声),打破模式单一性,提升模型的鲁棒性与适应性。

3.1.3 上下文多样性优化表

四、Manus的经验教训与Agent系统的未来

%20%E6%8B%B7%E8%B4%9D-jtse.jpg)

4.1 上下文工程的科学化与系统化

上下文工程已成为Agent系统的核心科学。无论模型多强大,记忆、环境与反馈的工程塑造,才决定了Agent的行为边界、恢复能力与扩展性。Manus通过反复重写、死胡同与大规模用户测试,积累了宝贵的工程模式。

4.2 Agent系统的未来趋势

4.2.1 模型与工程的协同进化

未来Agent系统的突破,既依赖于底层模型的能力提升,也离不开上下文工程、外部化记忆、工具管理等系统层面的创新。两者协同,方能实现真正的通用智能体。

4.2.2 外部化记忆与长期依赖

文件系统等外部化记忆机制,将成为Agent突破长期依赖瓶颈的关键。SSM等新架构若能与外部化记忆深度结合,有望催生新一代高效、可扩展的智能体。

4.2.3 错误恢复与自适应能力

错误恢复能力将成为衡量Agent智能水平的重要指标。未来的Agent应能在复杂环境中自适应调整,持续进化,而非仅在理想条件下“完美表现”。

结论

Manus的技术复盘,为AI Agent系统的研发提供了极具参考价值的工程范本。从上下文工程、KV缓存、工具管理、外部化记忆,到错误处理与多样性优化,每一环节都凝结着团队对智能体本质的深刻洞察。Agent系统的未来,既是模型能力的竞赛,更是工程科学的较量。唯有在实践中不断试错、总结、优化,才能在智能体的浪潮中立于不败之地。Manus的经验教训,值得每一位AI从业者深思与借鉴。

📢💻 【省心锐评】

Manus的复盘让Agent研发回归本质:技术创新,工程为王,细节决定成败。

.png)

评论