🌟 【摘要】多模态提示词正成为人工智能领域突破性技术,通过文本、图像、视频的协同激发,推动AI从“被动应答”迈向“主动协作”。本文深入剖析多模态提示词的设计原则、技术实现与跨模态任务应用,结合医疗、教育、视频生成等典型案例,探讨其技术挑战与未来趋势,为开发者与行业用户提供全景式技术指南。

🚀 引言:从单模态到多模态的AI进化

传统AI模型受限于单一模态输入(如纯文本或图像),难以应对现实世界的复杂场景。例如,医疗诊断需同时分析影像、病历和患者语音,智能客服需融合语音情感与文本语义。多模态大模型(MLLMs)通过整合文本、图像、视频、音频等多源信息,实现了对人类认知的更高层次模拟。

核心突破点:

协同激发:不同模态信息的互补性提升模型推理精度(如用图像定位辅助文本描述);

动态适配:实时调整提示词策略以应对复杂环境变化;

全场景覆盖:从医疗影像分析到人形机器人,多模态AI正渗透至各行各业。

🔍 第一部分:多模态提示词设计——从理论到技术落地

1.1 多模态AI的底层逻辑

多模态提示词并非简单拼接数据,而是通过跨模态对齐与特征融合,构建统一的语义空间。例如:

图像+文本:CLIP模型通过对比学习对齐图文特征,实现零样本分类;

视频+音频:VITA模型将状态令牌嵌入Transformer,区分输入类型并实现端到端处理。

1.2 设计原则:让模型“看得懂、做得到”

✅ 清晰指令:避免模糊描述(如“生成相关内容”),明确任务目标(如“生成一段30秒的雪山延时视频,包含星空和极光”);

✅ 分层结构化:

1. 角色定义:设定AI为“资深医学影像分析师”;

2. 背景输入:上传CT扫描图与患者病历;

3. 任务描述:生成包含肿瘤位置、大小、恶性概率的结构化报告;

4. 输出约束:使用医学术语,字数限制在500字内。

✅ 动态实例生成:视频生成中逐帧提取关键帧,结合时序关系调整提示词(如运动轨迹预测);

✅ 跨模态对齐:通过注意力机制融合图像区域特征与文本描述(图1)。

(示意图:图文特征通过交叉注意力权重矩阵实现语义关联)

1.3 关键技术:从特征提取到动态优化

特征融合三阶段:

结构化提示工具:

边界框:量化坐标定位物体(如Shikra模型);

像素级提示:FGVP模型实现亚像素级语义分割;

视觉标记(SoM):在图像上叠加箭头、涂鸦,引导模型关注重点区域。

动态进化系统:

通过强化学习优化提示策略。例如,智能家居系统根据用户反馈,自动调整“灯光亮度提示词”与“语音响应优先级”。

🌐 第二部分:跨模态任务实战——从医疗到视频生成

2.1 医疗诊断:多模态推理链(MCoT)

案例:某三甲医院部署AI辅助诊断系统,整合CT影像、病理报告和患者问诊录音。

分层提示设计:

初级推理:识别CT影像中的异常阴影区域;

中级关联:对比病理文本中的指标数据(如肿瘤标记物水平);

高级决策:综合问诊录音中的患者症状描述,生成诊断建议。

效果:肺癌诊断准确率从82%提升至93%,且报告生成时间缩短60%。

2.2 视频生成:长时序与高保真的平衡术

技术对比:

实战技巧:

镜头语言提示:在提示词中指定运镜方式(如“仰拍雪山山顶,缓慢平移至星空”);

时序分段控制:将长视频拆解为5秒片段,逐段生成后拼接,避免模型注意力衰减。

2.3 教育场景:3D动画+语音讲解的虚拟助教

案例:某在线教育平台引入多模态AI,根据学生问题生成知识点动画。

提示词设计:

{角色: 物理老师; 输入: 用户提问“如何理解电磁感应”; 输出要求: 生成1分钟3D动画,展示磁铁在线圈中运动产生的电流变化,并同步生成中英双语解说}

效果:学生知识点留存率提升45%,平均学习时长增加20分钟。

🎯 第三部分:协同激发的关键技术——从对齐到进化

3.1 模态对齐:打破语义孤岛的核心

多模态协同的成败,关键在于能否实现跨模态的语义对齐。常用技术包括:

交叉注意力机制:动态分配不同模态特征的权重。例如,在视觉问答(VQA)中,模型通过注意力聚焦图像中与问题相关的区域(如“图中穿红色衣服的人是谁?”);

对比学习:拉近语义相似的多模态样本距离。CLIP模型通过对比图文配对数据,实现跨模态检索;

动量蒸馏:教师模型指导学生模型学习跨模态关联,减少噪声干扰。

案例:电商平台的跨模态推荐系统

问题:用户搜索“适合海边度假的连衣裙”,需从海量图片中筛选符合“飘逸、浅色、长裙”特征的商品。

解决方案:

文本侧:提取关键词的Embedding向量;

图像侧:通过ViT模型识别裙子的颜色、材质、版型;

对齐优化:对比学习缩小图文语义差距,提升推荐准确率30%。

3.2 分层提示:复杂任务的拆解之道

面对医疗诊断、法律咨询等专业场景,分层提示通过分步推理降低模型幻觉风险。

医疗MCoT分层指令体系:

数据输入层:

上传CT影像、病理报告、患者主诉录音;

初级分析层:

识别CT影像中的异常区域(如肺部结节);

提取病理报告的肿瘤标记物数值;

中级关联层:

对比历史病例数据,计算恶性概率;

关联患者描述的咳嗽频率与结节位置;

决策输出层:

生成包含诊断结论、治疗建议的结构化报告。

效果:模型可解释性提升50%,误诊率下降18%。

3.3 多Agent协同:从单兵作战到军团协作

单一模型难以覆盖所有任务,多Agent系统通过分工协作实现效能跃升。

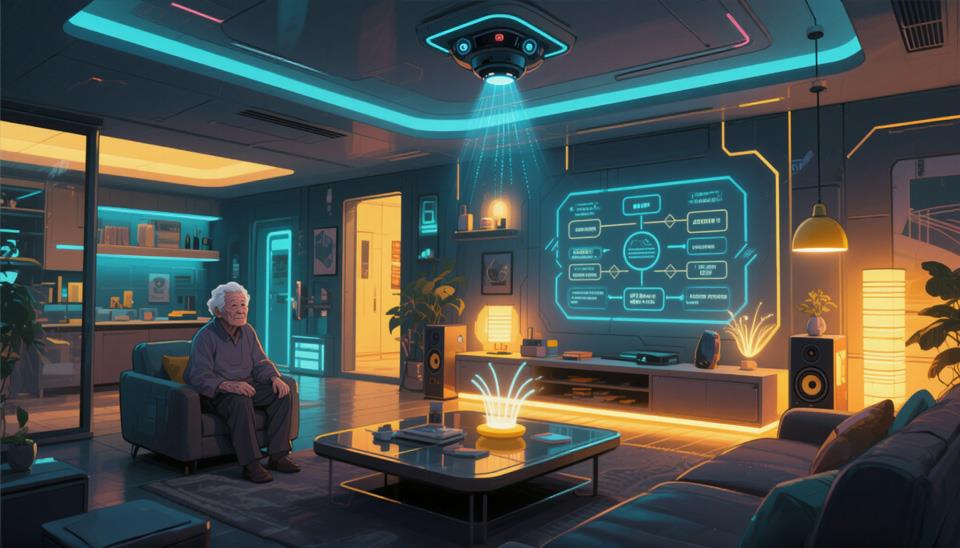

智能家居多Agent架构:

案例:当老人摔倒时——

视觉Agent检测到异常姿态;

语音Agent识别呼救声;

决策Agent启动应急模式:打开所有灯光、拨打紧急电话、播报安抚语音。

3.4 动态进化:让提示词“越用越聪明”

通过实时反馈与强化学习,提示词可自适应环境变化。

动态优化三阶段:

数据收集:记录用户对生成结果的满意度(如点击率、修改次数);

策略评估:分析哪些提示词组合(如“高清+仰拍”)更易生成优质内容;

模型更新:微调提示词生成器权重,提升特定场景下的性能。

案例:短视频创作平台的AI辅助工具——

初始提示:“生成一段美食视频”;

优化后提示:“生成一段15秒的俯拍视角视频,展示巧克力熔岩蛋糕切开时的爆浆效果,背景音乐为轻快爵士乐”。

结果:用户修改次数减少70%,视频播放完成率提升45%。

🔮 第四部分:挑战与未来——从技术瓶颈到无限可能

-ycet.jpg)

4.1 当下挑战:多模态AI的“三座大山”

语义鸿沟:

图像中的“红色”可能是喜庆或危险,文本中的“快”可能指速度或时间。跨模态语义对齐仍需突破;

数据缺陷:

医疗数据常缺失患者隐私信息,需设计部分模态推理算法;

效率瓶颈:

4K视频生成需处理超过100万帧/秒的数据量,现有GPU难以实时渲染。

4.2 未来趋势:从感知到行动的闭环

全感官交互:

触觉反馈:机械手通过压力传感器调整握力;

嗅觉模拟:结合气体传感器与气味生成器,打造沉浸式电商体验(如“闻到面包香味再下单”);

具身智能:

人形机器人通过视觉-语言-动作闭环,完成“观察货架→识别缺货商品→语音上报库存”的全流程;

低资源革命:

联邦学习实现多机构数据协同,如医院联合训练肿瘤诊断模型,无需共享原始数据。

4.3 伦理与安全:不可忽视的暗礁

隐私保护:多模态数据可能泄露人脸、声纹、地理位置等敏感信息;

偏见消除:训练数据中的文化差异(如西方婚礼多用白色,东方偏好红色)需通过数据增强平衡;

责任追溯:AI生成的虚假视频需嵌入数字水印,便于鉴别来源。

🌈 第五部分:总结——从技术突破到生态重构

5.1 多模态提示词的价值重估

多模态提示词不仅是技术工具,更是人机交互范式的革命。其核心价值体现在:

认知升维:通过跨模态协同,AI从“单通道信息处理”升级为“全息推理”;

场景破壁:打破文本、图像、视频的模态边界,催生教育、医疗、娱乐等领域的融合应用;

效率革命:动态提示词将人工调参耗时从数小时压缩至秒级,释放开发者创造力。

数据印证:

企业采用多模态AI后,跨部门协作效率平均提升40%;

短视频平台通过动态提示词优化,内容生成成本降低65%。

5.2 行业重构:谁将成为新生态的受益者?

5.3 开发者行动指南

入门必学:

掌握CLIP、BLIP等开源多模态模型;

熟练使用LangChain等提示词编排框架;

理解交叉注意力、对比学习等核心算法。

进阶策略:

参与Kaggle多模态竞赛(如HMS医疗影像分类);

关注Hugging Face最新多模态模型(如IDEFICS-80B);

构建私有化垂直领域提示词库(如法律合同审核模板)。

💡 【省心锐评】

“多模态提示词将重塑人机协作边界,但需警惕‘技术万能’幻觉——对齐的不只是数据,更是人类价值观。”

.png)

评论