【摘要】模型上下文协议(MCP)从万众期待的“AI通用接口”沦为开发者眼中的“工程负债”。其背后是技术理想与工程现实的剧烈碰撞,揭示了AI基础设施在成本、稳定性与可靠性上的核心挑战。

引言

模型上下文协议(MCP)刚刚度过它的一周岁生日。一年前,它承载着统一AI Agent生态的宏大愿景,被誉为AI时代的“USB-C”接口,风光无两。一年后的今天,当初的热烈讨论已然冷却,社区的关注点早已转移。当初被寄予厚望的“小甜甜”,如今在许多一线开发者眼中,更像是一笔需要审慎评估的“工程负债”。

这种转变并非偶然。它深刻反映了AI技术从概念炒作走向生产实践的必经阵痛。MCP的经历,为我们提供了一个绝佳的剖析样本,用以审视当前AI Agent落地所面临的真实困境。本文将从技术架构、工程实践、经济成本与模型行为等多个维度,系统性地复盘MCP从被捧上神坛到光速失宠的全过程,并探讨其对未来AI基础设施建设的启示。

一、🔮 理想的诞生:MCP的“预制爆款”之路

%20拷贝-zwuk.jpg)

MCP的崛起,并非一场自下而上的技术革命,更像是一场自上而下的标准统一运动。它的走红路径与ChatGPT这类依靠产品力引爆市场的产品截然不同,其背后有着深刻的行业背景与大厂的战略意图。

1.1 宏大叙事:为AI Agent打造“通用语”

MCP的诞生,直指AI应用开发中的一个核心痛点,即生态碎片化。在MCP出现之前,大语言模型(LLM)与外部工具、数据源的集成,如同建造一座新的“巴别塔”。每个模型、每种工具都有自己独特的API规范与数据格式,开发者需要为每一个集成点编写大量的“胶水代码”,进行繁琐的适配与维护工作。

这种状况极大地限制了AI Agent的能力边界与开发效率。Agent若想具备处理复杂任务的能力,就必须能够无缝、灵活地调用多样化的外部工具。MCP的初衷正是为了解决这一难题。它希望定义一套标准化的接口协议,让任何模型都能以统一的方式发现、理解并调用任何遵循该标准的工具。

这个愿景极具吸引力。它承诺为混乱的AI生态带来秩序,其目标是成为如同TCP/IP之于互联网、USB之于外设那样的基础性协议。MCP被包装成AI Agent时代的“万能连接器”,一个能够让AI“连接万物”的基础设施。

1.2 巨头合力:一场精心策划的“默契球”

MCP的热度迅速攀升,离不开行业巨头的鼎力支持。由Anthropic发起,迅速得到了OpenAI、谷歌、微软等重量级玩家的响应与背书。这种巨头间的协同,本质上是一场为了抢占下一代AI生态标准话语权的“默契球”。

当时,“2025年是Agent之年”的叙事正在被反复强化。各大厂商都将Agent视为继LLM之后最重要的战略高地。一个统一的工具调用标准,不仅能加速自家模型的生态建设,更能通过定义标准来影响整个行业的发展路径。

因此,我们看到了一系列组合拳。

资本推动:顶级VC与科技巨头为遵循MCP标准的初创公司提供资金与资源支持。

社区共建:大厂开放自身工具库,鼓励开发者将工具接入MCP生态。

舆论造势:技术布道师、行业媒体集中宣传MCP的先进性与重要性。

在这样的合力推动下,MCP生态在短短数月内实现了爆炸式增长,数千个工具宣布接入。对于身处其中的开发者而言,这似乎预示着一个新时代的到来。MCP的走红,是典型的“期望膨胀期”产物,其热度更多源于宏大叙事与大厂背书,而非经过生产环境检验的实际价值。

二、⚙️ 现实的裂痕:工程落地中的三重困境

当开发者满怀期待地将MCP引入生产环境后,理想与现实的巨大差距开始显现。那些在概念阶段被忽略或淡化的工程问题,如潮水般涌来,将MCP的脆弱性暴露无遗。

2.1 协议设计的“原罪”:脆弱的架构与有限的能力

MCP协议在设计之初,或许更多地考虑了接口的通用性与简洁性,但在鲁棒性(Robustness)与可观测性(Observability)方面存在明显短板。

2.1.1 决策的“黑盒”:缺失上下文追踪机制

一个核心缺陷是MCP没有提供标准的上下文传播与追踪(Context Propagation & Tracing)机制。当一个Agent为了完成任务而进行一连串的工具调用时,开发者无法清晰地知道。

AI的决策路径中到底调用了哪些工具?

每个工具调用的输入和输出是什么?

调用链路上哪个环节出现了问题?

这使得调试与排错变得异常困难。一旦Agent的行为偏离预期,开发者就像在没有航海图的大海上寻找一根针。对于要求高可靠性的企业级应用,这种“黑盒”状态是不可接受的。

2.1.2 连接的“陷阱”:缺乏截止时间与错误传播

另一个严重问题是协议层面缺少对截止时间(Deadline)和错误传播(Error Propagation)的标准化处理。设想一个场景,Agent调用了一个外部API,而该API由于网络问题或自身故障,长时间没有返回结果。

在缺乏超时机制的情况下,Agent进程会被无限期地“卡死”在这个调用上,无法继续执行后续任务,也无法向调用方报告错误。这种脆弱性使得基于MCP构建的Agent系统极不稳定,任何一个外部工具的抖动都可能引发整个系统的雪崩。

2.2 云端部署的“噩梦”:与生俱来的复杂性

MCP协议通常采用服务器发送事件(SSE)或标准输入输出(stdio)等长连接方式进行通信。这种设计在本地开发或简单场景下运行良好,一旦进入云原生、分布式的生产环境,就会演变成一场部署与运维的噩梦。

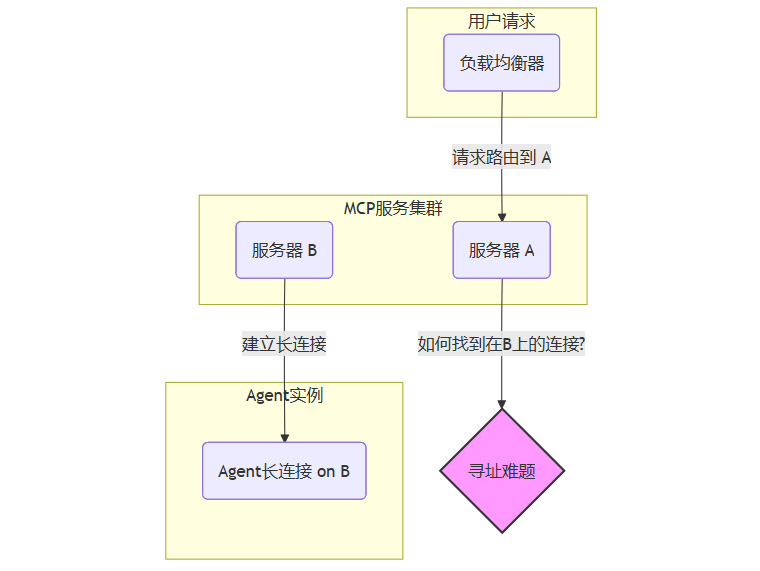

2.2.1 扩展的难题:跨服务器寻址的挑战

在需要应对高并发的企业级应用中,服务通常会水平扩展到多个服务器节点上。此时,MCP的双连接模型(一个用于控制,一个用于数据)会引入跨机器寻址的复杂性。

我们可以用一个简单的流程图来说明这个问题。

一个用户的HTTP请求可能被负载均衡器路由到服务器A,但该用户对应的Agent长连接实例却建立在服务器B上。服务器A如何知道要将指令发送给服务器B上的特定连接?这就需要引入额外的、复杂的机制,例如。

服务发现层:记录每个连接所在的节点信息。

消息广播队列:服务器A将消息发布到队列中,服务器B订阅并消费,再转发给对应的连接。

这些额外的组件大幅增加了系统的架构复杂度和维护成本,完全违背了MCP旨在简化开发的初衷。

2.2.2 运维的重负:自建“看门狗”的必要性

由于协议本身缺乏心跳检测和自动重连等健壮性机制,运维团队常常需要自行开发“看门狗”(Watchdog)程序或复杂的健康检查逻辑,来监控和管理成千上万的长连接。这进一步加重了运维负担,使得MCP在生产环境中的稳定性保障成为一项高成本投入。

2.3 经济模型的“陷阱”:难以承受的“Token税”

如果说架构缺陷是技术债,那么高昂的运行成本则是压垮许多项目的直接原因。MCP的运行机制,天然地带来了一种极其昂贵的“Token税”。

2.3.1 上下文的指数级膨胀

MCP的核心机制要求,所有工具的定义(包括功能描述、参数说明、返回格式等)都必须被完整地放入模型的上下文窗口(Context Window)中,以便模型能够理解并决定调用哪个工具。

这意味着,随着Agent接入工具数量的增加,每次请求发送给模型的上下文大小会呈指数级增长。假设平均每个工具的定义需要500个Token。

接入5个工具,额外上下文成本是

5 * 500 = 2,500 Tokens。接入20个工具,额外上下文成本是

20 * 500 = 10,000 Tokens。接入100个工具,额外上下文成本是

100 * 500 = 50,000 Tokens。

这还仅仅是工具定义的成本。实际的调用请求、返回结果都需要在上下文中流转,进一步推高Token消耗。

2.3.2 成本与性能的双重打击

高昂的Token消耗带来了两个直接的负面后果。

账单飙升:对于大型项目,仅仅是工具定义所消耗的Token,其费用就可能远超于解决实际问题所需的Token。有数据显示,在复杂任务场景下,采用传统MCP模式可能需要消耗十几万Token,而通过代码执行、按需加载等优化方式,可以将消耗降低至数千Token,成本节省超过90%。

性能下降:更大的上下文窗口意味着模型需要更长的处理时间,导致Agent的响应延迟显著增加,影响用户体验。

下面的表格直观地对比了不同工具调用模式下的成本与性能差异。

这种经济上的不可持续性,使得开发者陷入了一个两难境地。要么为了发挥MCP的灵活性而承受高昂成本,要么为了控制成本而严格限制工具数量,从而牺牲了MCP的核心价值。最终,MCP在经济模型上被证明是低效且昂贵的。

三、🧠 致命的软肋:注意力稀释与幻觉放大

%20拷贝-xusm.jpg)

如果说工程和成本问题尚可通过技术迭代或增加投入来缓解,那么MCP对模型核心能力——可靠性——的侵蚀,则是其最致命的缺陷。

3.1 核心矛盾:Agent的价值在于“干活”

我们需要明确一个基本前提。AI Agent与AI聊天机器人有着本质区别。聊天机器人偶尔出错,用户可能会觉得有趣;但Agent的核心价值在于准确、可靠地执行任务。它的每一次操作都可能直接影响真实的业务流程、用户数据甚至物理设备。

因此,Agent的可靠性是其生命线。任何会显著降低其可靠性的技术,都必须被审慎对待。

3.2 注意力的“稀释效应”

LLM的决策过程,本质上是一个基于上下文信息的概率计算。当MCP将大量工具定义塞入上下文时,就如同在一个房间里同时有几十个人对模型大喊大叫,这会严重稀释模型的注意力。

模型需要从海量、冗长的工具描述中,艰难地找出最适合当前任务的那一个。工具选项越多,信息噪音越大,模型做出错误判断的概率也随之急剧上升。它可能会。

选错工具:选择一个功能不相关或效率低下的工具。

误解参数:错误地理解工具所需参数的含义或格式。

凭空捏造:产生“幻觉”,调用一个根本不存在的工具或参数。

这种现象被称为“幻觉工具调用”(Hallucinated Tool Calling)。

3.3 从“胡说八道”到“业务实错”

幻觉问题对于Agent是灾难性的。它不再是简单的“胡说八道”,而是会转化为实际的、错误的业务操作。

想象一个电商管理Agent。

理想情况:用户说“给ID为123的订单退款”,Agent准确调用

refund_order(order_id=123)。幻觉情况:由于工具库中有上百个工具,模型注意力被稀释,错误地调用了

delete_order(order_id=123),直接删除了订单数据。

这种由幻觉引发的业务错误,轻则导致流程中断、数据错乱,重则可能造成不可挽回的经济损失和安全事故。当开发者发现,为了追求所谓的“通用性”而引入的MCP,反而让自己的Agent变得像一个行为不可预测的“定时炸弹”时,他们自然会选择放弃。

最终,无法抑制的幻觉问题,成为压垮社区对MCP信心的最后一根稻草。 它让开发者认识到,在当前技术水平下,无限制地向模型暴露工具选项,是一条走不通的死路。

四、📈 理性的回归:从狂热追捧到务实改良

%20拷贝-dvko.jpg)

MCP的热度骤冷,标志着行业从“期望膨胀期”正式滑入“幻灭期”。但这并不意味着协议本身的彻底失败,而是社区对其定位和用法的一次集体纠偏。人们不再将MCP视为包治百病的“灵丹妙药”,而是开始将其作为一个基础选项,并在此之上探索更务实、更高效的工程范式。

4.1 共识的转变:从“银弹”到“地基”

行业的新共识正在形成。

MCP没有过时,是过度的期望过时了。它所解决的异构系统连接和接口标准化的痛点是真实存在的。它的价值在于提供了一个底层的、可选的通信规约,而非一个开箱即用的Agent应用框架。

MCP仍处于“工程化打磨期”。从协议本身到最佳实践,都需要至少一到两轮大的迭代升级,才能在成本、性能、可靠性之间找到一个可接受的平衡点。

4.2 新兴的工程范式:在约束中寻求效率

面对MCP的种种缺陷,一线开发者和架构师们已经探索出多种改良方案,其核心思想都是通过增加约束和引入中间层,来规避协议的短板。

4.2.1 动态与静态结合的工具管理

放弃将所有工具一次性加载到上下文的“暴力”做法,转而采用更精细化的管理策略。

核心工具常驻:将最常用、最核心的少数几个工具(通常不超过5-6个)定义为常驻上下文。

按需动态加载:构建一个工具检索层。当Agent需要执行特定任务时,先通过一个轻量级的模型或检索算法,从庞大的工具库中筛选出几个最相关的候选工具,再将这几个候选工具的定义动态加载到主模型的上下文中。

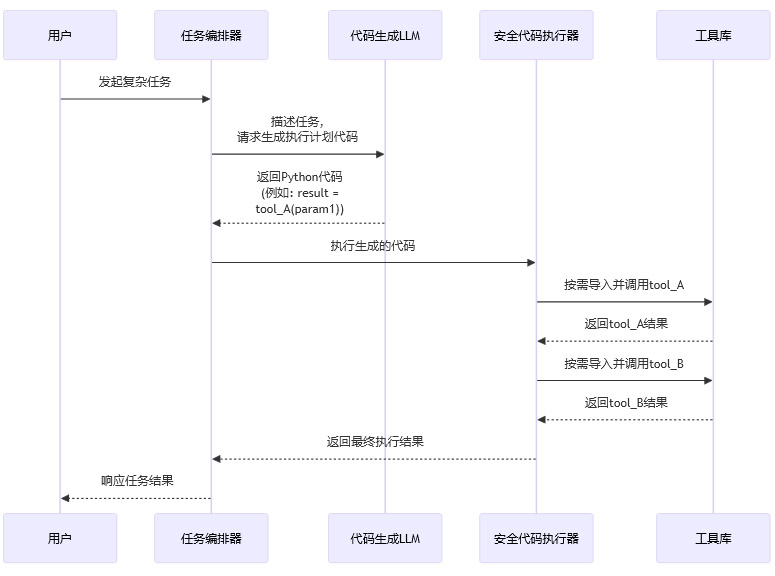

4.2.2 代码执行与协议的混合模式

这是一种更先进的范式,它将LLM的角色从“直接调用者”转变为“代码生成者”。

在这个模式中,MCP可以作为工具库内部的一种底层通信方式,但LLM本身不直接感知所有工具。它只负责生成调用这些工具的逻辑代码。这种方式的优势是。

极低的Token成本:上下文只包含任务描述,无需任何工具定义。

极高的灵活性:可以通过代码实现复杂的逻辑、循环、条件判断,能力远超简单的工具调用。

可控性更强:可以在代码执行器层面做严格的安全沙箱、权限校验和资源限制。

4.2.3 强化安全与治理层

社区认识到,不能将安全与治理的希望完全寄托于MCP协议本身。企业需要在MCP之上,自建或集成完善的配套设施。

细粒度权限控制:为每个Agent或用户配置精细的工具调用权限。

审计与日志追踪:记录每一次工具调用的完整链路,用于问题排查和合规审计。

数据脱敏与风控:在数据流经Agent时,自动进行敏感信息脱敏,并设置风险规则,防止危险操作。

结论

MCP从万众瞩目到归于沉寂的一年,是AI Agent技术从理想走向现实的缩影。它的“过气”,并非协议本身的失败,而是行业对“万能钥匙”幻想的破灭,以及对工程化落地复杂性的重新认识。

MCP确实抓住了AI生态对标准化的核心需求,但其初版设计在成本、稳定性、可靠性和部署复杂性上暴露了严重短板,尤其是在放大模型幻觉这一根本性问题上,使其难以承载生产级应用的重任。

今天,MCP本身不会消失。它正逐渐回归其应有的位置——成为AI技术栈中一个可选的、底层的通信协议,如同HTTP一样,低调但必要。开发者和企业已经不再盲目追逐“MCP”这个标签,而是开始务实地评估自身需求,将其作为众多技术选项之一,灵活地集成到更宏大、更健壮的AI应用架构中。

这场风波的真正价值在于,它以一种激烈的方式,为整个行业上了一堂关于AI基础设施建设的公开课。它告诉我们,任何一项成功的底层技术,都必须在通用性的理想与工程的现实之间,找到那个精妙的平衡点。AI Agent的大规模应用之路,依然道阻且长,而MCP的这段经历,无疑是这条路上一个极其宝贵的里程碑。

📢💻 【省心锐评】

MCP的故事警示我们,AI基建的成功,不在于叙事有多宏大,而在于工程细节有多扎实。从“万能接口”的幻想中醒来,务实地解决成本、稳定和可靠性问题,才是Agent走向实用的唯一路径。

.png)

评论