【摘要】AI 竞争范式已从模型能力转向全栈体系对决。企业 AI 落地正从项目尝鲜演变为系统工程,这要求基础设施必须具备从芯片到应用的端到端优化能力,全栈智能云成为必然选择。

引言

技术领域的叙事总在轮回,焦点从一个热点迁移至另一个。短短两年,人工智能(AI)的主战场就完成了一次深刻的范式转移。当人们的目光还聚焦于 GPT-4 与 Gemini 之间参数与性能的较量时,牌桌下的真正博弈早已转向。谷歌凭借其从 TPU 芯片、云计算平台到 Gemini 模型及应用的垂直整合能力,不仅在模型层面追平了代差,更在推理成本这一决定规模化落地的关键环节,对 OpenAI 形成了反向压力。

这一转变并非孤例,它揭示了一个更为根本的趋势。资本市场用行动做出了注解,当伯克希尔·哈撒韦这样的价值投资标杆历史性地建仓谷歌时,信号已经非常明确,市场押注的不再是单一的模型算法公司,而是那些能够提供完整、高效、可控的 AI 基础设施的科技巨头。AI 的价值实现,终究要从云端的 API 调用,沉淀到产业的业务流程中。

进入 2026 年,AI 落地将不再是“能否用上”的问题,而是“能否用好、用得起、用得稳”的系统性挑战。本文将从全球格局、技术内涵、落地门槛与市场实践等多个维度,深入剖析为何一朵真正的全栈智能云,是企业穿越 AI 规模化落地“无人区”的唯一路径。

一、全球格局演变:从模型 PK 到体系对抗

AI 领域的竞争,已经悄然告别了单纯比拼模型参数与评测分数的“上半场”。如今,决定胜负的关键,在于谁能构建一个从底层硬件到上层应用、高度协同的全栈技术体系。这个体系的效率、成本和稳定性,直接决定了 AI 技术能否从实验室走向广阔的产业应用。

1.1 谷歌的逆袭:一个全栈闭环的经典样本

回顾过去两年,谷歌与 OpenAI 的竞争轨迹极具启发性。当 ChatGPT 横空出世时,谷歌一度陷入被动。然而,局势的反转速度超乎想象。其制胜的关键,并不仅仅是 Gemini 2.5/3.0 模型在能力上的奋起直追,更在于其深耕多年的全栈技术布局开始兑现红利。

这个闭环体系的核心逻辑在于协同优化。

芯片与模型协同:自研的 TPU v6/v7 芯片在设计之初就充分考虑了自家模型的计算特性。这种底层硬件与上层算法的深度耦合,使得 Gemini 模型在训练和推理时能够获得极致的能效比。

云与成本协同:通过 Google Cloud Platform (GCP),谷歌将这种低成本、高效率的算力作为一种标准服务对外输出。这使得开发者和企业能够以更低的单位成本运行复杂的 AI 应用,直接解决了 AI 规模化最大的障碍——推理成本。

最终,谷歌实现了“能力追平”与“成本下降”的双重收益。这种体系化的优势,是单纯的模型公司难以企及的。OpenAI 纵然有先发优势,但在基础设施层面依然需要依赖外部云厂商,这在成本控制和系统优化上天然存在一道鸿沟。

1.2 资本的转向:押注确定性而非可能性

资本市场是最敏锐的观察者。从热捧纯粹的 AI 算法初创公司,到如今将资金重新聚焦于拥有深厚基础设施底蕴的科技巨头,反映了市场认知的一次重要迭代。AI 的商业化前景,最终取决于其落地的确定性。

这种确定性包含多个维度。

技术确定性:全栈厂商能够保证从硬件到软件的技术栈兼容性与稳定性,避免了多供应商集成带来的“技术债”。

成本确定性:通过端到端优化,能够提供可预测且持续优化的成本模型,便于企业进行长期预算规划。

服务确定性:能够提供从咨询、部署到运维的一站式服务,降低了企业使用 AI 的门槛。

伯克希尔建仓谷歌,正是对这种“确定性”的认可。聪明的资本不再为单一的技术“可能性”支付溢价,而是开始为能够将可能性转化为商业价值的“全栈能力”买单。

二、AI 超级周期:云计算基础设施的逻辑重写

随着 AI 应用的深化,全球云计算市场正迎来新一轮的超级增长周期。与上一轮由移动互联网驱动的增长不同,本轮周期的核心引擎是 AI,它正在从根本上重写云计算基础设施的底层逻辑。

2.1 增长新引擎:从“上云”到“上智能”

根据市场数据,中国公有云市场在经历短暂的增速放缓后,于 2025 年重拾接近 20% 的高增长。驱动力不再是简单的业务系统迁移上云,而是企业将 AI 深度嵌入核心流程的“上智能”需求。

这一轮增长呈现出两个显著特征。

推理算力需求的井喷:早期 AI 应用以训练为主,一次性投入巨大。现在,随着 AI 应用的普及,无时无刻不在发生的**推理(Inference)**成为了算力消耗的主体。特别是随着 DeepSeek R1、文心 X1 等深度思考模型(慢思考)和多模态应用的普及,单次推理任务涉及的计算量呈指数级增长。推理成本,而非训练成本,正成为新的瓶颈。

采购模式的系统性升级:企业对 AI 的采购,已从购买几个 API 接口进行小范围试点的“项目制”,全面升级为涵盖算力、平台、模型、工具和安全治理的“系统性部署”。企业需要的不再是零散的 AI 能力,而是一整套能够支撑其长期智能化战略的基础设施。

2.2 基础设施范式迁移:从“CPU 云”到“GPU + Agent 云”

AI 正在重塑云的形态。传统的云计算基础设施,其核心是围绕 CPU 构建的,主要解决的是信息的高效流通与存储,服务于企业 IT 系统的在线化。而新一代的 AI 云,其核心则转向了以 GPU、专用芯片(ASIC)和 Agent(智能体)为中心,目标是直接参与和创造业务价值。

我们可以通过一个简单的表格来对比这两种范式的差异。

这种范式迁移,要求云厂商必须构建起双轮驱动的新型基础设施。

AI Infra (算力与模型基础设施):提供从底层芯片、高速网络、超大规模集群到上层 AI 框架、模型开发与管理工具链的完整能力,解决 AI 的生产问题。

Agent Infra (智能体基础设施):提供一整套用于开发、部署、管理和协同 Agent 的平台与工具,解决 AI 的应用与执行问题。

只有同时具备这两种基础设施能力,才能称之为真正意义上的新一代 AI 云。

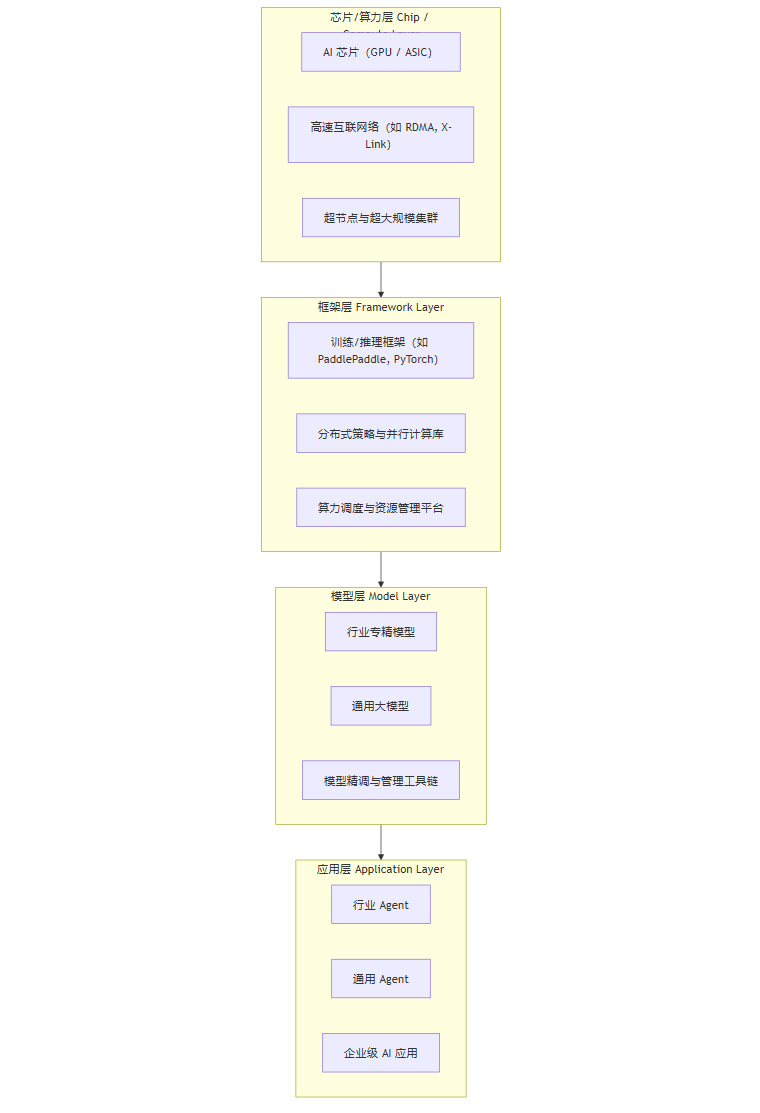

三、全栈智能云的技术内涵:打通四层架构

“全栈”一词源于软件开发,但在 AI 时代,它的内涵被重新定义和扩展。AI 时代的计算架构,已经从经典的“芯片—操作系统—应用”三层模型,演进为“芯片—框架—模型—应用”的全新四层架构。一朵合格的全栈智能云,必须在这四个层面都具备核心能力并实现垂直整合。

3.1 AI 时代的四层技术架构

我们可以用一张流程图来清晰地展示这个四层架构及其内在联系。

这四层架构环环相扣,每一层的效率都深刻影响着上一层。

芯片/算力层:这是所有计算的物理基础。除了芯片本身,如何通过高速网络将成千上万颗芯片高效地连接成一个整体,是这一层的核心技术壁垒。

框架层:这是连接硬件与算法的桥梁。它负责将上层的模型训练和推理任务,高效地翻译成底层硬件可以执行的指令,并进行大规模分布式调度。

模型层:这是 AI 智能的核心载体。除了提供强大的基础模型,更重要的是提供一整套工具链,让企业可以基于自身数据高效地训练、精调和管理专有模型。

应用层:这是 AI 价值的最终出口。通过 Agent 或 AI 原生应用的形式,将模型能力与具体的业务场景相结合,解决实际问题。

3.2 全栈的核心价值:端到端的确定性

构建并打通这四层架构,其最终目的,是为了实现端到端的优化。这种优化带来了三个至关重要的“可控性”,也是企业在生产环境中部署 AI 的基石。

性能可控:通过软硬件协同设计,可以针对特定的模型和应用场景进行深度优化,最大化计算效率,实现更高的吞吐量(Throughput)和更低的时延(Latency)。

成本可控:垂直整合减少了中间环节的性能损耗和利润叠加,使得云厂商能够以更低的总体拥有成本(TCO)提供服务。同时,统一的技术栈也降低了企业的开发和运维成本。

稳定性可控:在单一厂商提供的全栈环境中,技术兼容性问题被最大程度地规避。云厂商可以对整个系统进行端到端的监控、故障定位和修复,从而保障生产级应用所需的高可用性。

相比之下,企业如果自行选择不同厂商的芯片、框架、模型进行“堆叠式”集成,不仅会面临巨大的技术挑战和集成成本,更难以在性能、成本和稳定性之间找到最优解。

四、AI 规模化落地的三道核心门槛

理论上的架构优势,最终要体现在解决实际问题的能力上。企业在推动 AI 从试点走向规模化部署的过程中,通常会遇到三道难以逾越的技术门槛。而这三道门槛,恰恰是全栈智能云的核心能力所在。

4.1 算力层门槛:跨越“通信墙”与“稳定性墙”

当模型参数进入万亿级别,训练任务动辄需要上万张加速卡时,智算集群面临的挑战不再是单卡的计算能力,而是整个集群的协同效率。

通信墙 (Communication Wall):在万卡集群中,数据在不同计算卡之间的传输(即集合通信)耗时,往往会超过计算本身。如果网络带宽和拓扑结构设计不佳,大量的计算单元就会处于空闲等待状态,造成算力的巨大浪费。单纯堆砌硬件,而不优化通信,无异于用麻绳捆绑一群千里马。全栈厂商通过自研高速互联协议(如百度的 X-Link)和优化网络拓扑,能够将卡间通信带宽提升数倍,有效打破通信墙。

稳定性墙 (Stability Wall):拥有上万个节点的系统,其故障概率远高于小型集群。任何一个节点的硬件故障、软件 Bug 或网络抖动,都可能导致长达数周的训练任务中断,前功尽弃。全栈厂商通过自研的集群管理和调度平台(如百度的百舸平台),能够实现任务级的故障自动检测、快速恢复和断点续训,将集群的有效训练时长从行业普遍的 80% 提升至 95% 以上。这是保障大模型能够被稳定、高效地生产出来的工程基础。

4.2 模型层门槛:平衡“专业性”与“经济性”

通用大模型虽然能力强大,但在直接应用于垂直行业时,往往会遇到“水土不服”的问题。

博而不精:通用模型缺乏特定行业的专业知识(Domain Knowledge)、术语和业务逻辑,回答问题常常“隔靴搔痒”,无法满足专业场景的精度要求。

成本高昂:调用大型通用模型的成本不菲,对于高频、海量的业务请求,企业很快就会发现“算不过账”。

因此,模型层的关键在于提供一个兼具专业性与经济性的解决方案。全栈智能云通常采用模型矩阵策略来应对。

提供强大的旗舰基础模型:作为技术能力的基座。

推出轻量化和推理优化版本:针对高频推理场景,大幅降低调用成本。

构建行业专精模型:与行业龙头企业合作,将行业数据和知识融入模型,打造“小而精”的行业模型。例如,金融行业的风控模型、制造业的质检模型等。

提供完善的工具链:让企业能够以较低的成本,在通用模型基础上,利用自有数据进行高效微调(Fine-tuning),获得专属模型。

4.3 应用层门槛:让 Agent 从“会聊”到“会干”

Agent(智能体)被认为是 AI 落地的终极形态,但要让它真正接管企业的核心业务,必须解决三个关键的工程难题。

连接 (Connection):企业的价值数据和业务流程,沉淀在各种内部系统中,如 ERP、CRM、MES 等。Agent 必须能够安全、高效地与这些系统进行交互。全栈云厂商通过提供对 MCP (Machine Co-Processors) 等开放协议的全面兼容,并内置大量预置连接器,帮助企业快速打通内部的“数据孤岛”和“系统烟囱”。

编排 (Orchestration):真实的企业任务往往是复杂的、多步骤的。例如,处理一笔客户投诉可能需要查询订单系统、调用物流接口、生成退款申请并通知财务部门。Agent 平台必须提供强大的工作流编排能力,支持多 Agent 协同、条件判断、循环执行和异常处理,将简单的任务执行变为可靠的业务流程自动化。

安全 (Security):当 Agent 被授予操作生产系统的权限时,安全与合规就成为重中之重。全栈云平台需要提供一套完备的治理体系,包括精细化的权限管理、操作日志审计、风险行为监控和人机协同决策机制,确保 Agent 的所有行为都在可控、可追溯的范围内。

只有系统性地解决了这三层门槛,AI 才能真正从一个“聪明的聊天机器人”,进化为企业中“可靠的数字化员工”。

五、中国市场实践:头部玩家的系统性解法

将视线转回国内,中国市场的 AI 落地进程同样印证了全栈能力的重要性。面对复杂的业务场景和对自主可控的更高要求,以百度智能云、阿里云、华为云为代表的头部厂商,都在沿着全栈路径进行系统性布局,并给出了具体的工程化解法。

5.1 算力侧的硬核攻坚

在算力基础设施层面,国内头部云厂商早已超越了单纯的 GPU 资源集成商角色,转向更深层次的软硬协同创新。

自研芯片与节点优化:为了突破外部限制并追求极致性能,自研 AI 芯片成为必然选择。例如,百度推出的昆仑芯,通过设计**超节点(SuperNode)**架构,将多张加速卡与高速互联网络封装在一个高密度单元内,大幅提升了单节点的计算和通信效率。这种从芯片到节点的垂直优化,是构建高性能集群的基础。

自研互联协议:针对万卡集群的通信瓶颈,自研高速互联协议成为关键。通过在硬件层面实现 RDMA (Remote Direct Memory Access) 等技术,并结合软件层面的通信库优化,可以绕过传统的 TCP/IP 协议栈,实现纳秒级的跨节点数据传输,为大规模分布式训练扫清障碍。

智能化的集群管理平台:一个强大的集群操作系统是发挥万卡算力的“大脑”。国内厂商自研的调度平台(如百度的百舸),不仅能实现异构资源的统一管理和池化,更重要的是针对 MoE (Mixture of Experts) 等复杂模型结构,研发了专门的并行策略和容错机制。将有效训练时长提升至 95% 以上,这一指标直接反映了云厂商在超大规模 AI 计算领域的工程化成熟度。

5.2 模型侧的矩阵化布局

在模型服务上,国内厂商同样采取了务实的矩阵化策略,以满足不同行业、不同规模企业的差异化需求。

“旗舰 + 轻量 + 专精”模型组合:这一策略已成为行业标配。

旗舰模型(如文心系列、通义系列):作为技术实力的展示和高阶复杂任务的基础。

轻量化与推理优化版本:通过模型蒸馏、量化等技术,推出成本更低的推理专用版本,满足高并发、低时延的业务需求。

行业模型:联合金融、能源、制造、政务等领域的合作伙伴,共同打造深度融合行业知识的专精模型。这些模型虽然参数规模可能不大,但在特定领域的表现往往优于通用大模型。

开放的平台生态:除了自研模型,头部云厂商的平台也积极引入第三方的优秀模型(如 DeepSeek R1、Baichuan 等)。通过在平台层面对这些模型进行深度优化和适配,为企业提供更丰富的选择,同时利用平台的工程能力进一步降低其使用成本,实现平台与模型生态的双赢。

5.3 应用与 Agent 侧的生态构建

让 AI 从“能说会道”到“能干会做”,关键在于打通应用生态。

拥抱开放协议,连接企业内外:以 MCP 协议为例,国内云厂商迅速跟进并实现了全面兼容。这意味着企业可以方便地将已有的内部系统、SaaS 工具以及互联网上的公开服务,以标准化的方式接入到 Agent 平台,极大地扩展了 Agent 的能力边界。AI 不再是一个封闭的系统,而是企业数字化生态的连接器。

打造企业级 Agent 开发与运行平台:头部厂商提供的 Agent 平台(如百度智能云的千帆平台),已经超越了简单的原型验证工具。它提供了一整套覆盖 Agent 开发、调试、部署、监控和迭代的生命周期管理能力,并内置了完善的安全治理机制,让企业可以像管理软件应用一样,系统化地构建和运维海量的智能体。

六、市场选择与数据印证

市场的选择是检验技术路线正确性的最终标准。无论是市场份额数据,还是权威机构的评估,都清晰地指向一个结论:全栈 AI 云正在成为企业进行智能化转型的主流基础设施。

6.1 市场份额高度集中,马太效应凸显

根据赛迪顾问(CCID)等机构发布的数据,2025 年上半年,中国 AI 云全栈服务市场规模已接近 300 亿元,同比增速接近 200%。这是一个正在从早期概念验证走向规模化部署的爆发性市场。

更值得关注的是市场的集中度。百度智能云、阿里云、华为云三家厂商合计占据了超过八成的市场份额。这一现象背后,是深刻的产业逻辑:AI 基础设施是一个门槛极高、投入巨大的领域,只有具备全栈能力、能够提供系统性解决方案的厂商,才能赢得客户的信任。这解释了为什么“越全栈,越马太效应”。企业在选择 AI 合作伙伴时,倾向于选择能够提供长期、稳定、全面支持的头部厂商。

6.2 权威机构评估标准的演变

国际权威分析机构(如 Forrester)在其针对中国 AI 平台的评估报告中,也开始将“全栈平台能力”作为一个关键的评估维度。在其评估模型中,能够提供从底层 Infra、模型工具链到上层 Agent 平台和行业解决方案的厂商,被明确地放入“领导者”象限。这表明,全栈能力已经成为行业公认的衡量 AI 云服务商综合实力的核心标准。

七、企业视角:为何必须选择全栈而非堆叠?

站在企业决策者的角度,选择一朵全栈智能云,而非自行采购零散的 AI 能力进行堆叠,是一项基于成本、架构、安全和长期发展的战略性决策。

7.1 成本视角:TCO 的根本性差异

短期来看,直接调用某个模型的 API 似乎成本最低。但从总体拥有成本(TCO)来看,全栈云的优势是压倒性的。

显性成本:全栈厂商通过端到端优化,能在同样的算力资源下提供更高的性能和更低的单位推理成本。

隐性成本:企业自行集成的“堆叠式”方案,会产生巨大的集成成本、运维成本和技术债。不同厂商产品之间的兼容性问题、版本升级带来的连锁反应、多供应商管理的复杂性,都会在后期不断消耗企业的研发资源。

7.2 架构视角:避免未来的“技术孤岛”

AI 转型不是一次性的项目,而是一个持续演进的过程。从一开始就基于一个统一、开放的全栈平台来规划 AI 架构,可以避免未来陷入“技术孤岛”的困境。一个好的全栈平台,应该能够支持企业从最初的模型微调,到后续的 Agent 开发,再到未来接入更多新工具和新模型,整个过程平滑过渡,保护已有投资。

7.3 安全与合规视角:自主可控的唯一路径

对于金融、政务、能源、电信等关键信息基础设施行业,安全与合规是不可逾越的红线。在这些领域,对技术的自主可控有着极高的要求。只有全栈厂商,才有能力提供从底层芯片、操作系统到上层应用软件的完整国产化、信创兼容的解决方案,形成一个完整的技术和责任闭环,满足最严格的监管要求。

7.4 业务长期性视角:寻找“同行者”而非“供应商”

企业需要的,不仅仅是一个提供 API 的供应商,更是一个能够理解其业务、伴随其成长的“技术同行者”。全栈云厂商凭借其深厚的技术积累和丰富的行业实践,能够为企业提供持续的模型升级、工具迭代和架构演进建议,帮助企业在长期的智能化道路上保持竞争力。

结论

回到最初的问题:2026 年 AI 落地为何离不开全栈智能云?答案已经清晰。

AI 的规模化落地,本质上已经从一个单纯的“算法问题”,演变为一个复杂的“系统工程问题”。这个工程横跨了算力、模型和业务三大领域,充满了挑战。企业需要的不再是单点的技术能力,而是一个能够将这三者无缝整合、协同优化的强大基础设施。

全栈智能云,正是这一系统工程的最佳载体。它通过垂直整合“芯片—框架—模型—应用”四层架构,实现了性能、成本、稳定性和安全性的端到端可控。它为企业跨越 AI 落地过程中的算力、模型和应用三道门槛,提供了系统性的解决方案。

展望 2026 年,云厂商之间的竞争,重心将彻底从“谁的模型更便宜”,迁移到“谁能更深入产业,为客户带来可量化的业务价值”。在这个万亿级的新赛道上,只有那些真正具备全栈能力、能够成为企业长期“同行者”的云,才能最终胜出。对于身处智能化浪潮中的每一家企业而言,选择一朵对的全栈智能云,将不再是一个选项,而是决定未来十年核心竞争力的战略基石。

📢💻 【省心锐评】

AI 竞争已升维至全栈体系对抗。告别零散 API 调用,拥抱从芯片到应用的端到端优化,是企业在 2026 年实现 AI 价值闭环的唯一通路。选择全栈云,就是选择未来的确定性。

.png)

评论