【摘要】大模型正从云端算力竞赛转向端侧效能比拼。算力成本与数据隐私双重压力下,端侧AI凭借低延迟、高安全与成本效益,成为重塑产业格局、实现商业闭环的关键引擎。

引言

过去数年,人工智能领域的主旋律无疑是云端大模型的“军备竞赛”。参数量从百亿飙升至万亿,算力集群的规模不断刷新纪录,这股浪潮似乎在宣告一个简单粗暴的真理,即“越大越好”。然而,当技术发展触及产业应用的“深水区”,这套宏大叙事正面临严峻的现实挑战。高昂的推理成本、悬而未决的数据隐私问题以及物理定律限制下的网络延迟,共同构成了云端大模型规模化落地的“三座大山”。

行业的发展逻辑正在发生深刻的偏转。竞争的焦点,正从模型参数的绝对规模,悄然转向模型在真实场景中的应用效能、成本效益与用户体验。在这一背景下,端侧AI(On-device AI),即在智能手机、个人电脑、汽车座舱、物联网设备等终端上直接运行AI模型的技术范式,正从一个边缘概念迅速跃升为产业与资本共同瞩目的核心赛道。它并非对云端大模型的全盘否定,而是一场必要的进化,旨在将AI能力从遥远的云端数据中心,真正交付到用户触手可及的“最后一公里”。这场由算力经济学和数据主权意识双重驱动的变革,正在为大模型开启一个全新的纪元。

一、范式转移的必然:云端模型的边界与端侧AI的破局

%20拷贝.jpg)

任何技术范式的演进,其根本动因都源于旧范式在特定发展阶段暴露出的内在矛盾。云端大模型在经历了爆发式增长后,其固有的局限性愈发凸显,为端侧AI的崛起铺平了道路。

1.1 云端巨兽的“三重枷锁”

云端集中式AI服务虽然在模型训练和能力上限上具备优势,但在规模化推理应用阶段,却被三副沉重的枷锁牢牢束缚。

1.1.1 算力成本的指数级困境

大模型的运行成本主要分为训练(Training)和推理(Inference)两部分。训练是一次性的高昂投入,而推理则是持续性的运营支出。随着用户量和调用频率的增加,推理成本会呈线性甚至超线性增长。对于大多数企业而言,长期依赖云端API提供服务,意味着一笔无底洞式的开销。这种“越用越贵”的经济模型,极大地限制了AI应用的普及,将众多中小企业和开发者挡在了高昂的门槛之外。它导致了一个普遍的困境,即许多AI应用“叫好不叫座”,用户活跃度越高,企业的亏损可能越严重。

1.1.2 数据隐私的“达摩克利斯之剑”

在云端模型的工作流中,用户数据必须上传至服务器进行处理。这一过程天然存在数据泄露、滥用和被监控的风险。随着全球范围内数据安全法规(如GDPR)的日趋严格,以及用户隐私意识的普遍觉醒,数据合规性已成为企业不可逾越的红线。对于金融、医疗、司法、政务等高度敏感的行业,将核心数据交由第三方云服务处理,几乎是不可接受的。数据主权问题,如同一柄悬在头顶的达摩克利斯之剑,时刻警示着云端AI服务的边界。

1.1.3 体验延迟的“最后一公里”难题

用户体验的即时性是许多应用成功的关键。云端AI服务受制于网络通信,数据往返于终端和服务器之间,不可避免地会产生延迟。即便在5G网络环境下,几十到几百毫秒的延迟在某些场景下依然是致命的。例如,在实时语音交互、AR眼镜的环境感知、自动驾驶的应急决策等场景中,任何可感知的延迟都会严重破坏用户体验,甚至引发安全问题。此外,对网络的强依赖性也意味着,在信号不佳或离线环境中,这些所谓的“智能”设备将瞬间“失能”。

1.2 端侧AI的精准破局

端侧AI的崛起,正是对上述三大困境的直接回应。它通过将计算任务从云端迁移至本地,提供了一套全新的解题思路。

这种模式的转变,并非简单的计算地点迁移,而是对AI服务交付模式、成本结构和用户关系的根本性重塑。它将AI从一种遥远的、按次计费的“公共服务”,转变为一种内嵌于设备的、始终在线的“私有能力”。

二、技术内核解析:端侧AI的实现栈与架构演进

实现高效的端侧AI,绝非简单地将云端模型直接“搬到”终端设备上。它要求在模型、芯片、系统和工程化等多个层面进行系统性的技术创新与协同优化,形成一个高度整合的技术栈。

2.1 价值重估:从“小”模型到“近”智能

长期以来,业界对端侧模型存在一种误解,认为它只是云端大模型的“阉割版”或“青春版”。然而,端侧AI的核心价值并非在于追求与云端模型同等的通用能力,而在于利用其“贴近用户”的物理特性,提供云端无法比拟的特定价值。

2.1.1 物理邻近性带来的体验革命

“近”意味着极致的响应速度。当用户发出语音指令,或摄像头捕捉到需要识别的物体时,模型在本地瞬间完成计算并返回结果,这种无缝的交互体验是云端模型难以企及的。同时,“近”也意味着离线可用性,在飞机、地下室或偏远地区,智能设备的核心功能依然能够正常工作,这极大地增强了产品的可靠性。更重要的是,“近”带来了深度个性化的可能。模型可以在设备上持续学习用户个人的习惯、偏好和数据,形成一个真正懂你的“私人助理”,而这一切都无需将敏感的个人信息上传。

2.1.2 数据主权回归用户

端侧AI的计算模式,让“数据所有权”从一个法律概念,转变为一个技术现实。用户的照片、聊天记录、健康数据、行为习惯等信息,都可以在设备内部被模型理解和使用,而无需离开用户的物理掌控范围。这不仅解决了合规问题,更从根本上重建了用户对智能设备的信任。

2.1.3 经济模型的根本性重塑

端侧AI将AI能力的成本,从持续的运营支出(OPEX)转变为一次性的资本支出(CAPEX),即内嵌在硬件中的成本。对于开发者和企业而言,这意味着一旦应用部署出去,后续的推理服务便不再产生持续的费用。这种可预测的、可控的成本结构,极大地促进了AI功能的普惠化,使得开发者可以更大胆地在应用中集成复杂的AI功能,而不必担心因用户增长而导致破产。

2.2 技术实现栈的挑战与演进

要在资源受限的终端设备上运行复杂的AI模型,需要一个协同工作的技术栈,其核心在于“极致的效率”。

2.2.1 模型轻量化技术矩阵

这是端侧AI的起点。目标是在尽可能保留模型核心能力的前提下,大幅压缩其尺寸和计算量。主流技术包括:

以面壁智能的MiniCPM系列为例,它正是综合运用了上述多种技术,才得以在仅有数十亿参数的规模下,实现了可与更大模型媲美的多模态能力,并成功部署于终端设备。

2.2.2 异构计算与硬件加速

软件层面的优化需要硬件层面的支撑才能发挥最大效能。现代终端芯片早已不是单纯的CPU,而是集成了CPU、GPU、NPU(神经网络处理单元)、DSP(数字信号处理器)等多种计算单元的异构系统(SoC)。

数据处理架构正在经历一场深刻的变革,从过去**“CPU为中心”的通用计算,转向“NPU/AI专用芯片为中心”的AI计算**。NPU专门为神经网络中的大规模并行计算(如矩阵乘法、卷积)而设计,其能效比远超CPU和GPU。ARM和RISC-V等开放指令集架构,也为厂商设计定制化的AI加速核心提供了灵活性。未来的竞争,将是模型算法与底层硬件架构的深度耦合与协同设计。一个优秀的端侧AI解决方案,必须能够智能地将模型的不同算子调度到最适合的硬件单元上执行,实现全局能效最优化。

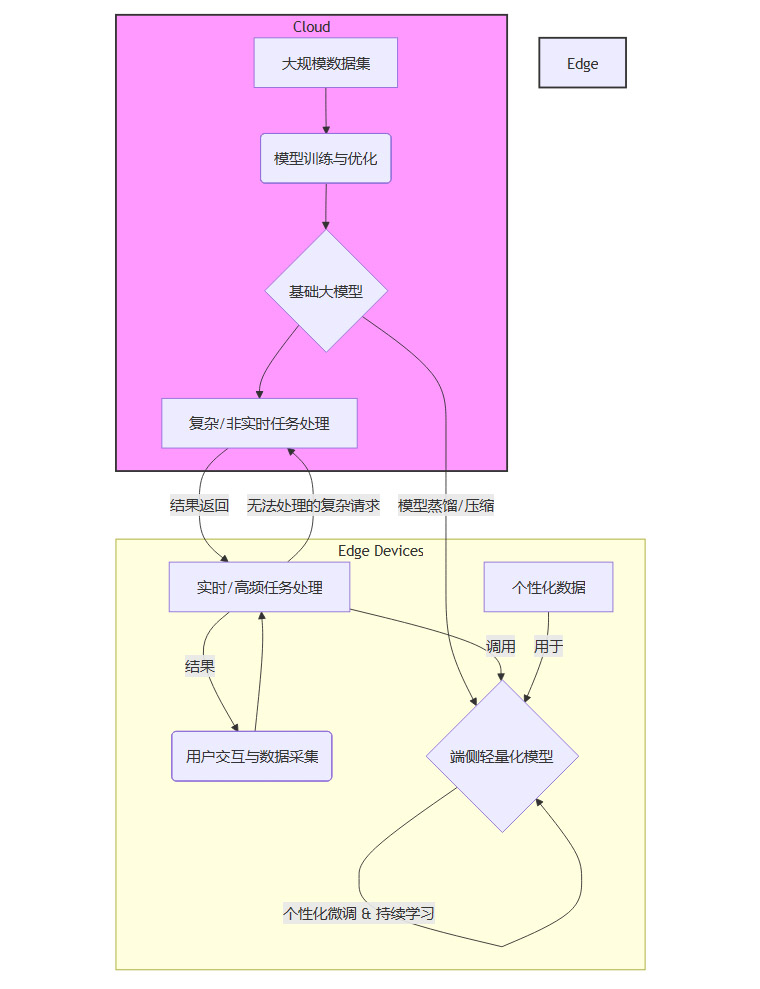

2.2.3 端云协同的混合式架构

端侧AI并非要完全取代云端。最理想的架构是一种端云协同(Edge-Cloud Collaboration)的混合模式,它兼顾了双方的优势,形成一个有机的整体。

在这个架构中:

云端:负责“重”任务。利用其强大的算力进行大规模模型的训练、蒸馏和定期更新。同时,处理那些端侧无法承载的、对实时性要求不高的复杂计算请求。

端侧:负责“轻”和“快”的任务。部署经过优化的轻量化模型,处理绝大多数高频、实时的用户交互。利用本地数据进行个性化微调,让模型越来越适应特定用户。

这种“云端训练、端侧推理、按需协同”的模式,既保证了模型能力的持续进化,又提供了极致的用户体验和隐私保护,被认为是未来AI应用的主流架构。

三、产业落地与商业闭环:从技术愿景到市场价值

%20拷贝.jpg)

一项技术能否引发产业变革,最终取决于其能否找到清晰的商业化路径并构建可持续的商业闭环。端侧AI在这方面的优势正逐渐显现,吸引了大量资本的关注。

3.1 资本的嗅觉:“真金白银”流向确定性赛道

资本市场正在对AI赛道进行结构性重估。单纯讲述“模型能力强大”的故事已经不足以打动投资者,可规模化、可盈利的商业模式成为新的评估核心。端侧AI恰好满足了这一要求。

以面壁智能为例,其在2024年以来密集完成多轮融资,投资方不乏华为哈勃、保时捷等产业资本巨头。这背后传递出一个清晰的信号,即资本不再仅仅关注算法本身,而是更加看重技术与产业场景的深度绑定能力。端侧AI由于其部署在具体硬件上的特性,天然与终端产业(汽车、手机、PC、智能家居等)紧密结合,其商业价值链条更短,也更清晰。资本的涌入,正在加速端侧AI从技术研发到产业化落地的进程。

3.2 场景为王:端侧AI的典型应用版图

端侧AI的商业化并非空谈,它已经在多个关键领域找到了具体的应用场景,并开始创造实际价值。

这些场景的共同特点是,它们都对实时性、隐私性或网络稳定性有着刚性需求,而这些恰恰是端侧AI的核心优势所在。

3.3 商业模式的重构

与云端API按次或按Token计费的模式不同,端侧AI催生了更多样化、更贴近硬件产业逻辑的商业模式。

3.3.1 硬件预装与授权费(Licensing Fee)

这是最直接的模式。AI模型作为核心功能组件,被预装在芯片或终端设备中。模型提供商向芯片或设备厂商收取一次性的技术授权费,或按出货量进行分润。这种模式收入稳定且可预测,与硬件产业的商业惯例完美契合。

3.3.2 增值服务与订阅制(Value-added Services & Subscription)

在提供基础的端侧AI能力之上,厂商可以通过云端提供更高级的功能或定期模型更新,并以此向用户收取订阅费。例如,本地AI助手可以免费使用基础功能,但更专业的知识库查询或多模态创作能力则需要付费订阅。这形成了一种**“基础免费,高级收费”**的混合模式。

3.3.3 行业解决方案定制

针对特定行业(如汽车、金融、医疗)的特殊需求,提供深度定制的端侧AI解决方案。这包括模型定制、软硬件协同优化以及后续的技术支持服务。这种模式客单价高,客户粘性强,能够建立深厚的行业壁垒。

这些商业模式的清晰化,使得端侧AI不再是一个“烧钱”的技术探索,而是一个能够自我造血、健康发展的产业方向。

四、重塑格局:从参数竞赛到生态之战

%20拷贝.jpg)

端侧AI的崛起,不仅是一次技术路线的迭代,更是一场对整个AI产业竞争格局的深刻重塑。竞争的焦点正从单一维度的技术指标比拼,转向一场围绕场景、软硬件协同和开发者生态的立体化战争。

4.1 竞争维度的升维

过去,评价一个AI模型的好坏,往往简化为几个关键指标,如参数量、在特定Benchmark上的得分等。这是一种典型的“技术竞赛”思维。然而,端侧AI的出现,迫使行业重新思考“好”的定义。

4.1.1 从“模型为中心”到“场景为中心”

在端侧,一个模型是否优秀,不再仅仅取决于其通用知识的广度,而更多地取决于其在特定场景下解决实际问题的效率和效果。一个在汽车座舱内能做到毫秒级响应、精准理解驾乘人员模糊指令的10亿参数模型,其价值远超一个需要数秒网络延迟才能返回答案的万亿参数云端模型。**“场景定义模型”**成为新的黄金法则。这意味着模型厂商必须深入理解垂直行业的需求,进行场景化的数据收集、模型训练和微调。

4.1.2 从“算法领先”到“系统最优”

端侧AI的性能是算法、软件、硬件三者协同作用的结果。一个再高效的模型,如果运行在一个未经优化的系统或不匹配的硬件上,也无法发挥其全部潜力。因此,竞争不再是单纯的算法团队之间的较量,而是扩展到了整个技术栈的整合能力。这要求AI公司具备全栈优化的视野和能力,能够与芯片厂商、操作系统厂商和设备制造商进行深度合作,共同打磨从底层硬件指令集到上层应用框架的每一个环节。

4.2 生态构建成为新的护城河

当技术本身逐渐趋同,构建一个繁荣的开发者生态系统,便成为赢得长期竞争的关键。谁能吸引更多的开发者基于其平台进行创新,谁就能掌握定义未来的主动权。

4.2.1 降低开发门槛,赋能百万开发者

端侧AI的普及,离不开简单易用的开发工具链。这包括高效的模型转换工具、跨平台的推理引擎、丰富的API接口以及详尽的开发文档。目标是让广大应用开发者,即使不具备深厚的AI背景,也能轻松地将端侧AI能力集成到自己的产品中。一个活跃的开发者社区,不仅能催生出海量的创新应用,还能反向为主平台贡献宝贵的反馈和代码,形成正向循环。

4.2.2 抢占关键终端,构筑平台壁垒

智能手机、PC、汽车等关键智能终端,是端侧AI落地的主要载体,也是构建生态的核心入口。一旦某个端侧AI平台在这些主流设备上形成事实上的标准,就会产生强大的网络效应。开发者会优先为其进行适配,从而吸引更多用户,用户又会反过来吸引更多开发者,形成难以逾越的生态壁垒。这正是苹果、谷歌等巨头不遗余力地构建其端侧AI框架(如Core ML, TensorFlow Lite)的根本原因。

4.3 产业链的连锁反应与价值重构

端侧AI的兴起,正在对整个ICT(信息与通信技术)产业链产生深远影响,引发新一轮的价值链重构。

这场变革的核心,是算力的去中心化和智能的普惠化。AI能力正从少数云巨头垄断的资源,逐渐“飞入寻常百姓家”,成为每个智能设备的基础能力。在这个过程中,产业链的价值分配也将发生转移,那些能够提供高效端侧AI解决方案、掌握核心场景和生态的公司,将在新的格局中占据更有利的位置。

结论

大模型的发展正站在一个关键的十字路口。告别单纯追求规模的“云端巨兽”叙事,转向更加务实、更可持续的端侧AI范式,已非一种选择,而是一种必然。这场由算力成本和数据隐私双重力量驱动的深刻变革,正在从根本上改写AI技术的实现路径、商业模式和产业格局。

端侧AI的核心价值,不在于“小”,而在于“近”。它通过将智能部署在距离用户最近的地方,完美解决了云端模型在成本、隐私和体验上的三大痛点,为AI的规模化落地扫清了最后的障碍。从技术栈的深度优化,到商业闭环的清晰构建,再到产业生态的全面重塑,端侧AI展现出了强大的生命力和广阔的前景。

未来,一个端云协同、多层次的AI生态将成为主流。云端作为“大脑”,负责知识的训练与进化;端侧作为“神经末梢”,负责实时的感知与交互。这场新纪元的开启,不仅为面壁智能这样的创新企业提供了历史性的机遇,也为整个ICT产业链的参与者带来了全新的挑战与想象空间。最终,它将推动AI从一项高高在上的前沿科技,真正融入我们生产和生活的每一个角落,成为一种无处不在、人人可及的赋能力量。

📢💻 【省心锐评】

大模型正从“云端算力秀”转向“端侧实用战”。成本、隐私和体验是硬道理,谁能将AI高效部署到用户设备,谁就掌握了商业化的钥匙。端侧AI不是选择题,而是必答题。

.png)

%20%E6%8B%B7%E8%B4%9D.jpg)

评论