【摘要】前Rancher团队以“容器化”理念打造MCP控制平面,种子轮融资3500万美金,旨在通过开源网关和Agent框架,让企业像管理K8s一样,安全、可控地规模化部署和治理AI Agent。

引言

当行业还在争论AI Agent该怎么落地时,有人已经把它当成“容器”来管理。三位前Kubernetes维护者创立的MCP基础设施公司,种子轮就轰下3500万美金。他们给出的答案简单粗暴,把大模型、插件、记忆、权限全部抽象成可编排的“Agent Pod”。一条YAML指令就能让成千上万个Agent同时上线、热更新、弹性扩缩,像管理Docker一样管理数字员工。

企业使用AI的方式正在发生根本性变化。当越来越多的公司开始将AI从实验室搬到生产环境时,一个关键问题浮出水面,如何管理、保护和治理这些复杂的AI工具、agent和数据交互网络?这不是一个小问题,而是关乎企业AI战略能否成功落地的核心挑战。

最近一个现象引起了我的注意。模型上下文协议(Model Context Protocol,MCP)正在快速成为AI工具与企业应用连接的标准。但大多数企业在实际部署时都面临着相同的困境,即安全性、治理和可见性问题。就在这样的背景下,一家名为Obot AI的公司刚刚完成了3500万美元的种子轮融资,由Mayfield Fund和Nexus Venture Partners共同领投。他们要解决的正是这个让无数企业CIO夜不能寐的问题,如何让MCP在企业环境中安全、可控地大规模部署。

这笔融资的意义远超金额本身。它标志着投资界对企业级AI基础设施需求的深度认可。更重要的是,它预示着我们正站在企业AI应用范式转变的关键节点。从Obot AI创始人的背景来看,这绝非偶然。CEO Sheng Liang和他的团队此前曾创立了Rancher Labs(被SUSE收购)和Cloud.com(被Citrix收购)。这两家公司都在各自领域重新定义了企业采用开源平台的方式。现在,他们将同样的思路和经验应用到AI领域,试图为企业AI的规模化部署提供标准化的基础设施。

一、📈 MCP协议的崛起与企业级挑战

%20拷贝.jpg)

要理解Obot AI解决的问题,首先需要明白MCP协议为什么如此重要,以及企业在采用它时面临哪些实际困难。

1.1 MCP是什么?AI领域的“USB-C接口”

Model Context Protocol,简称MCP,是由Anthropic公司推出的一项开放标准。它的核心目标是为大型语言模型(LLM)与外部世界(包括各种应用、系统和数据源)的交互,建立一个统一的、标准化的连接规范。

我们可以把它想象成AI领域的“USB-C接口”。在USB-C出现之前,我们有各种各样的接口,USB-A、Micro-USB、HDMI、Thunderbolt,每种设备都需要特定的线缆和适配器,混乱不堪。USB-C的出现统一了这一切,一个接口就能搞定数据传输、充电和视频输出。

MCP在AI世界里扮演着类似的角色。在它之前,让LLM调用外部工具,通常依赖于特定厂商的私有方案,比如OpenAI的Function Calling。每个模型或平台都有自己的一套规则,开发者需要为不同的模型编写不同的适配代码,集成成本很高。

MCP的出现改变了这一局面。它提供了一套标准化的协议,让任何LLM都可以通过同样的方式发现和调用外部工具。这使得“乐高式”的AI应用开发成为可能,开发者可以像拼搭乐高积木一样,自由组合不同的模型和工具,而不用关心底层的连接细节。

MCP协议的核心特性可以总结如下:

随着MCP生态的成熟,越来越多的主流平台开始拥抱这一标准。微软Azure的AI服务、WPS的开放平台,甚至OpenAI的Agent SDK也开始提供对MCP的原生支持。这进一步加速了MCP成为行业事实标准的进程。对于企业而言,这意味着可以更简单地将内部的ERP、CRM、数据库等系统通过MCP服务器暴露给AI Agent,从而提升数据利用效率和业务流程自动化水平。

1.2 生态繁荣背后的管理阴影

技术的易用性是一把双刃剑。当开发者发现编写一个MCP服务器是如此简单,甚至“一周内就能创建上千个”时,企业IT和安全部门的噩梦就开始了。就像早期的Docker容器化浪潮一样,技术的普及速度远远超过了管理工具的成熟速度,混乱随之而来。

我之前在一个大型企业担任技术顾问时,亲眼见过这种混乱。市场部用一个开源模型搭建了一个分析竞品动态的Agent,研发部用另一个模型做了个代码审查的Agent,财务部又外包开发了一个处理报销的Agent。每个团队都认为自己的方案最好,结果是:

IT部门完全失控:他们根本不知道公司内部到底运行着多少个AI应用,这些应用连接了哪些数据,消耗了多少计算资源。

权限管理一团糟:有些团队用SharePoint文档来共享MCP服务器的访问地址和密钥;有些团队更原始,直接用Excel表格来记录哪个员工可以使用哪个AI工具。

安全隐患丛生:一个配置错误的Agent,可能就会把整个客户数据库的访问权限暴露在公网上。一个未经审计的第三方工具,可能在后台悄悄收集公司的敏感数据。

这种状况不仅效率低下,更是巨大的安全黑洞。当越来越多的应用开始支持MCP接口,当成百上千的MCP服务器在企业的各个角落涌现时,一个全新的、系统性的管理挑战摆在了所有CIO面前。

1.3 企业面临的四大核心困境

我们将这种挑战归纳为四大核心困境,它们共同构成了企业在规模化部署AI Agent时必须跨越的鸿沟。

这些问题相互交织,形成了一个复杂的管理迷宫。企业迫切需要一个统一的控制平面,一个能够驾驭MCP生态复杂性的“AI版Kubernetes”。这正是Obot AI切入的市场空白。

二、💡 Obot AI的技术创新与产品体系

面对MCP带来的企业级挑战,Obot AI的创始团队展现了他们从Rancher和Cloud.com时代就积累下来的深厚功力。他们的方法既务实又有前瞻性,不试图重新发明MCP协议,而是在现有标准之上,构建一套完整的企业级管理体系。

2.1 核心理念:不造轮子,只造“高速公路”

Obot AI的团队深知,与一个正在快速成为行业标准的开源协议对抗是徒劳的。正确的做法是拥抱它、增强它。他们的愿景是成为MCP的企业控制平面(Enterprise Control Plane),就像Rancher为Kubernetes所做的那样。

Kubernetes本身很强大,但直接在生产环境中使用原生K8s对很多企业来说门槛很高。Rancher提供了一个直观的管理界面和一套企业级功能(如多集群管理、统一认证、应用商店),极大地降低了K8s的采用门槛,从而获得了巨大成功。

Obot AI正在将同样的剧本应用到AI领域。他们假设MCP就是未来的“容器运行时”,而他们要做的,就是提供管理这些“AI容器”所需的一切基础设施,包括服务发现、安全策略、访问控制、审计日志和开发者工具。他们不生产AI Agent,而是为AI Agent的规模化运行铺平道路。

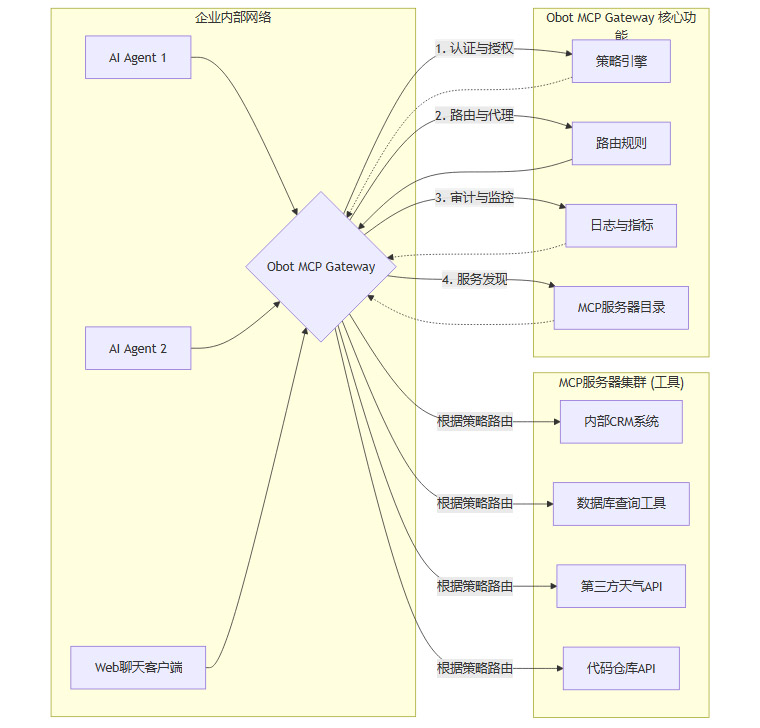

2.2 Obot MCP Gateway:企业级控制平面

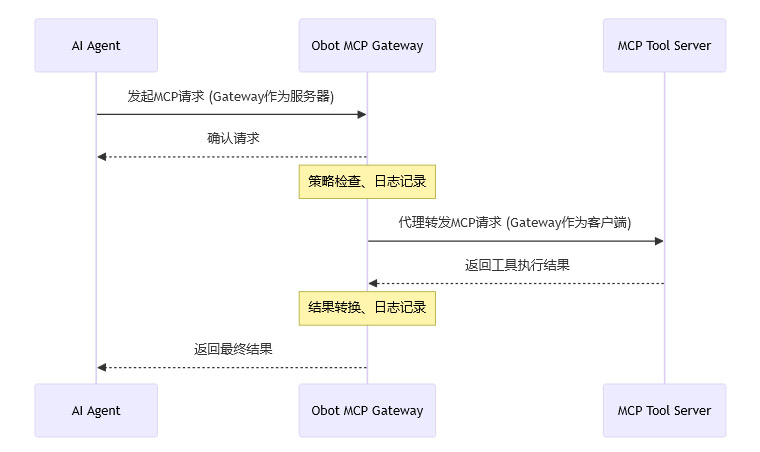

Obot AI解决方案的核心是Obot MCP Gateway。这是一个开源的代理网关,它像一个智能交通枢纽,坐落在所有AI Agent(客户端)和MCP服务器(工具)之间。

这种代理模式的设计极为精妙,它天然地解决了前面提到的许多管理难题:

单一控制点:所有与MCP服务器的通信都必须通过Gateway进行代理。这意味着IT部门有了一个单一的、强制性的关口来审计、记录和应用安全策略。“影子AI”的可能性被极大降低,因为任何未经注册的MCP服务器都无法被Gateway代理,从而无法被企业内的Agent访问。

解耦与抽象:Agent不再需要知道MCP服务器的具体地址或认证凭据。它们只需要与Gateway通信,Gateway会负责处理后续的路由和认证。这简化了Agent的开发,也使得后台的MCP服务器可以被轻松地替换、更新或迁移,而无需修改Agent代码。

Obot MCP Gateway提供的具体功能非常贴合企业需求:

2.3 赋能开发者与用户:从命令行到聊天界面

一个优秀的基础设施平台,不仅要功能强大,更要好用。Obot AI显然深谙此道,他们在用户体验和开发者体验上投入了大量精力。

对于普通员工(用户)而言,他们不再需要面对一堆复杂的服务器地址和API文档。他们可以访问一个可信的企业授权MCP目录,这就像一个企业内部的“AI工具应用商店”。他们可以轻松地浏览、搜索公司批准使用的各种AI能力,并了解每个工具的功能和使用范围。

更进一步,Obot平台集成了一个基于Web的聊天客户端。用户可以在这个安全的环境中,直接与一个或多个MCP交互。他们可以像与人对话一样,调用工具完成任务。例如,一个销售人员可以这样说:

“帮我查询一下上个季度‘A客户’的所有订单,并总结成一份报告,然后查询一下‘A客户’所在城市未来三天的天气,看看是否适合出差拜访。”

在这个简单的指令背后,AI Agent通过Obot Gateway,可能依次调用了CRM系统的MCP、报告生成工具的MCP以及天气查询API的MCP。用户无需关心底层的复杂工作流,所有交互都在一个统一、安全、可被审计的界面中完成。这种体验将AI Agent从开发者的玩具,真正变成了业务人员的生产力工具。

对于管理员来说,平台提供了一个全面的管理界面,可以进行:

目录管理:审核、发布、更新和下线企业目录中的MCP服务器。

访问控制:通过图形化界面定义和修改谁可以访问什么工具的策略。

日志追踪:查询和分析所有通过网关的交互日志,用于故障排查和合规审计。

用户管理:管理平台用户及其角色和权限。

2.4 Nanobot框架:构建原生MCP Agent的“运行时+SDK”

如果说Obot MCP Gateway是为AI Agent铺设的“高速公路系统”,那么Nanobot MCP Agent Framework就是制造“高性能赛车”的工具箱。它是Obot AI产品体系的另一大支柱,一个专为开发者设计的开源框架,提供了构建强大、MCP原生AI Agent所需的“运行时+SDK”。

Nanobot框架的核心创新在于它完全拥抱MCP + MCP-UI。这意味着通过Nanobot构建的Agent,不仅能返回文本或JSON数据,还能直接在聊天环境中渲染丰富的用户界面(UI)组件。

想象一下,当一个Agent需要用户从多个选项中进行选择时,它不再是返回一段笨拙的文本“请输入1、2或3”,而是可以直接在聊天窗口中弹出一个交互式的选择列表。当Agent生成一份图表时,它可以直接显示图表本身,而不是一个冷冰冰的图片链接。

Nanobot框架的出现,可以说是Agent开发者的一个游戏规则改变者。它让在企业环境中创建复杂的、交互式的AI Agent变得真正实用且可扩展。

2.5 技术深度:自研Go语言实现背后的考量

在深入研究Obot AI的技术方案时,一个细节引起了我的注意。他们没有直接使用市面上已有的MCP SDK,而是从头构建了自己的Go语言MCP实现。

这背后是深刻的技术考量。Obot团队在构建Gateway代理功能时,遇到了一个有趣的挑战。Gateway需要扮演一个双重角色:对于上游的AI Agent客户端来说,它是一个MCP服务器;而对于下游的真实MCP工具服务器来说,它又是一个MCP客户端。

他们发现,当时现有的所有MCP SDK,要么是为编写纯粹的服务器设计的,要么是为编写纯粹的客户端设计的,没有一个能够很好地支持这种位于中间的、既是服务器又是客户端的复杂代理模式。

为了实现一个高性能、高可靠性的企业级网关,他们别无选择,只能深入到MCP协议的每一个细节,自己动手造轮子。这个过程让他们遇到了各种“有趣和奇怪的用例”,也迫使他们成为了MCP协议本身最顶尖的专家之一。

这种深度的技术投入,确保了Obot的解决方案能够处理真实企业环境中可能出现的各种复杂情况和边缘案例。 这也正是他们能够获得顶级投资者青睐的重要原因之一。它证明了Obot AI不是一个只停留在概念层面的“PPT公司”,而是一个拥有硬核工程能力的团队,他们有能力构建出真正稳定、可靠的企业级基础设施。

三、🌳 行业生态与开源策略

%20拷贝.jpg)

Obot AI的成功,离不开其对开源的深刻理解和坚定执行。在企业软件领域,尤其是在基础设施层面,开源不仅仅是一种技术选择,更是一种深思熟虑的市场策略和生态建设手段。

3.1 开源:降低门槛,建立信任

Obot AI从第一天起就将其核心产品Obot MCP Gateway开源。这一决策带来了多重战略优势。

首先,开源极大地降低了企业的采用门槛。任何企业或开发者都可以自由地下载、部署和试用Obot Gateway,而无需支付任何许可费用或经过繁琐的商务流程。这对于那些希望快速验证MCP管理方案,但预算有限或流程复杂的组织来说,具有极大的吸引力。

其次,开源解决了企业对“供应商锁定”的普遍担忧。我见过很多大型企业,特别是金融、政府等高度重视自主可控的行业,因为担心被单一供应商绑定而拒绝采用技术上非常优秀的闭源解决方案。开源策略有效地消除了这种担忧。企业拥有代码的完全控制权,可以根据自身需求进行修改和二次开发,即使Obot AI公司未来出现经营问题,他们已经部署的系统仍然可以继续运行和维护。

再者,开源是建立技术信任的最佳方式。代码是公开的,任何安全研究员或开发者都可以审查其实现,这比任何市场宣传或安全认证都更有说服力。对于一个处理企业所有AI流量的网关产品来说,这种透明度至关重要。

3.2 从Rancher到Obot:开源商业化的成功经验

Obot AI的创始团队在开源商业化方面拥有丰富的成功经验。他们之前创立的Rancher Labs,就是通过开源的容器管理平台Rancher,在Kubernetes生态中占据了关键位置,并最终成功被SUSE收购。

他们深知如何在开源和商业成功之间找到完美的平衡点。其商业模式很可能沿用已经在Red Hat、MongoDB、Rancher等公司身上得到验证的“开源核心+商业增值”模式。

创始人Sheng Liang的观点非常务实:“开源在我们的DNA中。我们只是希望人们能够非常容易地获取、试用,无论是在本地运行还是在Kubernetes集群中运行,无论什么方式对你有效。”这种态度体现了一个成熟开源公司的特征,不是为了开源而开源,而是为了更好地服务用户和市场,最终通过创造价值来实现商业回报。

3.3 共建MCP生态:从贡献者到领导者

Obot AI的开源策略并不仅限于自身产品。他们积极地为整个MCP生态系统做出贡献。例如,他们维护着一个官方的MCP服务器目录,这个目录本身也是开源的,任何人都可以提交和分享有用的MCP工具。

这种做法一举多得:

提升社区地位:通过维护公共资源,Obot AI自然而然地成为了社区的中心节点之一,提升了其在开发者心中的品牌形象和技术权威性。

加速生态发展:一个丰富、活跃的工具目录,能够吸引更多的开发者和用户进入MCP生态,从而做大整个市场的蛋糕。

获取市场洞察:通过观察社区提交的热门工具,Obot AI可以敏锐地洞察市场需求和技术趋势,为其产品规划提供宝贵输入。

MCP生态本身也在快速扩展。例如,阿里巴巴开源的配置中心Nacos社区,就孵化了nacos-mcp-router项目,用于在复杂的微服务环境中路由和管理MCP流量。AIbase等模型和工具库也开始聚合各类MCP资源。这些外部生态的发展与Obot AI的平台形成了强大的协同效应。

正如Rancher在Kubernetes生态中定义了“企业级管理平台”这一品类,Obot AI现在正处在一个绝佳的时间窗口,有机会在MCP生态中建立类似的主导地位。 技术标准的早期阶段往往是决定未来市场格局的关键时期,而Obot团队的深厚经验、硬核技术和明智的开源策略,让他们手握一手好牌。

四、🧭 企业落地建议与未来展望

%20拷贝.jpg)

理论和产品都已清晰,那么对于正在考虑或已经开始尝试AI Agent的企业来说,应该如何借鉴Obot AI的思路,规划自己的落地路径呢?结合Obot AI的实践和行业趋势,我提出以下五点建议。

4.1 优先搭建控制平面,拒绝“野蛮生长”

这是最重要的一步。在业务部门开始大规模引入AI Agent之前,IT部门必须抢先建立一个统一的控制平面。不要等到“影子AI”泛滥成灾再去收拾烂局。

行动项:部署一个类似Obot MCP Gateway的中央网关。即使初期功能简单,也要确保所有Agent的流量都通过这个统一入口。

核心目标:实现统一的MCP服务器目录、统一的接入认证、统一的流量代理。这是后续所有治理和安全策略的基础。从第一天起,就要避免Agent直连MCP服务器的情况发生。

4.2 实施分层分域治理,兼顾效率与安全

企业内部不同部门、不同业务场景对AI Agent的需求和安全等级是不同的。一刀切的管理策略既不现实,也会扼杀创新。

行动项:根据部门、项目或数据敏感度,对MCP服务器和Agent进行分级分类管理。例如,可以划分为“公共区”、“研发区”、“核心业务区”等。

核心目标:

敏感场景优先本地部署:对于处理核心业务数据或个人隐私数据的Agent和工具,应优先考虑私有化部署,确保数据不出企业内网。

分级授权:为不同区域设置不同的访问策略。例如,市场部的Agent可能只能访问公开的舆情分析工具,而财务部的Agent则可以访问内部的ERP系统。

4.3 建立工具生态的准入与验证机制

MCP生态的开放性意味着工具来源广泛,质量良莠不齐。企业必须建立一套严格的准入机制,防止引入有安全漏洞或性能问题的工具。

行动项:

安全评估:在将任何一个新的MCP服务器(特别是来自第三方的)加入企业目录之前,进行代码审计和安全漏洞扫描。

负载验证:在沙箱环境中对MCP服务器进行压力测试,确保其性能能够满足生产环境的需求。

白名单与持续监控:建立一个“可信工具白名单”,并对白名单内的工具进行持续的监控和定期复审。

4.4 推动开发者与运维一体化(DevSecOps for AI)

AI Agent的开发和运维不能割裂。需要为Agent开发团队提供必要的工具和流程,同时将Agent的运维纳入企业现有的可观测性体系。

行动项:

为Agent开发团队提供类似Nanobot的框架,特别是支持MCP-UI和工作流编排的能力,让他们能高效构建强大的交互式Agent。

将MCP Gateway的审计日志、性能指标等数据,对接到企业现有的SIEM、Prometheus、Grafana等平台中,形成合规审计和故障排查的闭环。

核心目标:让Agent的开发、安全、运维成为一个无缝协作的流程,而不是相互推诿的“三角债”。

4.5 采取渐进式规模化策略,小步快跑

一口吃不成胖子。对于AI Agent这种新兴技术,盲目追求“一步到位”的大规模部署,往往会带来巨大的风险和失败。

行动项:

从PoC开始:选择一到两个痛点明确、边界清晰的业务场景进行概念验证(PoC)。

标准化流程:在PoC成功后,不要急于扩张,而是先沉淀和标准化Agent的开发、测试、部署、监控流程。

逐步扩展:在流程标准化的基础上,再逐步将成功模式复制到更多的业务场景,扩展到多MCP、多区域乃至混合云的环境。

结论

Obot AI的故事,不仅仅是一个明星创业公司获得巨额融资的商业新闻。它更像一个风向标,清晰地指出了企业级AI Agent发展的下一站——从单点的、混乱的“游击战”,走向体系化的、可控的“集团军作战”。

他们所倡导的“容器化”管理思路,以及对MCP这一开放标准的拥抱,正在为AI Agent的管理带来一场范式革命。通过将大模型、插件、记忆、权限等复杂元素抽象和封装,企业终于有了一种标准化的语言和工具链,来描述、部署和治理这些聪明的“数字员工”。

随着MCP生态的持续完善和像Obot AI这样的企业级基础设施不断成熟,AI Agent将不再是少数极客的玩具,而是真正能够深入企业业务流程、重塑生产力的核心引擎。

对于走在AI转型路上的企业而言,现在正是一个关键的窗口期。与其在“是否要用Agent”的问题上犹豫不决,不如开始思考“如何管好Agent”这个更具战略性的问题。抓住时机,构建起一套标准化的、可扩展的AI Agent管理体系,将是赢得未来AI时代竞争的关键一步。

📢💻 【省心锐评】

Obot AI没造新Agent,却拿了最多的钱。这说明,在AI淘金热中,卖铲子和修路的,永远比淘金的更早赚到钱。基础设施,才是硬通货。

.png)

评论