【摘要】AI投资回报普遍不及预期,企业战略失误引发“先裁后返pyridin”现象。这警示决策者必须重估技术边界、人力价值与项目治理的严肃性。

引言

技术浪潮总伴随着喧嚣与沉淀。当前,生成式AI正处在这样一个关键节点。麻省理工学院(MIT)近期的研究数据为市场情绪注入了一剂镇静剂。数据显示,全球企业在生成式AI领域的投资规模已高达300亿至400亿美元,然而,约95%的企业尚未从中获得任何可量化的正向财务回报。

这一冰冷的数据与市场上的火热宣传形成了鲜明对比。更值得关注的是,这股投资热潮的B面,是许多企业为追求所谓的“降本增效”而采取的激进裁员。然而,故事并未按预想的剧本发展。人力分析公司Visier的追踪报告揭示了一个反常趋势,2025年末,企业重新雇佣此前解雇员工的比例,达到了自2018年以来的峰值。这一“先裁后返聘”的模式,不仅暴露了企业在AI战略上的短视,也为所有技术决策者敲响了警钟。它不再是一个简单的人事问题,而是一个关乎技术认知、成本核算、组织能力与战略定力的综合性挑战。

一、❖ 现象透视 “先裁后返聘”模式的形成与数据佐证

%20拷贝.jpg)

1.1 投资回报的巨大鸿沟

MIT的研究并非孤例,它系统性地揭示了AI项目从技术验证(PoC)到价值实现(Value Realization)之间的巨大鸿沟。企业投入的数百亿美元,主要流向了基础设施采购、模型授权、人才招聘以及外部咨询。这些投入是实实在在的成本中心。但产出端,即效率提升、收入增长或成本节约,却迟迟未能显现。

这种脱节源于一个普遍的误解,即将生成式AI的能力等同于其商业价值。技术上能生成一段代码或一篇文案,不代表它能无缝嵌入现有业务流程,并稳定、可靠、合规地创造价值。95%的负回报率,实质上是企业为“技术尝鲜”和“战略跟风”支付的昂贵学费。

1.2 返聘潮的数据信号

Visier的报告为这一现象提供了量化证据。该公司长期追踪全球142家企业、共计240万名员工的就业数据。报告显示,在正常年份,被解雇员工中约有5.3%会被原雇主重新聘用,这通常是由于项目重启或业务波动。

然而,2025年末的数据出现了显著的异常拉升,返聘比例创下七年新高。Visier的研究与价值部门负责人安德莉亚·德勒(Andrea Derler)明确指出,这一增长与此前由AI驱动的裁员潮在时间上高度相关。这表明,许多企业在裁撤掉特定岗位后,发现业务运转出现了预料之外的阻碍,不得不重新请回那些熟悉业务、具备隐性知识的老员工。返聘,成为填补AI能力缺口和业务连续性风险的无奈之举。

1.3 “先裁后返聘”模式的恶性循环

我们将这一模式拆解,可以看到一个清晰的闭环。

战略驱动(Hype-Driven Strategy)。企业高层受市场热度影响,将AI定位为削减人力成本的“银弹”,并设定激进的裁员指标作为AI项目成功的KPI。

执行裁员(Execution of Layoffs)。基于对AI能力的乐观评估,企业裁撤了大量被认为“可替代”的岗位,如内容创作、客户支持、数据初级分析等。

运营阵痛(Operational Pain)。AI系统上线后,问题逐渐暴露。业务质量下滑、交付延迟、客户投诉增加、复杂问题处理效率低下等现象频发。AI无法处理的“异常”任务,堆积如山。

被迫返聘(Forced Rehiring)。为解决眼前的运营危机,企业不得不重新招聘。返聘老员工因其熟悉业务流程和上下文,成为最快、最有效的“救火”方案。

这个循环不仅造成了巨大的财务成本(裁员补偿、返聘招聘成本、AI项目沉没成本),更严重损害了组织士气、雇主品牌以及长期的人才战略规划。

二、❖ 深度归因 ROI不佳背后的决策与执行双重失焦

AI项目ROI不佳,返聘潮随之而起,其根源并非技术本身,而在于企业在决策、规划与执行层面的系统性失焦。

2.1 ROI不佳的技术与业务主因

企业在评估AI项目时,往往只看到了冰山上的模型调用成本,却严重低估了冰山下的综合成本。

2.1.1 训练与集成成本高昂

对于需要私有化部署或行业微调的模型,其成本远不止API调用费。

基础设施成本。高性能GPU集群的采购、租赁与运维成本是天文数字。

数据成本。高质量、已标注的训练数据是模型性能的基石。数据采集、清洗、标注、存储和管理本身就是一个庞大且持续的工程。

集成成本。将AI能力嵌入企业现有的ERP、CRM、SCM等复杂系统中,需要大量的接口开发、流程改造和兼容性测试工作。这部分工作往往占到项目总成本的50%以上。

2.1.2 数据治理体系薄弱

“Garbage in, garbage out”是AI领域的铁律。许多企业的数据治理水平远未达到支撑AI大规模应用的标准。

数据孤岛。数据散落在不同部门、不同格式的系统中,无法形成统一、高质量的数据资产。

数据质量。数据不一致、不完整、不准确的问题普遍存在,直接影响AI模型的输出质量。

数据安全与隐私*。在处理敏感数据时,如何确保合规性(如GDPR、CCPA),防止数据泄露,是巨大的技术与法律挑战。

2.1.3 “幻觉”与质量波动

大型语言模型(LLM)存在固有的“幻觉”(Hallucination)问题,即生成看似合理但与事实不符的内容。

不可预测性。模型的输出具有一定的随机性,对于要求高度准确性和一致性的业务场景(如法务合同、财务报告),这种波动是致命的。

缺乏可解释性。深度学习模型的“黑箱”特性,使得其决策过程难以解释。当AI给出一个错误的结论时,很难追溯其原因,这在金融、医疗等高风险领域是不可接受的。

2.1.4 合规与版权风险

数据来源合规性。许多大模型的训练数据来源于公开的互联网,其中可能包含受版权保护的内容。使用这些模型生成商业内容,存在侵权风险。

责任归属。当AI生成的建议导致业务损失或法律纠纷时,责任由谁承担?是AI供应商、企业,还是操作员工?法律框架的滞后带来了巨大的不确定性。

2.1.5 供应商锁定风险

当前,高质量的基础模型主要由少数几家科技巨头提供。企业一旦深度依赖某一家的API或平台(如OpenAI API、Azure OpenAI Service),就可能面临供应商锁定的风险。包括价格上涨、服务条款变更、技术路线绑定等,都可能让企业失去议价能力和技术自主性。

2.1.6 流程未重构的“新瓶装旧酒”

最致命的错误,是试图用AI去适配旧的流程,而不是用AI去重构新的流程。简单地将某个环节替换为AI,而不改变上下游的协作方式、质量标准和决策机制,其效果往往适得其反。例如,让AI替代初级客服,但仍沿用旧的工单流转和升级机制,结果只会是AI无法解决的问题在系统里空转,最终导致客户体验恶化。

2.1.7 员工工具素养普遍不足

有效的AI应用,需要员工具备新的技能,即“人机协同”的能力。

提示工程(Prompt Engineering)。如何提出精准、有效的问题,引导AI生成高质量的输出,是一项专业技能,而非简单的对话。

批判性思维。员工需要具备甄别AI输出内容真伪、评估其逻辑性的能力,不能盲目采信。

领域知识。只有具备深厚领域知识的专家,才能最好地利用AI作为辅助工具,并发现其输出中的细微错误。

2.2 组织层面的战略误判

技术和业务层面的问题,最终都指向了组织和管理上的深层误判。

2.2.1 问责机制的真空

一个成功的AI项目,必须有明确的业务负责人(Business Owner)。这个负责人需要对AI的最终业务产出(如客户满意度、销售转化率)负责,而不仅仅是IT部门对模型的部署上线负责。当AI的绩效无人负责时,项目就容易沦为技术驱动的“自嗨”。

2.2.2 缺乏质量门槛与回滚机制

许多企业在上线AI时,抱着“先上再看”的心态,没有设定明确的质量验收标准(Quality Gate)。

没有基线。上线前,没有对人工处理的效率、成本、质量进行精确的基线测量,导致上线后无法客观评估AI的真实效益。

没有预案。当AI系统出现重大故障或输出质量持续不达标时,没有设计好的降级方案(Degradation Plan)或快速回滚到人工模式的机制,导致业务停摆。

2.2.3 将裁员当作AI成功的KPI

这是最危险的误判。将“减少的人头数”作为衡量AI项目成功的核心指标,会严重扭曲项目目标。团队会为了达成裁员指标,而强行在不合适的场景应用AI,并刻意忽略其带来的质量下降和风险增加。正确的KPI应该是业务指标的提升,如处理周期缩短、客户净推荐值(NPS)提高、单位成本降低等。

三、❖ 可替代性的边界 AI与人类任务的再划分

%20拷贝.jpg)

“先裁后返聘”的根本原因,是对AI能力边界的认知不清。并非所有任务都适合被AI替代。我们需要建立一个清晰的框架来划分AI与人类的任务边界。

3.1 适合AI替代的任务特征

AI在处理以下特征的任务时,具有显著优势。

3.2 难以全面替代的岗位特征

与此相对,人类在处理复杂、动态和高价值的任务时,其能力目前仍是AI无法企及的。

核心结论是,AI是“工具”而非“工匠”。它可以极大地增强工匠的能力,但无法取代工匠的判断力、创造力和责任心。企业裁员时,往往混淆了这两者,错误地将辅助性任务的自动化,等同于对整个岗位的替代。

四、❖ 构建务实的ROI测算与治理框架

为了避免重蹈覆辙,企业需要建立一套科学、务实的AI项目ROI(投资回报率)测算与治理框架。这套框架应贯穿项目的整个生命周期。

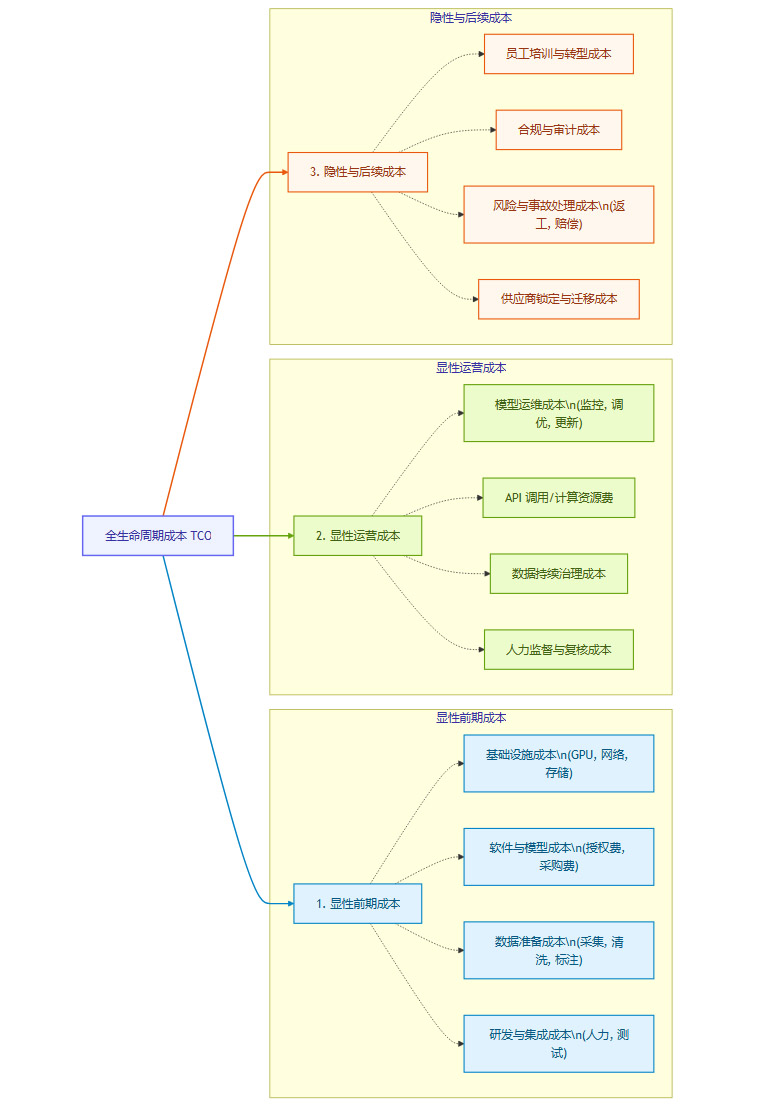

4.1 全生命周期成本核算(TCO)

一个完整的AI项目成本核算,必须超越简单的采购和开发成本,覆盖其全生命周期。

只有将所有这些成本纳入考量,才能得到一个真实的投资基数。

4.2 收益的精细化计量

收益的衡量同样需要精细化,不能一概而论。

成本节约(Cost Saving)。直接由人力替代带来的薪酬、福利等开支的减少。这是最直接,但也最容易被高估的部分。

效率提升(Efficiency Gain)。处理单个任务的时间缩短,或单位时间内处理的任务数量增加。

质量提升(Quality Improvement)。减少人工操作的错误率,提高产出的一致性和准确性。

能力拓展(Capability Expansion)。实现过去人力无法完成或成本过高而无法实现的任务,例如7x24小时服务、个性化推荐等。

这四个维度的收益需要分开计量,并赋予不同的权重,因为它们对业务的长期价值是不同的。

4.3 风险量化与回本周期

风险是成本的概率函数。必须对AI项目可能带来的风险进行量化,并将其作为负向收益计入ROI模型。

风险计提公式。

风险成本 = Σ (各类风险事件的发生概率 × 发生后的平均损失额)风险调整后ROI(Risk-Adjusted ROI)。

(收益 - 成本 - 风险成本) / 成本回本周期(Payback Period)。计算收回全部投资所需的时间。对于技术快速迭代的AI领域,如果一个项目的回本周期超过18-24个月,就需要高度警惕。

4.4 建立治理机制

一个健全的治理框架是ROI落地的保障。

明确的决策门(Decision Gates)。在项目各阶段(如概念验证、试点、全面推广)设立评审节点,只有达到预设的ROI和质量目标,才能进入下一阶段。

持续的性能监控。建立仪表盘,实时监控AI系统的关键性能指标(KPIs),如准确率、响应时间、用户满意度等。

人机复核流程。对于高风险或高价值的场景,必须默认开启人工复核流程。AI的输出只是“建议”,最终决策权仍在人手中。

快速回滚预案。设计并演练应急预案,确保在AI系统出现严重问题时,能够在分钟级别内将业务切换回人工模式或备用系统。

五、❖ 管理动作清单 从被动返聘到主动治理

%20拷贝.jpg)

基于以上分析,企业管理者应采取一套组合拳,将AI战略从被动的成本削减,转向主动的价值创造和风险控制。

5.1 领导者需回答的关键问题清单

在批准任何一个以替代人力为目标的AI项目前,决策者必须能够清晰地回答以下问题。

如果这些问题没有明确的答案,项目就不应该启动。

5.2 具体的管理动作

小范围试点与灰度上线。绝不搞“大跃进”。选择一到两个业务场景进行小范围试点,验证技术、流程和ROI模型。成功后,再通过灰度发布的方式,逐步扩大应用范围。

人机协同与复核默认开启。将“Human-in-the-Loop”作为设计原则。AI系统上线初期,人工复核应为100%,随着模型性能的稳定和信任度的建立,再逐步降低复核比例。

先转岗再优化编制。优先考虑将受影响的员工,通过培训转型到新的岗位上,如AI训练师、提示工程师、自动化流程质检员、数据标注专家等。保留领域知识和企业文化,远比单纯裁员更有价值。

建立返聘与应急外包预案。将返聘制度化,建立“人才储备池”。与可靠的业务流程外包(BPO)供应商建立合作关系,作为业务高峰或AI系统故障时的弹性补充。

多供应商策略与可回滚设计。在技术选型上,避免被单一供应商深度绑定。在系统架构上,采用松耦合设计,确保核心业务逻辑与AI服务解耦,便于未来替换或回滚。

结论

AI技术无疑是推动生产力发展的强大引擎,但它不是能够凭空变出利润的“成本魔法棒”。它更像一个放大器,能够放大组织的优势,同样也能放大组织的缺陷。如果一个企业的流程混乱、数据治理不善、战略决策草率,引入AI只会让情况变得更糟。

“先裁后返聘”的现象,是市场为这种草率决策开出的一张昂贵账单。它以一种极具戏剧性的方式提醒我们,在追求技术效率的同时,绝不能忽视人类员工所具备的灵活性、情境判断能力和最终的责任担当。这些“软”能力,在复杂多变的商业环境中,恰恰是组织韧性的基石。

未来的竞争,将不属于单纯拥抱AI的企业,也不属于固守传统模式的企业,而属于那些能够深刻理解技术边界,并巧妙地将AI的计算能力与人类的智慧进行融合,实现“人机协同”最优解的组织。这条路没有捷径,唯有审慎规划、扎实执行、持续迭代。

📢💻 【省心锐评】

AI不是裁员的借口,而是流程再造的契机。当企业为战略短视买单时,“返聘”便成了最昂贵的“补丁”。真正的AI红利,源于对人与技术协同价值的深度思考,而非简单的成本置换。

.png)

%20%E6%8B%B7%E8%B4%9D.jpg)

评论