【摘要】本文系统梳理了大模型微调领域的两大主流方法——全量微调(Full Fine-tuning)与LoRA(Low-Rank Adaptation),从原理、技术流程、优劣势、典型应用、参数优化、低成本适配策略、最新研究进展到未来趋势,全面对比分析如何以最低成本实现特定领域适配。文章结合丰富案例与前沿研究,旨在为AI工程师和行业决策者提供一份兼具技术深度与广度的实战参考。

引言

近年来,随着大语言模型(LLM)在自然语言处理、智能客服、医疗健康、金融风控等领域的广泛应用,如何高效、低成本地将通用大模型适配到特定领域,成为AI落地的核心技术挑战。全量微调(Full Fine-tuning)和LoRA(Low-Rank Adaptation)作为当前最具代表性的两种微调方法,分别代表了性能极限与资源效率的两端。面对模型规模的不断膨胀、行业需求的多样化以及算力资源的有限性,选择合适的微调策略已成为AI工程师和企业决策者必须直面的课题。

本文将以技术论坛深度文章的标准,系统梳理全量微调与LoRA的原理、流程、优劣势、典型应用、参数优化、低成本适配策略、最新研究进展及未来趋势,结合丰富的行业案例和前沿研究,深入探讨如何以最低成本实现大模型的特定领域适配。无论你是AI研发一线的技术专家,还是关注AI落地的行业管理者,都能在本文中找到有价值的参考。

一、方法原理与技术流程

%20拷贝-fskf.jpg)

1.1 全量微调(Full Fine-tuning)

1.1.1 原理

全量微调是指在预训练模型的基础上,解冻并更新所有参数,使模型能够完全适应新任务或领域。其核心思想是通过梯度下降等优化算法,针对特定任务数据集迭代优化全部权重,从而最大化模型对新任务的适应能力。

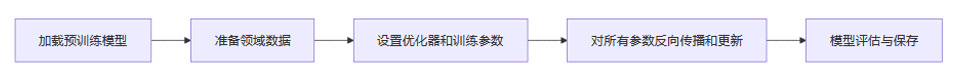

1.1.2 技术流程

加载预训练模型:选择合适的基础大模型(如BERT、GPT、Llama等)。

准备领域数据:收集并清洗与目标任务高度相关的数据集。

设置优化器和训练参数:如AdamW、学习率、批次大小等。

对所有参数反向传播和更新:解冻全部参数,进行全模型训练。

模型评估与保存:在验证集上评估效果,保存最佳模型权重。

1.2 LoRA(低秩适应,Low-Rank Adaptation)

1.2.1 原理

LoRA的核心思想是在模型关键层(如Transformer的注意力层)插入两个低秩矩阵A和B,仅训练这部分新增参数(通常占总参数0.1%~1%),其余原始权重保持冻结。前向传播时,模型输出为原权重加上A·B的低秩调整项,从而实现对模型能力的高效微调。

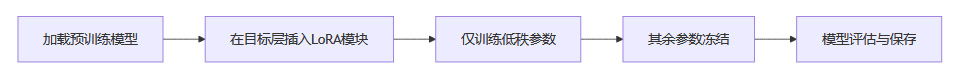

1.2.2 技术流程

加载预训练模型:同全量微调。

在目标层插入LoRA模块:通常选择Transformer的Q、V矩阵等关键层。

仅训练低秩参数:A、B两个低秩矩阵,其余参数冻结。

模型评估与保存:保存LoRA适配器,便于后续灵活加载。

二、优劣势对比

2.1 维度对比表

2.2 全量微调

2.2.1 优势

性能上限高:所有参数可调,理论上能获得最优性能,适合任务与预训练差异极大的场景(如医学、法律、低资源语种)。

灵活性高:可针对特定任务深度定制,满足极致性能需求。

2.2.2 劣势

计算与存储成本极高:如GPT-3 175B全量微调需>2TB显存,仅适合高端GPU集群。

灾难性遗忘风险大:易丢失预训练通用知识,影响泛化能力。

部署不灵活:每个任务需保存一份完整模型,存储和管理成本高。

2.3 LoRA

2.3.1 优势

极高参数效率:训练参数量减少90%以上,显著降低计算和存储需求。

低成本、快部署:适合资源有限团队和个人,消费级GPU即可微调大模型。

多任务灵活切换:适配器可独立保存和加载,便于多任务部署。

保留预训练知识:原始权重不变,减少灾难性遗忘,泛化能力较强。

推理无延迟:适配器可合并到原模型,不增加推理延迟。

2.3.2 劣势

适配能力有限:复杂或与预训练差异极大的任务性能略逊于全量微调。

秩参数需调优:过小欠拟合,过大失去参数效率。

可能引入“侵入维度”:影响分布外(OOD)泛化能力。

三、典型应用与案例

%20拷贝-vbxi.jpg)

3.1 LoRA应用

医疗文档摘要:某医疗机构用LoRA微调大模型,生成高质量文档摘要,医生效率显著提升。

智能客服/聊天机器人:电商企业用LoRA微调,快速适配客户服务场景,提升响应速度和满意度。

新闻生成:LoRA微调GPT-3,财经新闻生成时效性提升至秒级,人工审核成本下降40%。

语音助手:企业基于用户语音习惯微调,语音识别错误率降低15%,响应延迟减少30%。

金融风控:金融机构用LoRA微调,提升风险评估准确性,辅助投资决策。

开源大模型适配:如ChatGLM2-6B等广泛采用LoRA,降低行业落地门槛。

3.2 全量微调应用

搜索引擎优化:谷歌全量微调BERT-large适配多语言搜索,低资源语种召回率提升25%。

高专业性领域:金融、医疗、法律等深度定制任务,需极致性能。

四、参数优化与低成本适配策略

4.1 LoRA参数优化

秩(r)选择:文本任务推荐r=8-16,多模态任务r=16-32;r>64易过拟合,r<4表征不足。

缩放系数(α):α/r比值建议2-4,任务差异大时可增至α=4r。

目标层选择:常选Transformer的Q、V矩阵,部分任务需特殊设计。

4.2 训练与资源优化

混合精度(FP16):显存占用降低30%-50%,配合梯度检查点进一步压缩。

QLoRA:结合4-bit量化与LoRA,单卡48GB GPU可微调65B参数模型,成本仅为全量微调1/10。

渐进式微调:分阶段解冻层参数,优先调整高层网络,防止灾难性遗忘。

正则化与早停:权重衰减(如0.01)配合Early Stopping,防止过拟合。

五、最新进展与研究前沿

%20拷贝-ysqg.jpg)

5.1 QLoRA与量化微调

QLoRA结合4-bit量化与分页优化器,极大降低显存需求,使得在单卡48GB GPU上也能微调65B参数模型,性能接近全精度微调。该方法已在多个开源大模型社区广泛应用,推动了超大模型的平民化落地。

5.2 动态秩与自适应LoRA

如AdaLoRA、DyLoRA等方法可根据任务动态调整秩参数,提升低资源场景下的性能和适应性。这类方法通过自适应调整低秩矩阵的秩,兼顾了参数效率与模型表达能力。

5.3 多模态与跨领域扩展

LoRA已被扩展到视觉、语音等多模态任务(如VoRA),并在联邦学习、隐私保护等场景展现出独特优势。例如,VoRA在图像识别、语音识别等任务中实现了高效微调,显著降低了多模态模型的适配门槛。

5.4 灾难性遗忘与持续学习

最新研究表明,LoRA在低秩设置下可能引入“侵入维度”,影响模型的持续学习和泛化能力。高秩LoRA或全量微调在多任务适应和持续学习上表现更优。工程实践中,常结合参数冻结、正则化、渐进式微调等策略,平衡灾难性遗忘与泛化能力。

5.5 新兴方法

ReFT(Representation Finetuning):通过表征干预微调,节省算力,提升可解释性。

TAO(Test-time Adaptive Optimization):结合无标注数据与强化学习,部分任务超越传统微调。

5.6 权威研究

清华大学Nature子刊研究表明,Delta Tuning(含LoRA)在200+任务中参数效率比全量微调高100倍。

MIT实验发现,LoRA引入高秩“侵入维度”,分布外泛化性弱5%-8%。

六、选择建议与实践要点

6.1 选择建议

数据量大、资源充足、追求极致性能:优先全量微调。

资源有限、需多任务适配、快速迭代:优先LoRA或QLoRA。

超大规模模型(>100B):优先QLoRA,4-bit量化+分页优化器。

极低资源、少样本、API调用:可考虑Prompt Tuning、Prefix Tuning等更轻量方法。

持续学习/多任务:LoRA+模块化存储,适配器独立保存,动态加载。

6.2 实践要点

高质量数据预处理:提升微调效果,减少噪声干扰。

参数调优:结合任务和验证集动态调整LoRA的秩r、缩放系数α、目标层。

混合精度与分布式训练:结合FP16、ZeRO等技术,进一步降低显存和加速训练。

灾难性遗忘防护:参数冻结、正则化、低学习率等策略,提升泛化能力。

多适配器管理:LoRA支持多适配器加载与切换,便于多领域部署。

七、未来趋势与挑战

%20拷贝-eove.jpg)

7.1 混合微调与自动化参数优化

未来,混合微调(结合全量微调与参数高效微调)和自动化调参将成为主流。通过智能算法自动选择最优微调策略和参数配置,进一步提升模型适应性和效率。

7.2 多模态适配与持续学习

LoRA等方法正向视觉、语音等多模态和持续学习方向拓展,推动AI模型在更多复杂场景下的应用。多模态适配将成为大模型微调的重要发展方向。

7.3 泛化性与侵入维度问题

需关注LoRA在分布外数据上的泛化能力,合理选择秩和目标层,结合正则化、渐进式微调等策略,提升模型的稳健性和适应性。

7.4 行业普惠化

LoRA及其变体推动大模型在医疗、金融、客服等行业的平民化落地,让AI能力惠及更多中小企业和个人开发者。

结论

全量微调与LoRA各有优劣,选择需结合任务复杂度、数据量、资源条件和部署需求。LoRA及其变体已成为大模型低成本适配的主流方案,推动AI大模型的普惠化和行业落地。未来,混合微调、自动化参数优化、多模态适配和持续学习将成为大模型微调技术的重要发展方向。合理选择和优化微调方法,是大模型高效落地的关键。建议在实际应用中,根据资源、数据和业务需求灵活选择微调方案,充分利用LoRA等高效技术,结合最新研究进展,不断优化微调流程,实现大模型的高效、低成本、可持续落地。

📢💻 【省心锐评】

"LoRA不是万能药,但让中小企业摸到了大模型的脉搏。全量微调仍是高端玩家的利刃,不过QLoRA正把门槛踏成平地。"

.png)

评论