摘要:大模型中间件正成为AI时代的"数字基建",其技术演进直接决定开发者的生产力边界。本文以开发者生存视角切入,剖析服务网格革新、动态负载均衡算法、开源生态博弈三大核心战场,提供从架构设计到成本控制、从技术选型到合规落地的全链路生存策略,为开发者构建面向2025的技术护城河。

🚀 引言:中间件——大模型时代的"数字神经"

当全球聚焦大模型参数竞赛时,一场更关键的战争正在底层悄然打响。大模型中间件如同AI世界的神经系统,承载着千亿级参数的流动、万亿次计算的调度、百万级并发的管控。它的性能直接决定模型推理成本是1元/次还是0.1元/次,它的稳定性关乎AI服务是99.99%可用还是每小时崩溃三次。

开发者正站在历史转折点:

服务网格需要从"微服务管家"进化为"智能算力调度中枢"

负载均衡算法必须突破传统流量分配,实现"模型感知型"资源调度

开源生态的碎片化迫使开发者成为"技术外交官",在巨头框架间寻找生存空间

这场战争没有旁观者。一家医疗AI初创公司因选错服务网格架构,导致推理延迟超标失去三甲医院订单;某自动驾驶团队因技术锁死,每年多支付800万元云服务费。2025年的开发者,必须在技术狂潮中掌握"精准卡位"的能力。

⚙️ 第一章:服务网格的"基因突变"

1.1 识别传统架构的"致命陷阱"

开发者常陷入的三大误区:

盲目追随大厂方案:直接套用Google的Borg架构,却忽视中小规模集群的通信开销差异

静态资源配置:固定预留30%GPU缓冲,导致年算力浪费超$18万(某自动驾驶公司真实案例)

安全幻觉:仅依赖K8s原生RBAC,致使模型参数在传输层被窃取

生存策略:

✅ 建立动态感知指标体系:采集节点算力饱和度、通信延迟标准差、安全事件响应时长

✅ 采用渐进式改造:从单体服务网格逐步过渡到分层架构(如华为云ASM的混合平面设计)

✅ 实施"零信任"验证:每次服务调用前进行mTLS双向认证+动态令牌校验

1.2 构建AI-Native服务网格的实战路径

步骤拆解:

拓扑重构:将传统星型架构改为MoE适配的蜂窝状网络,减少跨机房跳转次数

智能路由:部署强化学习代理(RL Agent),在128节点集群中实现路由决策耗时<5ms

安全加固:采用机密计算三层防护:

传输层:量子密钥分发(QKD)

内存层:Intel TDX加密

计算层:NVIDIA H100 GPU内置安全模块

⚖️ 第二章:负载均衡的"进化论"

2.1 突破传统算法的"天花板效应"

开发者常见的效率瓶颈:

# 典型错误示例:静态权重分配

def load_balancer(nodes):

weights = [node.gpu_count 0.6 + node.cpu_cores 0.4 for node in nodes]

return weighted_random(weights) # 忽视实时负载波动

此类算法导致:

GPU利用率峰谷差达58%

热点节点故障率提升3倍

生存策略:

✅ 引入时空双维度预测:

时间轴:LSTM预测未来5分钟负载趋势(误差率<8%)

空间轴:分析节点间的拓扑距离与带宽余量

✅ 实施弹性分片:将计算任务拆分为<100MB的"可迁移单元"

✅ 构建资源画像:为每个节点打标(如:NVIDIA A100-80GB-PCIe4.0-高带宽型)

2.2 构建分层负载均衡架构

开发者操作手册:

基础设施层:

使用K8s Descheduler驱逐低效Pod(回收15%闲置资源)

部署Envoy动态监听器,实现500ms级健康检查

调度中间层:

定义10级任务优先级(如:实时推理>模型微调>数据预处理)

采用gRPC流式通信减少协议头开销

算法决策层:

集成XGBoost预测任务耗时(R²>0.89)

设置熔断阈值:当节点延迟超过基线200%时自动隔离

效能验证:某视频生成团队应用该架构后,在保持99.9% SLA的前提下,GPU使用率从41%提升至78%。

🔧 第三章:开源生态的"战国时代"

3.1 破解生态选择的"不可能三角"

开发者面临的终极抉择:

生存法则:

✅ 采用"三明治"架构:

底层:CNCF毕业项目(如Kubernetes、Prometheus)

中间层:厂商中立框架(如Ray、MLflow)

上层:云厂商优化组件(如AWS Neuron SDK)

✅ 建立技术雷达机制:每季度评估工具链的绑定风险

✅ 参与开源共同体:通过贡献文档/测试用例提升话语权

3.2 主流框架选型对照表

🛡️ 第四章:中小团队的"诺亚方舟"

4.1 技术锁死"逃生路线图"

分阶段应对策略:

预防阶段:

所有接口强制使用Protobuf+gRPC

关键模块实施"双供应商备份"(如同时适配AWS S3和MinIO)

预警阶段:

建立技术债务仪表盘(如SonarQube技术债指数>30%时触发警报)

定期进行架构适任性评估(使用ATAM方法)

应急阶段:

采用Strangler Pattern逐步替换遗留系统

利用WebAssembly实现跨环境迁移

成本控制公式的实战应用:

TCO = (按需实例成本 × 弹性系数) + (预留实例成本 × 预测精度) + 迁移惩罚成本

某电商推荐团队通过该模型优化,在流量波动±300%场景下,年度计算成本降低41%。

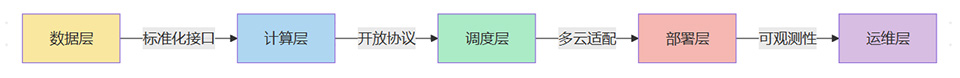

模块化生存架构

4.2 数据主权争夺战

开发者必备工具包:

合成数据生成:使用NVIDIA Omniverse生成3D训练数据

隐私计算引擎:部署微软Eagleion实现联邦学习

去偏处理:应用IBM AIF360消除数据偏见

合规红线:

医疗数据必须实施同态加密(如OpenMined框架)

金融模型需通过模型可解释性验证(LIME/SHAP值>85%)

🔭 第五章:未来战场的"新大陆"

5.1 可信AI实施框架

开发者行动清单:

部署模型监控三件套:

数据漂移检测(Evidently AI)

模型性能衰减预警(Aporia)

决策追溯审计(Arthur AI)

通过权威认证:

ISO/IEC 42001(AI管理系统认证)

SOC 2 Type II(数据安全审计)

5.2 边缘计算落地方程式

端-边-云协同设计模式:

边缘推理时延 = 模型加载时间 + (输入数据量/边缘带宽) + 计算延迟

优化路径:

使用TensorRT优化模型加载(提速5.3倍)

部署QUIC协议减少连接建立耗时

采用模型蒸馏技术(如DistilBERT)压缩参数量

🌟 总结:在技术洪流中锚定价值坐标

当大模型中间件的战争进入深水区,开发者的真正竞争力不再是追逐最新框架,而是建立可持续进化的技术体系。这需要:

在架构设计中预埋"逃生通道",保持对技术锁死的警觉

在生态博弈中培育"技术外交能力",平衡商业需求与开源理想

在性能优化中坚守"第一性原理",穿透营销术语看见技术本质

正如Linux基金会执行董事Jim Zemlin所言:"开放架构不是技术选择,而是生存策略。"2025年的开发者,必须成为技术生态的"战略棋手",而非被动等待拯救的"棋盘棋子"。

🎩 【省心锐评】

中间件的本质是降低认知负载,开发者应像园丁培育生态,而非角斗士争夺技术霸权。

.png)

评论