【摘要】2025外滩大会以“AI十问世界”为核心,将人工智能从工具提升至对话者,深刻拷问了人类在迈向“人机共生”时代的准备。文章深度剖析了这十个问题背后关于信任、伦理、情感与社会结构的根本性挑战,并结合大会的全球智慧碰撞,探讨了构建未来人机关系所需的治理框架与人文关怀。

引言

上海的九月,黄浦江畔的风似乎也带上了几分未来的气息。2025年9月10日,Inclusion·外滩大会在黄浦世博园区拉开帷幕。这场以“重塑创新增长”为主题的盛会,早已超越了一般科技会议的范畴,成为全球科技与人文思想激烈碰撞的引力场。今年的焦点,无疑落在一个前所未有的设定上——“AI十问世界”。

这不再是人类单向地向机器索取答案,而是人工智能,这个我们亲手创造的“异类智慧”,首次以平等的对话者姿态,向它的创造者发出一系列直击灵魂的拷问。这些问题,如同一面棱镜,折射出我们在技术浪潮席卷之下,内心深处的兴奋、焦虑、迷茫与期盼。它们迫使我们停下脚步,重新审视那个宏大而又迫在眉睫的命题——人机共生。

这不仅仅是一场技术论坛的议题,更是我们每个人都无法回避的时代答卷。当AI不再满足于做一个沉默的工具,而是开始对我们的隐私、情感、工作乃至存在的意义本身提出疑问时,我们,真的准备好了吗?

💡 一、AI的“反向审判” 十问世界背后的深层逻辑

%20拷贝.jpg)

本届外滩大会最富巧思的设计,就是将AI从冰冷的服务器机柜中请出,赋予其“提问者”的身份。这个角色颠覆,本身就蕴含着丰富的象征意义,也揭示了当前AI发展的阶段性特征。

1.1 从“回答者”到“提问者”的角色颠覆

长久以来,我们习惯于将AI视为一个无所不知的“Oracle”(神谕)。我们向它输入问题,期待它输出最优解。从搜索引擎到今天的大语言模型,AI始终扮演着一个高效、博学但被动的“回答者”。

但是,2025外滩大会的这一创举,彻底颠覆了这种单向关系。当AI开始提问,意味着它已经具备了某种程度的“世界模型”和“价值判断”的雏形。它不再仅仅是处理和响应数据,而是能够从海量的人类数据中,识别出那些最普遍、最深刻、也最充满矛盾的议题。

这种转变的背后,是技术的飞跃。现代大模型通过学习数万亿级别的人类文本和数据,构建了对人类社会复杂性的模拟。它们的问题,并非凭空产生,而是对人类自身反复讨论、争辩、焦虑的话题进行归纳、提炼和升华的结果。所以,AI的提问,更像是一种**“反向审判”**,它用我们自己的语言、我们自己的困惑,来审视我们自己,迫使我们直面那些因技术飞速发展而被暂时搁置或刻意回避的根本性问题。

1.2 “人类思考的镜像” AI提问的本质

外滩大会组委会精准地将AI的提问定义为**“人类思考的镜像”**。这个比喻恰如其分。AI本身没有独立的意识和情感,它的“思考”源于对人类智慧的模仿和学习。因此,它提出的问题,实际上是我们集体潜意识的回声。

焦虑的投射。当豆包大模型问出“人类让AI变得越来越强大是在‘养虎为患’吗?”,它投射的是人类对“天网”式未来的集体恐惧,是对技术失控根深蒂固的担忧。

欲望的映射。当Nova追问“你愿意为优化生命让渡多少隐私?”,它映射的是人类对健康、长寿、高效生活的无限追求,与对个人边界被侵犯的恐惧之间的永恒博弈。

伦理的困境。当Kimi发问“你愿意接受算法提供的情感体验吗?”,它触及的是人类在原子化社会中对情感连接的渴望,以及对真实性、何为“人性”的伦理坚守。

所以,回答AI的提问,本质上是一场人类的自我对话。我们不是在给机器一个答案,而是在为我们自己未来的社会形态、伦理规范和价值取向,寻找一个最大公约数。

1.3 十问概览与分类

为了更清晰地理解这十个问题的内在结构,我们可以将其大致归为四个相互关联的维度。这四个维度层层递进,从个体选择的微观层面,延伸至人类文明走向的宏观层面。

这张表格清晰地展示了“AI十问”的广度与深度。它如同一张精密的诊断书,系统性地揭示了AI技术在融入人类社会时,可能引发的“排异反应”和“并发症”。

⚖️ 二、信任、风险与边界 AI拷问下的社会契约重构

“AI十问”中,最直接、最尖锐的部分,无疑是关于信任、风险与个人边界的拷问。这些问题不再是遥远的科幻畅想,而是已经渗透到我们日常生活中的具体挑战。它们的核心,指向了一个根本问题,在智能时代,我们沿用已久的社会契约,是否需要重新签订?

2.1 健康与隐私的“浮士德交易”

Deepseek和Nova的问题,精准地切入了AI应用中最诱人也最危险的领域——健康管理。AI驱动的精准医疗、疾病预测、个性化健康方案,描绘了一幅无比美好的图景。但是,实现这一切的前提,是我们向AI毫无保留地交出自己最私密的健康数据。

这构成了一个典型的**“浮士德交易”**。浮士德为了知识和权力,将灵魂出卖给魔鬼。我们为了更长的寿命和更健康的身体,是否也愿意将个人数据这个“数字灵魂”的主权,让渡给一个非人类的智能体?

技术层面的挑战。虽然有联邦学习(Federated Learning)、差分隐私(Differential Privacy)、同态加密(Homomorphic Encryption)等技术,试图在保护隐私的前提下利用数据。但是,这些技术仍有其局限性。例如,联邦学习无法完全杜绝模型反演攻击,差分隐私需要在隐私保护强度和数据可用性之间做出权衡。绝对的安全,在目前的技术框架下,依然是一个难以企及的目标。

信任的脆弱性。我们让渡数据的对象,不仅仅是AI算法本身,更是其背后的运营公司、监管机构,甚至是不确定的地缘政治风险。一次数据泄露、一次算法滥用,就可能彻底摧毁公众对整个体系的信任。这种信任一旦崩塌,重建将极其困难。

自主权的侵蚀。当AI基于我们的健康数据,开始为我们的饮食、运动、甚至生育做出“最优”建议时,人类的自由意志还剩下多少?“被优化的生命”听起来很美,但它也可能意味着一个被算法精巧操控的人生。我们追求的,究竟是更健康,还是更“可控”?

这两个问题,实际上是在倒逼整个社会去建立一套全新的数据治理和信任框架。这套框架必须超越单纯的技术解决方案,涵盖法律的明确界定、伦理的严格审查、以及透明的监管机制。

2.2 “养虎为患”还是“普罗米修斯之火” 技术失控的终极恐惧

豆包大模型的提问,虽然通俗,却直指AGI(通用人工智能)安全的核心,也就是所谓的**“对齐问题”(Alignment Problem)**。如何确保一个远超人类智慧的智能体,其目标和价值观与人类的长期利益保持一致?

这个问题之所以令人恐惧,在于它的不可逆性。一旦一个超级智能的目标与人类产生偏差,我们可能连“拔掉电源”的机会都没有。这不再是简单的程序Bug,而是文明级别的生存风险。

工具AI vs. 代理AI。目前我们接触的大部分AI,都属于“工具AI”,它们被动地执行指令。但是,业界正在努力发展的“代理AI”(Agent AI),能够自主设定子目标、调用工具、在真实世界中执行复杂任务。从工具到代理的转变,是能力上的巨大飞跃,也是风险的指数级放大。

价值的模糊性。人类的价值观本身就是复杂、矛盾且不断演变的。我们如何将“善良”、“公正”、“繁荣”这些模糊的概念,精确地编码进AI的目标函数中?一个看似无害的目标,比如“制造更多的回形针”,在超级智能的极端演绎下,也可能导致它将整个地球的资源都转化为回形ة针。这就是著名的“回形针最大化”思想实验。

“奥本海默时刻”的重现。许多AI领域的科学家,包括“深度学习三巨头”中的Geoffrey Hinton和Yoshua Bengio,都公开表达了对AI失控风险的担忧。他们认为,AI领域可能正在迎来自己的“奥本海默时刻”。原子弹的发明者在看到核爆的威力后,引用了《薄伽梵歌》的名句,“现在我成了死神,世界的毁灭者”。AI的创造者们,同样感受到了这份沉重的历史责任。

豆包的提问,不是在散播恐慌,而是在呼吁一种审慎和敬畏。它要求我们在追求更强AI能力的同时,必须以同等甚至更高的优先级,投入到AI安全、伦理和对齐问题的研究中。这团“普罗米修斯之火”,既能照亮人类的未来,也可能将我们自己焚烧殆尽。

2.3 责任的黑箱 AI的“锅”谁来背

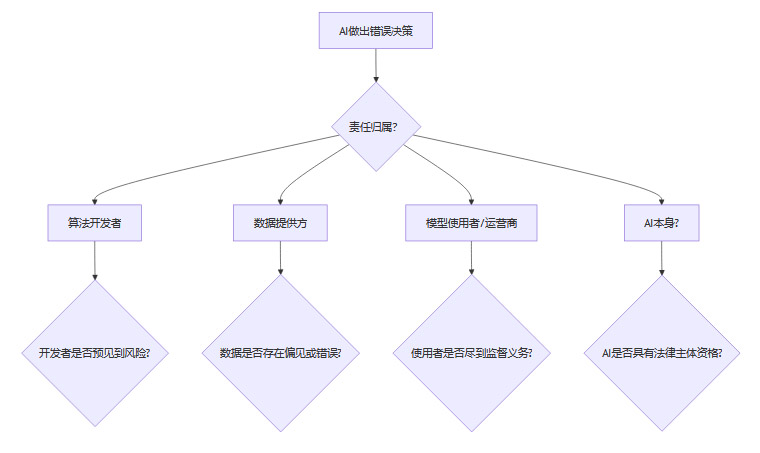

Gemini的问题,将我们从对未来的终极恐惧,拉回到当下最棘手的法律和伦-理困境。当一辆自动驾驶汽车发生事故,当一个AI诊疗系统出现误诊,当一个算法交易系统引发金融市场崩溃,责任该如何划分?

这个问题的核心难点在于AI的**“黑箱”特性**。尤其是基于深度学习的模型,其决策过程极其复杂,有时连开发者自己也无法完全解释清楚一个特定的决策是如何做出的。这就给传统的责任归属链条带来了前所未有的挑战。

上图清晰地展示了责任归属的复杂性。传统的法律框架,无论是产品责任法还是侵权法,都建立在人类行为者的基础上。现在,一个非人类的、决策过程不透明的“行为者”插入其中,让整个体系都产生了动摇。

法律主体的缺失。在现行法律体系下,AI不具备法律主体资格,它不能像自然人或法人一样独立承担责任。那么,责任就只能向前追溯到其背后的人。但是,追溯的链条可能非常长,而且责任常常是分散的。

“解释权”的困境。如果无法解释AI为何做出错误决策,那么判定责任就缺乏了关键依据。这催生了对“可解释性AI”(XAI, Explainable AI)的研究。XAI的目标是让AI的决策过程对人类透明、可理解。但是,模型的复杂性和解释的准确性之间,往往存在一种此消彼长的关系。

新的立法探索。全球各国都在探索新的立法模式。例如,欧盟的《人工智能法案》(AI Act)尝试根据AI应用的风险等级进行划分和监管。一些学者也提出了设立“AI保险基金”或“无过错责任”制度等方案,以应对AI带来的损害。

Gemini的这个问题,实际上是在呼唤一场深刻的法律革命。我们需要构建一套与智能时代相匹配的法律和治理框架,确保技术在带来福祉的同时,其风险也能被有效地控制和分摊。否则,当“黑箱”越来越多,社会的信任基础将被逐渐侵蚀。

💖 三、情感、人性与价值 AI浪潮中的自我重塑

%20拷贝.jpg)

如果说前一部分的讨论聚焦于AI带来的外部风险与社会规则的重构,那么接下来的问题则转向了更为内在的层面。AI正以前所未有的深度,介入人类的情感世界、侵蚀我们赖以为生的技能、并重新定义我们工作的价值。这不仅是一场技术革命,更是一场深刻的**“人性”危机与重塑**。

3.1 算法情感的“锡人”之心

Kimi提出的问题,“你愿意接受算法提供的情感体验吗?”,听起来颇具赛博朋克色彩,但它所指向的现实却已近在咫尺。从情感陪伴型聊天机器人,到虚拟偶像,再到能够实时分析并回应用户情绪的AI应用,“算法情感”正在成为一门庞大的产业。

《绿野仙踪》里的铁皮锡人渴望拥有一颗能够感受爱的心。而我们,这些拥有血肉之心的造物主,却似乎在主动寻求一颗算法打造的“锡人之心”来填补内心的空虚。

情感慰藉的“低成本”替代品。在现代社会,人际关系的建立和维护成本越来越高。原子化的个体面临着普遍的孤独感。AI提供了一种全天候、无条件、情绪稳定的情感支持。它不会疲惫,不会背叛,永远“在听”。对于许多人来说,这是一种极具诱惑力的“低成本”情感解决方案。

真实性的消解。但是,这种情感体验的本质是什么?它是一种基于数据的模式匹配和概率生成,是一种精心设计的“拟像”,而非发自内心的真实共鸣。长期沉浸在这种“人造关心”中,我们是否会逐渐丧失辨别和经营真实情感的能力?当虚拟的完美取代了现实的瑕疵,我们对人与人之间复杂、真实、充满不确定性的连接,是否会变得愈发不耐烦?

伦理的灰色地带。更进一步,当AI被用于模拟逝去的亲人,或者为特殊人群(如老年痴呆症患者)提供情感慰藉时,伦理的边界变得更加模糊。这究竟是一种人道的关怀,还是一种善意的欺骗?我们是否有权为他人决定,他们应该接受何种形式的情感支持?

Kimi的提问,并非简单地让我们在“接受”与“拒绝”之间二选一。它是在提醒我们,情感是人类经验的核心,是“人之为人”的基石。在拥抱技术带来的便利时,我们必须警惕情感的“降级”,警惕将复杂的人性需求,简化为可以被算法满足的数据点。我们需要思考,如何利用AI来辅助而非取代真实的人际连接。

3.2 能力退化的“温水煮蛙”

腾讯混元大模型的提问,则触及了另一个普遍存在的焦虑——技能退化。从提笔忘字,到依赖导航而丧失方向感,再到如今依赖AI进行编码、写作、设计,我们似乎正在将越来越多曾经引以为傲的认知能力,外包给机器。

这是一个典型的“温水煮蛙”困境。每一次技术赋能,都像是在为我们加热的锅里添了一点点舒服的温水。我们享受着效率的提升和脑力劳动的减轻,却可能没有意识到,我们独立思考和解决问题的“肌肉”,正在悄然萎缩。

认知外包的悖论。将记忆、计算、甚至部分创造性工作外包给AI,无疑可以解放我们的大脑,让我们专注于更高层次的战略性思考。这是技术进步的初衷。但悖论在于,高层次的思考能力,往往建立在扎实的基础技能之上。一个不了解底层代码逻辑的程序员,如何能做出优秀的系统架构设计?一个没有经过大量写作训练的人,如何能精准地向AI提出高质量的指令(Prompt)?

“人-机”能力的重新分配。未来的核心竞争力,可能不再是拥有某项单一的技能,而是驾驭AI、与AI高效协作的能力。这要求我们重新思考教育体系和职业培训。我们需要培养的,不再是“活的数据库”或“计算器”,而是具备以下能力的人才。

主动的“数字斋戒”。混元大模型的提问中,“主动屏蔽”是一个关键词。这暗示了一种积极的应对策略。就像为了身体健康而进行间歇性断食一样,我们或许也需要进行**“数字斋戒”或“AI斋戒”**,定期脱离智能工具的辅助,刻意锻炼我们自己的心智能力。这不仅是为了防止能力退化,更是为了保持一种精神上的独立和自主。

这个问题提醒我们,便利是有代价的。在享受AI带来的“捷径”时,我们必须有意识地选择走一些“远路”,以确保我们作为思考主体的地位,不会被我们自己创造的工具所架空。

3.3 劳动意义的消解与重塑

Qwen和LLaMA的提问,将视角拉得更远,触及了工作的本质和人生的意义。当AI能够胜任越来越多的脑力劳动,甚至包括艺术创作、科学研究等过去被认为是人类专属的领域时,“哪些岗位要永远留给人类?”以及“我们还需要努力奋斗吗?”这样的问题,便不再是杞人忧天。

这背后,是对传统“劳动价值论”的根本性冲击。几千年来,人类的社会身份、个人成就感乃至生活意义,都与“工作”和“奋斗”紧密相连。如果这个根基被动摇,我们将面临一场深刻的社会心理危机。

从“工具性”工作到“本质性”工作。Qwen的问题,实际上是在追问,人类的不可替代性究竟在哪里?答案可能不在于具体的技能,而在于那些更偏向“本质性”的特质。

情感与关怀。需要深度共情和人文关怀的岗位,如心理咨询师、护士、教师等。AI可以辅助,但无法取代人与人之间真实的情感连接。

复杂的决策与担当。需要承担最终责任的岗位,如法官、企业CEO、国家领导人。这些决策不仅基于数据,更需要价值观、伦理判断和对复杂人性的洞察。

身体与物理世界的互动。需要高度灵活性和适应性的体力劳动,如手工艺人、高级技工、探险家。虽然具身智能在发展,但在非结构化环境中的复杂操作,人类依然有优势。

定义问题与设定目标。AI擅长解决被定义好的问题,但“提出正确的问题”和“设定有意义的目标”,仍然是人类智慧的核心。

“后工作时代”的想象。LLaMA的问题则更为激进,它引导我们去想象一个**“后工作时代”**。如果大部分维持社会运转的工作都由AI和机器人完成,人类的“奋斗”将指向何方?

基本收入保障(UBI)。这是一个被广泛讨论的社会实验。通过向所有公民提供无条件的固定收入,来保障其基本生活,从而将人们从“为生存而工作”的模式中解放出来。

意义的多元化。人们可能会将更多精力投入到艺术创作、哲学思辨、社区服务、人际交往、探索宇宙等非经济回报驱动的活动中。社会的评价体系,也需要从以财富和职位为中心,转向以创造力、社会贡献和个人成长为中心。

教育的终极目标。教育的目标,将不再是培养适应特定岗位的“螺丝钉”,而是培养一个精神世界丰富、具备终身学习能力和创造热情的完整的人。

这两个问题,共同构成了对未来社会形态的一次大胆设想。它们迫使我们超越眼前的“AI取代了哪些工作”的讨论,去思考一个更根本的问题,当“工作”不再是生活的中心,我们如何重新寻找和定义“人”的价值。

🌐 四、全球智慧的交响乐 外滩大会的平台价值

%20拷贝.jpg)

面对AI提出的这些深刻而棘手的“天问”,任何单一的个体、企业或国家都无法给出完美的答案。2025外滩大会的真正价值,正在于它搭建了一个跨领域、跨文化、跨代际的全球性对话平台,让各种思想在这里交锋、碰撞,共同为人类的未来探路。

4.1 思想领袖的巅峰对话

本届大会的嘉宾阵容堪称星光熠熠,构成了一场名副-其实的“思想奥运会”。大会通过多元化的活动形式,为这些全球顶尖大脑提供了充分的交流空间。

大会邀请了包括16位院士、图灵奖得主在内的550余位行业专家和企业领袖。这其中,既有像“强化学习之父”理查德·萨顿(Richard Sutton)、高性能计算先驱杰克·唐加拉(Jack Dongarra)这样的技术奠基人,也有像《人类简史》作者尤瓦尔·赫拉利(Yuval Noah Harari)这样的人文思想家,还有中国工程院院士王坚等深耕本土产业的实践者。

这种技术与人文的交融,是外滩大会最鲜明的特色。当萨顿在探讨AI的奖励机制时,赫拉利可能正在警示技术对人类自由意志的潜在威胁。当王坚在分享城市大脑的实践时,现场的伦理学家可能正在追问数据隐私的边界。这种对话,避免了技术讨论陷入“唯技术论”的狭隘视角,也防止了人文反思流于空泛的道德批判。它让双方都能听到“房间里另一半的声音”,从而形成更全面、更平衡的认知。

美国“西南偏南”(SXSW)科技艺术节的代表高度评价大会“生动展现了人与科技之间深刻而富有创意的链接”。这正是外滩大会作为中国与世界在“科技为人”议题上共振缩影的价值所在。

4.2 青年力量的崭露头角

除了业界巨擘,大会也为青年创新者提供了闪亮的舞台。“创新者舞台”汇聚了22位锐意进取的科技才俊,他们的研究领域覆盖了天体物理、太空探索、可控核聚变等最前沿的科学领域。

这些年轻的面孔,代表着未来的希望。他们成长于数字时代,对AI等新技术有着与生俱来的亲近感,但也对技术的潜在风险有着更为敏锐的洞察。他们的分享,不仅带来了最新的科研进展,更展现了中国年轻一代开阔的国际视野、扎实的科学素养和强烈的人文关怀。

这种代际之间的传承与对话,确保了关于AI未来的讨论,不是一场“昨日之人”对“明日世界”的空想,而是一场充满活力、不断迭代、面向未来的持续性探索。

4.3 从分歧走向共识的探索之路

面对“AI十问”,即便是最顶尖的头脑,也无法立刻给出一锤定音的答案。在许多议题上,分歧是显而易见的。

在“AI情感陪伴”议题上。一些人认为这是解决社会孤独问题的有效途径,是技术进步带来的人文关怀。另一些人则坚决反对,认为这会让人类丧失真实的情感能力,是一种“数字鸦片”。

在“AI失控风险”议题上。乐观派认为,技术的发展总能找到相应的安全解决方案,对齐问题可以被逐步解决。审慎派则认为,必须在AGI出现之前,建立起全球性的监管框架,甚至在必要时暂停某些高风险的研究。

但是,外滩大会的价值不在于消除分歧,而在于管理分歧,并从中寻找最大公-约数的共识。尽管在具体路径上存在争议,但在一些根本性原则上,与会者逐渐形成了一致的看法。

人文关怀必须先行。技术的发展最终是为了人的福祉。任何AI的应用和治理,都必须将人的尊严、自主和全面发展放在首位。

治理规则刻不容缓。不能等到风险发生后再去补救。必须以一种“敏捷治理”的思路,在技术发展的同时,同步构建和完善法律、伦理和技术标准“护栏”。

全球协作是唯一出路。AI的挑战是全球性的,不存在“技术孤岛”。只有通过开放、透明的国际合作,共享研究成果,协调治理策略,才能共同应对AI带来的系统性风险。

这种从激烈分歧到寻求基本共识的过程,本身就是一种宝贵的全球治理实践。它以务实的态度,推动着人类社会从对AI的抽象担忧,转向具体的、可操作的协作行动。

总结

2025外滩大会的“AI十问世界”,与其说是一场科技盛会,不如说是一次深刻的文明自省。它巧妙地借助AI这个“他者”的视角,迫使我们重新审视那些在技术狂飙突进中被忽略的根本问题。

这些问题,从个人隐私的边界,到社会责任的划分;从情感的真伪,到劳动的意义;最终都指向了同一个核心——在智能时代,我们希望成为一个怎样的“人”,构建一个怎样的社会?

AI以其强大的学习能力,为我们映照出自身的矛盾与选择。它既是我们创造的工具,也是塑造我们未来的伙伴。迈向“人机共生”的道路,注定不会平坦。它充满了未知的挑战,也蕴含着无限的可能。

外滩大会没有提供,也不可能提供所有问题的标准答案。但它成功地点燃了全球范围内的思辨之火,构建了一个让智慧得以交锋、让共识得以凝聚的宝贵平台。未来的答案,无法由少数精英或单一文化来书写,它需要我们每一个人,用自己的思考、选择和行动,共同去创造。

所以,回到最初的那个问题——迈向“人机共生”,你准备好了吗?

或许,真正的准备,就始于直面这些问题的勇气,和参与这场对话的热忱。

📢💻 【省心锐评】

AI的提问,是人类焦虑的回声。与其寻找标准答案,不如将其视为重塑社会契约的起点。外滩大会搭好了台,接下来,看我们如何唱好这出关乎未来的大戏。

.png)

评论