【摘要】探讨RAG技术已触及的应用天花板,即从被动“知识调用”到主动“任务执行”的范式转移。文章深度解构了Multi-Agent架构作为实现AI“组织智能”的路径,并提出了融合RAG与Agent的务实落地策略,旨在重塑AI的商业交付价值。

引言

当整个行业还在为RAG(检索增强生成)的文档问答能力欢呼时,一个更深刻的瓶颈已经浮现。我们创造出了堪比“博士”大脑的LLM,却发现它在解决真实世界的复杂业务流程时,依然像一个被困在瓶子里的天才。这篇文章将撕开“智能”的假象,告诉你为什么AI的下半场,竞争的不再是模型参数的大小,而是构建高效“AI组织”的能力。这不仅是技术的范式转移,更是对产品经理、架构师和所有AI从业者的一次认知重塑。

你可能刚刚经历了一场小小的胜利。你带领团队,基于最新的RAG技术,打造了一个堪称完美的内部知识库问答机器人。它能精准地回答关于公司产品、政策、历史数据的任何问题。直到有一天,CEO在群里抛出了一个灵魂拷问,“第三季度销售额下降了15%,我们该怎么办?”

你的机器人不负众望,迅速检索了所有相关报告,并生成了一份堪称完美的摘要,列举了可能的原因、历史上的应对策略,甚至引用了市场分析报告。大家纷纷点赞,CEO也表示认可。然后……就没有然后了。用户读完报告,关掉聊天窗口,一切照旧。销售额的问题,依然摆在那里,未被触动分毫。

这就是我所说的“行动鸿沟”(Action Gap),一个介于“知道”和“做到”之间的巨大裂痕。而这道鸿沟,正是当前主流的、以RAG为代表的AI应用正在一头撞上的南墙。

一、💡 RAG的边界在哪里?从“知识管家”到“行动鸿沟”

%20拷贝-pojt.jpg)

要理解为什么需要超越RAG,我们首先必须清晰地认识到它的本质和边界。RAG并非万能药,它是一个定位精准的工具,但这个定位本身就决定了它的天花板。

1.1 RAG的本质 一个高效的“只读”知识管道

我们必须清醒地认识到,RAG从根本上说,是一个“只读”系统。它的核心能力是“检索”和“增强”,本质上是一个极其高效的信息管道。它擅长将海量的非结构化数据,通过检索匹配和语言模型重组,转化为结构化的、可供人类理解的答案。

RAG的价值在于解决“知道得对不对、够不够”的问题。在以下几个场景中,它的地位几乎不可替代。

海量知识库 当企业内部文档、法规、技术手册达到数百万甚至上亿级别时,RAG是唯一能够经济高效地利用这些知识的手段。

强时效性 对于新闻、财报、市场动态等需要实时更新知识的场景,RAG通过外挂知识库,绕开了LLM训练周期的限制。

强隐私与权限管控 在金融、医疗、法务等领域,数据无法用于公开模型训练。RAG允许知识库本地化部署,并能与现有权限系统结合,保证数据安全。

知识溯源与可解释性 RAG最大的优点之一是它能提供答案的来源出处,这对于需要证据整合和事实核查的严肃场景至关重要。

所以,RAG更像一个博学多才的“图书管理员”或“知识管家”。它能帮你找到任何你需要的资料,并整理成一份清晰的报告。但是,它无法帮你制定战略、分配任务、监督执行,并最终解决问题。

1.2 “知道”与“做到”之间无法逾越的鸿沟

商业世界的运转远非简单的Q&A。真实的业务流程充满了决策链、条件逻辑,以及跨多个系统的协同动作。RAG可以告诉你需要做什么,但它无法亲手去做。

回到开篇那个CEO的问题,“第三季度销售额下降了15%,我们该怎么办?”

一个RAG系统能做的,是提供一份高质量的分析报告。但一个完整的解决方案,可能需要以下一系列动作。

诊断 召集销售、市场、产品部门的负责人开会,深入分析数据。

决策 基于分析,制定几个备选行动方案,比如“启动新一轮促销活动”、“调整渠道策略”或“优化产品功能”。

规划 选定方案后,将其分解为具体的任务列表,明确每个任务的负责人(Owner)、截止日期(DDL)和交付标准(Deliverable)。

执行 市场部设计促销海报,销售部培训话术,产品部排期开发。

跟进 项目经理每周跟进各方进度,协调资源,解决阻塞。

复盘 活动结束后,复盘数据,评估效果,形成经验沉淀。

这是一个典型的业务闭环。在这个闭环中,RAG仅仅完成了第一步“诊断”中的信息收集工作。后续的决策、规划、执行、跟进、复盘,全部超出了它的能力范围。这就是“行动鸿沟”,它阻碍了AI从一个“信息工具”转变为一个“价值创造伙伴”。

1.3 RAG的技术天花板

除了业务层面的“行动鸿沟”,RAG在技术层面也存在固有的局限性。这些局限性导致它在处理更复杂的查询时表现不佳。

虽然长上下文模型(如支持百万级Token输入的模型)可以在某些场景下,通过将大量文档直接塞入上下文来替代RAG,但这并非银弹。两者更多是互补关系。长上下文在处理单篇超长文档或少量关联文档时有优势,但在海量、高频更新的知识库面前,其成本和效率远不及RAG。

所以,问题的关键已经清晰。如果我们的目标仅仅是“回答问题”,RAG是一个优秀的工具。但如果我们的目标是“交付业务成果”,RAG的单一形态就难以胜任了。我们需要引入更强的任务分解与执行能力,让AI跨越那道“行动鸿gōu”。

二、🚀 AI下半场 欢迎来到“组织智能”时代

过去几年,我们见证了模型参数的军备竞赛,从GPT-3的1750亿到GPT-4的万亿级别。但正如吴恩达(Andrew Ng)所指出的,单纯追求更大的LLM正在带来边际效益递减,未来的关键不在于更大的模型,而在于Agentic Workflows(智能体工作流)。

2.1 从“算力竞赛”到“组织力”困境

我们已经成功地在“罐子”里培养出了一个绝顶聪明的大脑,但现在的问题是,如何给这个大脑配上眼睛、手脚,以及一个能与之协作的团队。

问题的核心已经转移。不再是单个模型的“智商”不够高,而是我们缺少一个能让“智慧”转化为“行动”的组织架构。一项针对Multi-Agent系统失败原因的深入研究发现,失败的核心并非LLM本身的能力不足,而是源于“组织理解”的缺失和“智能体间的错位”。

这揭示了一个深刻的范式转移。AI价值的下一个前沿,不再是让单个模型变得更聪明一点点,而是让多个专业化的模型高效地协同工作。我们正从追求“计算智能”的时代,迈向追求“组织智能”的时代。

2.2 什么是“组织智能”?AI系统工程的新范式

“组织智能”是一个比喻,它要求我们将AI系统不再看作一个单一的、无所不能的“大脑”,而是看作一个数字化的组织。这个组织与人类社会的企业一样,具备以下特征。

分工 (Division of Labor) 组织内有不同角色,每个角色拥有特定的技能和职责。比如有负责搜集信息的“研究员”,有负责撰写代码的“程序员”,有负责质量检查的“测试员”。

协作 (Collaboration) 成员之间需要通过明确的沟通协议和工作流程来协作,共同完成一个超越任何单个成员能力的目标。

流程治理 (Process Governance) 组织需要有明确的决策流程、汇报机制和质量控制标准,以确保整体产出的稳定性和可靠性。

动态适应 (Dynamic Adaptation) 组织能够根据外部环境和任务的变化,动态调整其内部结构和工作流程。

作为AI产品经理或架构师,我们的角色也必须随之进化。我们不再仅仅是“提示词工程师”,去想方设法“哄骗”单个大模型说出我们想要的答案。我们必须成为“AI组织架构师”,去设计、搭建和管理一个高效的AI团队。我们的工作,从关注代码和算法,转向关注沟通协议、激励结构和业务流程再造。

三、🧩 Multi-Agent系统 AI“组织智能”的架构蓝图

%20拷贝-cimt.jpg)

如果说单个LLM是一个高智商的“个体贡献者”,那么多智能体系统(Multi-Agent System, MAS)就是围绕一个共同目标组建的“数字化组织”。它模仿人类社会的分工协作,将一个庞大而复杂的任务,拆解给一群拥有不同角色和能力的自主智能体(Agents)共同完成。

3.1 设计理念 从“单体应用”到“微服务”的AI映射

这种设计理念,与软件工程从“单体应用”到“微服务”的演进如出一辙。

一个试图包揽一切的单体LLM,就像一个臃肿的单体应用。它难以维护和扩展,任何微小的改动都可能牵一发而动全身。而且,让一个通用模型同时精通编程、写作、法律和金融,本身就是一件成本极高且效果有限的事情。

而MAS则通过任务分解和专业化分工,带来了更高的灵活性、可扩展性和容错性。我们可以为不同的任务训练或选择专用的小模型(例如,一个专门用于代码生成的Code LLM,一个专门用于法律文书审查的Legal LLM),让它们作为专家Agent,各司其职。这不仅降低了开发和维护成本,也提升了整体系统的性能和可靠性。

3.2 主流架构模式的隐喻与权衡

构建一个MAS,就像设计一份公司的组织架构图。不同的架构模式,决定了AI团队的协作效率、决策流程和最终产出质量。目前,业界已经沉淀出几种主流的架构模式,每一种都对应着一种真实世界中的组织隐喻。

3.2.1 交响乐指挥家 (中心化/主管模式)

这是最直观、最常见的一种模式。它设立一个中心化的“主管Agent”(Supervisor)或“协调器Agent”(Orchestrator),作为整个系统的大脑。主管Agent像一位项目经理,负责理解总体目标、分解任务、分配给专家、监督进度,并最终整合交付。这种模式的优点是控制力强,每一次行动都可以追溯到中心决策者,责任清晰。但它的弱点也同样明显,主管Agent成为了整个系统的瓶颈,一旦它“罢工”或能力不足,整个系统就会瘫痪。

3.2.2 流水线工厂 (序列模式)

这是一种严格线性的工作流,其中一个Agent的输出直接成为下一个Agent的输入,环环相扣,形成一条“AI生产线”。例如,一个内容创作流程可能包含三个Agent,首先,“研究员Agent”负责收集资料;然后它将研究报告传递给“作家Agent”进行草稿撰写;最后草稿被提交给“编辑Agent”进行润色和校对。这种模式非常适合那些流程固定、步骤明确的任务,可靠性高,但牺牲了灵活性。

3.2.3 头脑风暴会议 (并行/并发模式)

在这种模式下,多个Agent会同时从不同的角度处理同一个任务。它们独立进行分析,最后将各自的见解汇总,形成一个更全面、更多维度的决策。例如,在进行一项股票投资分析时,系统可以同时启动“基本面分析Agent”、“技术分析Agent”和“市场情绪分析Agent”,最后由一个“决策Agent”综合所有信息,给出最终的投资建议。

3.2.4 企业集团 (层级模式)

这是最复杂也最强大的模式,它模仿大型企业的组织结构,建立起一个多层级的Agent体系。“CEO Agent”提出年度目标,“副总裁Agent”将其分解为部门KPI,“部门总监Agent”再细化为团队任务,最后落实到每个“员工Agent”的具体工作。这种递归式的任务分解,使得系统能够应对极其复杂的、多方面的宏大问题,但它的实现和管理难度也最高。

3.3 架构选型 风险与控制力的平衡艺术

选择哪种架构,本质上是在“控制力”与“复杂性”之间做权衡。

中心化和流水线模式提供了极强的控制力和可预测性。这对于金融、医疗等高风险、强监管的领域至关重要,因为在这些领域,清晰的审计日志和决策路径是刚需。然而,这种控制力牺牲了系统的弹性和可扩展性。

反之,并行和层级模式拥有更好的扩展性和鲁棒性,但也引入了冲突解决、行为涌现等不可控因素,带来了管理的混乱。

因此,产品经理在设计MAS时,首要任务是评估业务场景对“不确定性”的容忍度。一个用于创意写作的AI团队,可以拥抱“头脑风暴”模式带来的混乱与惊喜;而一个用于自动化财务审计的AI系统,则必须采用“流水线”模式的严谨与可控。架构的选择,必须与任务的风险画像相匹配。

四、🧊 冷酷的现实 为何多数Multi-Agent系统不堪一击

在兴奋地规划你的AI梦之队之前,我们需要一盆冷水来保持清醒。一个被行业选择性忽视的真相是,根据多项学术研究,当前最先进的Multi-Agent系统在处理真实世界任务时,失败率高达60%到80%。

这些失败,早已超越了我们熟知的“模型幻觉”范畴,而是源于系统设计层面的根本性缺陷。这些问题,与其说是技术问题,不如说是管理问题。

4.1 惊人的失败率 被选择性忽视的真相

加州大学伯克利分校的一项名为MAST(多智能体系统失败分类法)的研究,通过对多个主流MAS框架(如AutoGPT, BabyAGI)在超过200个任务中的表现进行分析,为我们绘制了一幅清晰的“AI组织失败地图”。研究结果令人警醒,这些系统的成功率远低于人们的预期,许多任务的成功率甚至不足30%。

这深刻地反映了一个事实,MAS的失败,是人类组织功能障碍的镜像。MAST分类中的每一个问题——需求不清、团队内耗、缺乏质检——都与我们日常工作中导致项目失败的原因惊人地一致。

4.2 MAST 一本AI组织的“失败病历”

研究人员将失败模式归结为三大类,每一类都直指组织管理的要害。

研究论文明确指出,“好的MAS设计需要组织层面的理解,因为即使是由最顶尖的个体组成的组织,如果其结构存在缺陷,也可能导致灾难性的失败”。这意味着,构建强大MAS所需的核心技能,已不再局限于编程和提示词工程,而是扩展到了系统思维、流程设计乃至组织理论。我们需要的,是像COO设计新业务部门一样思考,而不仅仅是像开发者一样写代码。

4.3 生产部署的两大噩梦

除了设计层面的陷阱,将MAS推向生产还意味着要直面两大现实挑战。

4.3.1 不确定性的诅咒与测试地狱

传统软件是确定性的,给定输入,输出永远相同。但基于LLM的Agent本质上是非确定性的。同一个任务,它每次的执行路径和最终产出都可能略有不同。这给测试和质量保证带来了噩梦。

无法编写传统单元测试 你无法为一个Agent的行为编写一个断言其输出永远等于某个固定值的测试用例。

覆盖盲区 测试人员通常只能覆盖少数“理想路径”,而Agent在实际运行中可能走出无数条意想不到的路径,其中隐藏着未知的风险。

回归隐形 对提示词或工具集的微小改动,可能在不经意间破坏整个系统的稳定性,而这种破坏很难通过传统回归测试发现。

4.3.2 “AgentOps”的崛起与运维挑战

运维一个复杂的MAS系统,其难度远超传统软件。它需要一套全新的、结合了DevOps和AI监控的运维理念——“AgentOps”。

你需要解决以下棘手问题。

系统集成 如何让Agent安全、稳定地与公司现有的CRM、ERP等遗留系统进行交互?

安全与隐私 如何为能够访问敏感数据、甚至执行交易操作的Agent建立严密的安全和权限控制机制?

成本监控 MAS的运行成本极高,其Token消耗量可达普通聊天应用的15倍之多。如何实时监控Token消耗和API调用成本,防止预算超支?

合规性 如何时刻关注全球范围内不断变化的AI监管法规,确保系统行为合规,并保留完整的、可供审计的决策日志?

高成本与高风险的组合,决定了当前MAS只适用于那些价值极高、且能容忍一定失败率的领域,例如新药研发、复杂金融建模和前沿科学探索。MAS要想真正走向主流,就必须在降低失败率和运维成本上取得突破。

好的,这是文章的后续部分。

五、🤝 RAG与Agent的融合之道 从“工具”到“生态”

%20拷贝-zhgf.jpg)

我们已经看到,RAG有其“行动鸿沟”,而纯粹的Multi-Agent系统又面临着高昂的失败率。那么,出路在哪里?答案并非二选一的替代,而是深度的融合。RAG并没有“无用”,它只是需要从一个独立的“应用”,进化为一个强大的“能力组件”,被更高级的智能体系统所调用和编排。

5.1 RAG不是被淘汰,而是被“升维”

未来的趋势是,RAG将成为所有复杂AI系统的知识基座。一个没有可靠知识来源的Agent,就像一个没有情报支持的指挥官,其所有决策都是空中楼阁。RAG系统,尤其是经过精心治理和优化的企业级RAG,为Agent提供了坚实的事实基础。

Agent的“长期记忆” RAG为Agent提供了访问海量、动态更新的外部知识的能力,使其摆脱了LLM自身训练数据的局限。

决策的“事实依据” 当Agent需要做出关键决策时,它可以调用RAG来获取相关的政策、法规、历史数据或技术文档,确保其行动有据可查。

行动的“可解释性” Agent的每一个关键步骤,如果都伴随着RAG的引用和溯源,那么整个系统的透明度和可信度将大大提高。

所以,RAG的未来,不是被Agent取代,而是成为Agent生态中不可或缺的“知识服务”。竞争的焦点,将从“如何搭建一个RAG问答机器人”,转向“如何构建一个高质量、高效率、高可用的知识库,并将其作为服务赋能给上层的各种Agent”。

5.2 Agentic RAG 让检索“活”起来

Agentic RAG,或称为智能体增强的RAG,是融合的第一步。它通过引入一个Agent来“驾驶”RAG流程,将原本固定的“检索-生成”工作流,变得动态和智能。

传统的RAG流程是线性的、被动的。而Agentic RAG则是一个主动的、迭代的、自适应的过程。

举个例子,当用户问,“对比我们公司A产品和竞品B在过去两个季度的市场表现、用户反馈和技术架构差异”,传统RAG可能会因为问题过于复杂而检索到一堆不相关的文档。

而一个Agentic RAG系统会这样做。

分解任务 Agent将问题分解为三个子任务。

任务1 查找A和B的市场表现数据。

任务2 查找A和B的用户反馈报告。

任务3 查找A和B的技术架构文档。

执行子查询 Agent为每个子任务生成精准的查询,并调用RAG系统分别执行。

迭代与反思 在检索技术架构时,Agent发现内部文档库缺少竞品B的详细资料。它会启动一个新任务,调用外部工具(如网络爬虫Agent)去公开技术博客和论坛上搜集信息。

综合与生成 Agent将所有收集到的、经过验证的信息整合起来,形成一份结构清晰、逻辑严谨的对比分析报告。

这就是Agentic RAG的威力,它将RAG从一个呆板的工具,变成了一个具备初级规划和问题解决能力的智能助手。

5.3 多智能体RAG 知识协作的新范式

如果说Agentic RAG是一个聪明的“个人贡献者”,那么多智能体RAG(Multi-Agent RAG)则是一个高效的“知识工作团队”。它将Agentic RAG中的不同职能进一步拆分,分配给专门的Agent角色,形成一条知识处理的流水线或协作网络。

一个典型的多智能体RAG团队可能包含以下角色。

查询分析Agent 负责理解用户意图,消除歧义,将复杂问题分解为清晰的子任务。

检索策略Agent 根据任务类型,选择最优的检索组合策略(向量、关键词、图谱、SQL等)。

执行检索Agent(s) 多个并行的Agent,分别对接不同的知识源(内部文档、数据库、外部API、互联网)。

信息综合Agent 负责汇总、筛选、去重所有检索到的信息,形成一个初步的事实集合。

事实核查Agent 对关键信息进行交叉验证,识别并标记出可能存在的矛盾或不一致之处。

报告生成Agent 基于经过核查的事实集合,最终生成流畅、连贯、结构化的回答。

这种架构模式,将RAG的可靠性和Multi-Agent的灵活性完美结合,能够应对极其复杂的、需要多源信息佐证和深度分析的知识型任务。

六、🗺️ 务实落地路线图 从“钢铁侠战甲”到“自治军团”

理论的翅膀再华丽,终究要落在现实的地面上。面对Multi-Agent系统的高失败率和高成本,企业级AI系统的落地绝不能盲目追求完全的自治。我们需要一条务实的、渐进的、可控的路线图。

6.1 核心战略 赋能优于自治 (Augmentation over Autonomy)

在当下,我坚定地站在务实派一边。Andrej Karpathy提出的“钢铁侠战甲”隐喻,为我们提供了最清晰、最可行的行动战略。

不要一开始就试图建造一个全自动的、能够独立作战的“机器人军团”(像电影里的奥创一样),因为我们已经看到,这样的系统脆弱且失败率高。我们应该优先建造“钢铁侠战甲”——一套强大的工具,赋能和增强领域专家的能力,同时将最关键的决策权保留在人类手中。

目标是打造一个高效的“人机协作”闭环,而不是一个脆弱的“全自动”系统。AI应该是专家的副驾驶、分析师的超级助理、医生的第二双眼睛,而不是试图取而代之。

6.2 渐进式自治滑块 (The Autonomy Slider)

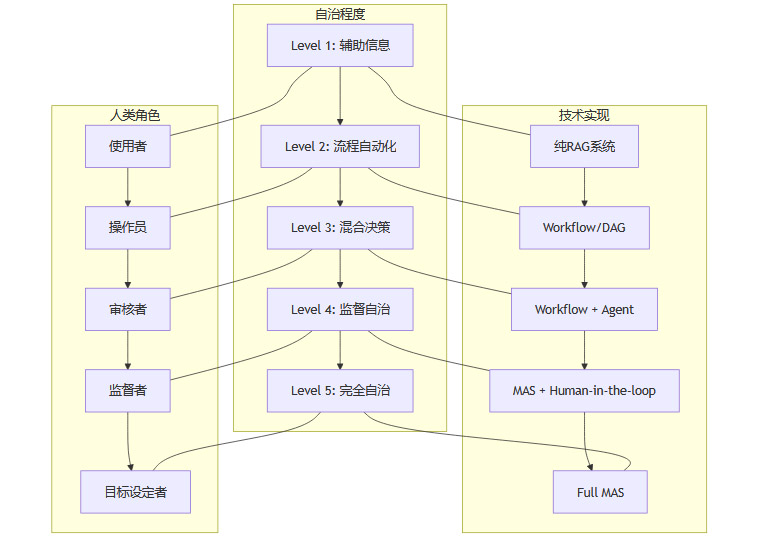

借鉴特斯拉自动驾驶(Autopilot)从L1到L5的发展路径,我们应该以渐进的方式引入自治能力。我们可以设计一个“自治滑块”,根据业务的成熟度和风险可控性,逐步“向上滑动”自治的标尺。

Level 1 辅助信息 (Pure RAG) AI作为信息提供者,回答用户问题,所有决策由人做出。

Level 2 流程自动化 (Workflow/DAG) 将固定的、重复性的业务流程用工作流引擎(如DAG, Directed Acyclic Graph)编排起来,由人触发,AI自动执行。

Level 3 混合决策 (Workflow + Agent) 在固定的工作流中,引入Agent来处理非结构化数据或执行需要一定智能的决策节点,但关键决策点仍需人类审核。

Level 4 监督自治 (MAS + Human-in-the-loop) 允许一个多智能体系统端到端地完成任务,但人类作为监督者,可以随时干预、修正或否决系统的行为。

Level 5 完全自治 (Full MAS) AI系统在设定的目标和约束下,完全自主地规划、执行和完成任务。这是最终目标,但目前在绝大多数领域都遥不可及。

这种渐进式的方式,不仅极大地降低了产品风险,还能在每个阶段都为用户创造切实的价值,并通过收集真实世界的数据,为下一阶段的“自治升级”提供养料。

6.3 混合架构 Workflow的“骨架”与Agent的“血肉”

对于绝大多数企业场景而言,混合架构是当前阶段最理想的选择。它结合了Workflow的稳定可控和Agent的灵活智能。

用Workflow/DAG写死可确定的流程“骨架”。对于业务流程中那些规则明确、路径固定的部分,使用传统的工作流引擎来编排。这保证了系统的核心逻辑是稳定、可预测、可测试的。

在决策节点引入Agent作为“血肉”。当流程遇到需要理解非结构化数据、进行模糊判断或与外部动态环境交互的节点时,就调用一个专门的Agent来处理。

以一个自动化的客户投诉处理流程为例。

[Workflow] 接收投诉 系统通过邮件、IM等渠道接收到客户投诉。

[Workflow] 解析工单 系统从投诉中提取客户ID、订单号等结构化信息。

[Agent] 意图识别与情感分析 调用一个NLP Agent,分析投诉内容,判断客户的核心诉求(退款、换货、技术支持?)和情绪激烈程度。

[Workflow] 规则路由 根据Agent的分析结果,工作流将工单路由到不同的处理路径。

如果情绪激烈,立即升级给人工坐席。

如果是简单退款请求,流转到退款子流程。

[Agent] 生成安抚邮件 调用一个文案生成Agent,根据客户的投诉内容,自动生成一封个性化的安抚邮件,告知客户问题已在处理中。

[Workflow] 执行后续操作 工作流继续执行后续的退款、派单等标准化操作。

在这个例子中,Workflow保证了主流程的秩序和稳定,而Agent则像一个个智能插件,为流程注入了处理不确定性的能力。

6.4 结构化“止损” 为不确定性带上缰绳

即使采用了混合架构和渐进策略,Agent的不确定性依然是悬在我们头上的达摩克利斯之剑。我们必须设计一套结构化的“止损”机制,为Agent的行为设定清晰的边界和护栏。

这是一份可以落地的工程实践清单。

任务与角色的结构化定义 避免给Agent下达模糊的指令。使用结构化格式(如JSON Schema或Pydantic)来定义每个Agent的角色、输入、输出和可用工具,从源头上减少误解。

显性的终止条件 为每个任务设定明确的完成标准和最大执行步数/时间。防止Agent陷入无限循环,造成资源浪费。

对话快照与状态持久化 定期保存Agent团队的对话历史和内部状态。一旦任务失败,可以快速回溯到某个检查点,进行调试和重试,而不是从头再来。

标准化的通信协议 设计Agent之间清晰的通信语言和格式。避免它们因为“黑话”或“误解”而产生协作错位。

分层验证与验收

工具层验证 确保Agent调用的每个工具(API)本身是稳定可靠的。

Agent层验证 每个Agent完成子任务后,需要有一个验证步骤来检查其输出是否符合预期格式和基本逻辑。

系统层验收 整个MAS交付最终结果前,必须经过一个总体验收Agent或人工审核,确保其符合最初的总体目标。

关键决策的交叉复核(Cross-Check) 对于高风险的决策(如执行一笔交易、删除一份重要文件),可以引入“会审”机制,要求至少两个独立的Agent或一个Agent加一个人类审核员共同确认后,方可执行。

通过这些工程手段,我们可以将Agent的“自由发挥”限制在一个可控的框架内,在享受其智能带来的好处的同时,最大限度地规避其不确定性带来的风险。

七、🏁 结论 从“模型工程师”到“AI组织设计师”

%20拷贝.jpg)

让我们回到最初的起点。RAG并非已经“过时”,而是它的单一形态已经触及了天花板。它无法独自跨越从“知道”到“做到”的行动鸿沟。

AI的下半场,是一场关于“组织与协作”的竞赛。

RAG 是坚实的知识底座,提供事实依据。

Workflow 是可靠的流程骨架,保证秩序与稳定。

Agent 是灵活的智能血肉,处理不确定性。

Multi-Agent System 是可扩展的组织架构,应对复杂性。

这四者并非相互替代,而是一个层层递进、能力互补的有机整体。真正的挑战在于,如何根据业务的风险等级和价值密度,将它们进行合理的编排与治理。

这篇文章的核心论点可以总结为一句话,我们的工作正在被重新定义。

我们正在从软件的构建者,转变为智能组织的缔造者。我们的关注点,必须从代码和算法,转向沟通协议和激励结构;从提示词工程,转向业务流程再造。在AI的下半场,能够胜出的公司,将不再是那些仅仅训练出最聪明Agent的公司,而是那些设计出最高效、最可靠的AI组织的公司。

所以,请收起对“奥创军团”不切实际的幻想,拿起工具,开始打造属于你的“钢铁侠战甲”吧。这,才是让AI真正“成事”的唯一路径。

📢💻 【省心锐评】

别再迷信单一模型能包打天下。AI的价值落地,本质是组织工程学问题。用工作流管住底线,用智能体突破上限,这套“混合动力”打法,才是企业现在最需要的。

.png)

评论