【摘要】微软发布“Majorana 1”拓扑量子芯片,挑战以“堆料”纠错为核心的传统量子计算路线。其核心是利用拓扑保护实现内建容错,若成功,将重塑整个算力增长曲线与产业格局。

引言

2025年,量子计算领域迎来了一个工程化的关键节点。微软公司正式发布其“Majorana 1”拓扑量子芯片,这一事件不仅是其二十余年研发投入的一次集中展示,更像是在量子计算发展路径的十字路口,竖起了一块指向全新方向的路牌。长期以来,整个行业被“纠错荒”的阴霾所笼罩,算力的增长几乎被物理比特脆弱性带来的巨大开销所吞噬。

所有主流技术路线,无论是谷歌的超导电路还是IonQ的离子阱,都面临着同一个根本性难题。这个难题并非算法不够精妙,而是承载算法的物理基石——量子比特,实在过于脆弱。微软的拓扑方案,则试图从物理学的最底层重写游戏规则。它不再满足于在脆弱的比特之上构建复杂的纠错大厦,而是致力于打造一种天生就对噪声“免疫”的量子比特。这一路线的成败,将直接决定量子计算是从“实验室奇迹”走向“工业级算力”的进程,是被大大加速,还是继续在工程的泥潭中缓慢前行。

💠 一、 “纠错荒”的本质:物理层面的阿喀琉斯之踵

量子计算的强大威力,源于量子叠加与纠缠的特性。但这种能力也恰恰是其脆弱性的根源。一个量子比特的状态,极易受到环境中最微小的扰动影响,如温度波动、电磁噪声甚至宇宙射线,从而发生退相干(Decoherence),导致计算信息丢失。这使得原始的物理量子比特错误率极高,通常在10−310−3到10−410−4量级,远远无法满足复杂算法(如Shor算法要求低于10−1210−12)的需求。

1.1 主流路线的必然选择:以数量换质量

面对物理比特与生俱来的缺陷,当前行业的主流选择是一种工程上的妥协,即量子纠错(Quantum Error Correction, QEC)。其核心思想与经典计算中的冗余编码类似,通过“以量换质”的方式,用大量不稳定的物理比特来编码和保护一个稳定、可靠的逻辑比特(Logical Qubit)。

编码冗余:将一个逻辑量子比特的信息,分散存储在多个物理比特组成的纠缠态中。当某个物理比特出错时,可以通过测量辅助比特(Ancilla Qubits)来诊断错误类型和位置,并在不破坏量子信息的前提下进行修正。

表面码(Surface Code):这是目前最受青睐的纠错方案之一,因其对物理比特的连接性要求相对较低(只需近邻交互)且拥有较高的容错阈值。但在表面码方案中,编码一个高质量的逻辑比特,通常需要数千甚至上万个物理比特。

这种策略的本质,是将对抗噪声的战场,从物理层转移到了编码与算法层。它带来了一个极其严峻的现实问题,我们称之为**“纠错开销”(Overhead)**。

1.2 纠错开销如何吞噬算力增长

“纠错荒”的困境,并非指我们缺乏纠错算法,而是指实现这些算法所需的物理资源过于庞大,以至于芯片上物理比特数量的增长,很大程度上被纠错开销所抵消。这形成了一个恶性循环。

规模与复杂度的指数级增长:增加物理比特数量,不仅仅是简单的复制粘贴。更大规模的芯片意味着控制线路更复杂、比特间的**串扰(Crosstalk)**更严重、校准和制冷的难度呈指数级上升。这反过来又可能引入新的噪声源,进一步拉高物理比特的错误率。

门操作误差的累积:量子计算不仅比特会错,执行操作的量子门(Gate)同样会出错。一个完整的纠错循环,本身就需要执行大量的量子门操作。如果单次门操作的保真度不够高,那么纠错过程引入的错误甚至可能比它修正的错误还要多。这就引出了**容错阈值(Fault-Tolerance Threshold)**的概念,即物理错误率必须低于某个临界值,纠错才能起到正面作用。

算力增长的“假象”:当一家公司宣布其芯片从100比特增长到400比特时,如果这些新增的比特大部分都被用于纠错,那么实际可用于计算的逻辑比特可能只从1个增加到2个。物理规模的线性增长,并未带来有效算力的同等提升。

下面的表格清晰地对比了物理比特与逻辑比特的核心差异,揭示了“纠错荒”的根源。

主流路线的工程逻辑,本质上是一场与物理定律的“军备竞赛”。其路径依赖是,先不计代价地扩大物理比特规模,然后逐步优化材料和控制技术,将门保真度推高到容错阈值之上,最后期望纠错编码的巨大开销能够被承受。这是一个风险极高的攀登过程,每一步都可能遇到难以逾越的工程峭壁。

💠 二、 拓扑保护:将容错能力“内建”于物理层

面对主流路线的困境,微软选择了一条截然不同、甚至有些“玄学”色彩的道路。拓扑量子计算的核心思想,并非在错误发生后去“纠正”,而是在物理层面创造一种让错误“难以发生”的量子比特。它试图将“抗错性”这个关键属性,从复杂的编码层,前移到最基础的物理层。

2.1 拓扑不变性:从数学洞察到物理实现

这个想法的灵感来源于数学中的拓扑学(Topology)。拓扑学研究的是几何体在连续形变(如拉伸、弯曲,但不能撕裂或粘贴)下保持不变的性质。一个经典的例子是,一个咖啡杯和一个甜甜圈在拓扑学上是等价的,因为它们都有一个“洞”。无论你如何捏塑这个带柄的杯子,只要不破坏它的完整性,那个“洞”的属性始终存在。

拓扑量子计算的目标,就是找到一种物理系统,能将量子信息编码在这种“拓扑性质”中。在这样的系统中,信息不再存储于单个电子的自旋或单个光子的偏振这类**局部自由度(Local Degrees of Freedom)上。因为局部自由度非常容易受到局部环境噪声的干扰。相反,信息被编码在整个系统的全局拓扑自由度(Global Topological Degrees of Freedom)**里。这意味着,任何局部的、微小的扰动,都无法读取或改写被保护的量子信息,除非这个扰动强大到足以改变整个系统的拓扑结构,比如彻底“撕裂”这个系统。

2.2 马约拉纳零能模:拓扑信息的物理载体

如何实现这种物理系统?经过多年探索,凝聚态物理学家提出了一种可能的候选者,即马约拉纳零能模(Majorana Zero Modes, MZM)。这是一种奇异的准粒子(Quasiparticle),它不是基本粒子,而是由材料中大量电子集体行为涌现出的激发态。

MZM最奇特的性质在于,它等于自身的反粒子,并且遵循一种名为非阿贝尔统计(Non-Abelian Statistics)的奇异交换规则。在微软的技术路线中,他们通过精密的纳米制造工艺,将半导体纳米线(如砷化铟 InAs)与超导体(如铝 Al)结合在一起,形成一种半导体-超导杂化结构。在特定的磁场和电场条件下,理论上可以在这根纳米线的两端,分别诱导出一个MZM。

非局域编码:一个拓扑量子比特,由一对空间上分离的MZM构成。例如,一个比特的0和1状态,可以对应这对MZM的不同组合态。由于信息由“一对”MZM共同承载,你无法通过探测其中任何一个MZM来获得完整的量子信息。

内建保护:环境中的局部噪声,比如一个杂散电场,可能只会影响到纳米线的一端。由于它没有同时作用于遥远另一端的MZM,因此无法破坏这个量子比特的整体状态。这就实现了物理层面的内建式保护。

2.3 拓扑量子计算的工程逻辑

如果拓扑保护真的成立,那么量子计算的工程实现逻辑将被彻底改写。

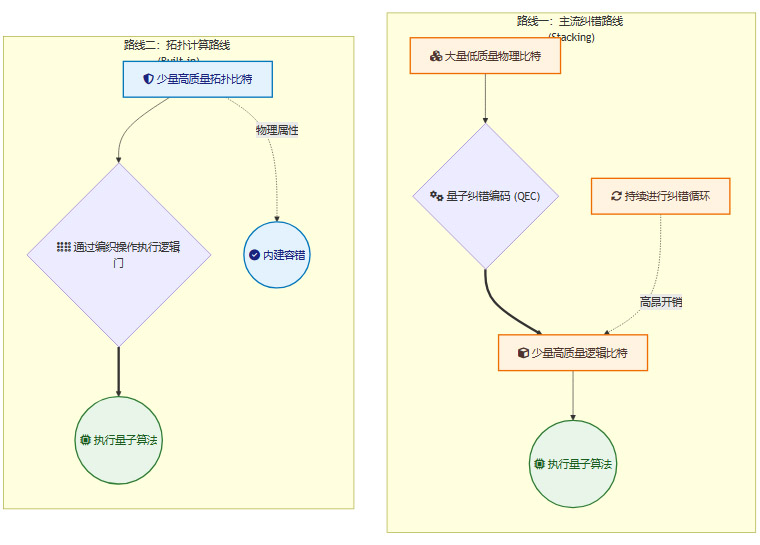

如上图所示,拓扑路线的优势在于:

大幅降低物理错误率:从源头上抑制了错误的发生,理论上可以将物理比特的错误率降低数个数量级。

简化纠错需求:虽然不能完全消除纠错,但可能将“一个逻辑比特需要数千个物理比特”的比例,降低到数十个甚至更少。这使得构建大规模容错量子计算机的资源需求急剧下降。

独特的门操作方式:拓扑量子计算的逻辑门操作,不是通过传统的激光或微波脉冲,而是通过一种名为**“编织”(Braiding)**的物理过程。通过在二维平面上交换MZM的位置,其路径的历史轨迹(即“辫子”)就完成了特定的量子门操作。这种操作方式在理论上也受到拓扑保护,错误率更低。

可以说,拓扑量子比特的核心承诺,就是用基础物理的深度,去换取工程实现的简洁度。这是一场用物理学突破来解决工程瓶颈的豪赌。

💠 三、 “Majorana 1”的争议:科学突破还是工程幻象?

微软发布“Majorana 1”芯片,并宣称其器件展现了符合拓扑量子比特要求的物理特征,这无疑是该领域的一个里程碑。然而,这一发布在收获掌声的同时,也引来了科学界排山倒海的质疑。这种质疑并非空穴来风,而是源于该领域极高的实验难度和一段曲折的历史。

3.1 证据链的“疑点”:零偏压峰并不等于马约拉纳

在寻找MZM的实验中,一个关键的电学信号是零偏压电导峰(Zero-Bias Conductance Peak, ZBCP)。简单来说,当MZM出现在纳米线末端时,测量通过该区域的电流会发现在零电压时出现一个峰值。微软的团队多次在实验中观测到了稳定、清晰的ZBCP,并以此作为其取得突破的关键证据。

然而,科学界很快指出,“看到零偏压峰”并不等于“实现了拓扑量子比特”。凝聚态物理是一个极其复杂的领域,多种物理机制都可能“伪造”出类似的信号。

安德烈夫束缚态(Andreev Bound States):在非拓扑的超导系统中,也可能存在一些能量恰好接近于零的电子态,它们同样能产生ZBCP。

近藤效应(Kondo Effect):材料中的磁性杂质与导电电子的相互作用,也可能在低温下产生一个假的ZBCP。

无序和材料缺陷:纳米线中不可避免的杂质和缺陷,可能导致复杂的量子干涉,偶然形成一个看起来像MZM信号的假象。

因此,学界长期以来的担忧是,研究人员可能把材料缺陷或者其他非拓扑现象,误当成了梦寐以求的拓扑信号。这就好比在寻找一种稀有鸟类的叫声,但丛林中充满了各种可以模仿这种叫声的其他动物。你需要更强的证据链来排除所有这些“模仿者”。

3.2 缺失的“金标准”:编织测试

要真正平息争议,仅靠电导测量是远远不够的。拓扑量子计算的“硬证据”,或者说“金标准”,是对MZM进行**编织(Braiding)**操作,并验证其非阿贝尔统计特性。

编织测试是决定拓扑路线成败的终极验证关卡。它要求研究人员:

可控地创造和移动MZM:需要在芯片上设计出能够精确控制多个MZM位置的结构,比如T形的结。

完成一次完整的交换:让两个MZM绕着彼此运动,交换位置。

测量状态变化:验证这次交换操作是否对量子比特的状态产生了预期的、非平庸的幺正变换。这个变换结果必须符合非阿贝尔统计的理论预测。

可重复性:实验结果必须高度可重复,能够稳定地实现拓扑量子门。

到目前为止,微软(以及全球其他任何研究团队)都未能公开发表一份无可辩驳的、完整的编织实验数据。缺乏这一层面的演示,意味着拓扑路线在很大程度上仍停留在“有趣的器件物理现象”阶段,距离成为一个真正的“量子比特”还有关键的一步之遥。

3.3 历史包袱与开放性呼吁

加剧学界审慎态度的,还有微软团队在2018年的一段历史。当时,其合作团队曾在《自然》杂志发表论文,宣称观测到了MZM的“量子化电导平台”这一更强的证据。但后续审查发现,原始数据处理中存在瑕疵,排除了部分“不理想”的数据点,最终导致论文在2021年被撤回。

这段经历,使得科学界对微软此次发布的新成果,持有更为严苛的审查标准。许多顶尖物理学家公开呼吁,微软需要完全开放其原始数据和分析代码,允许同行进行独立的、无死角的重复验证。正如一位评论家所言,“越是可能改变游戏规则的突破,越需要接受最严苛、最不留情面的同行评审。”

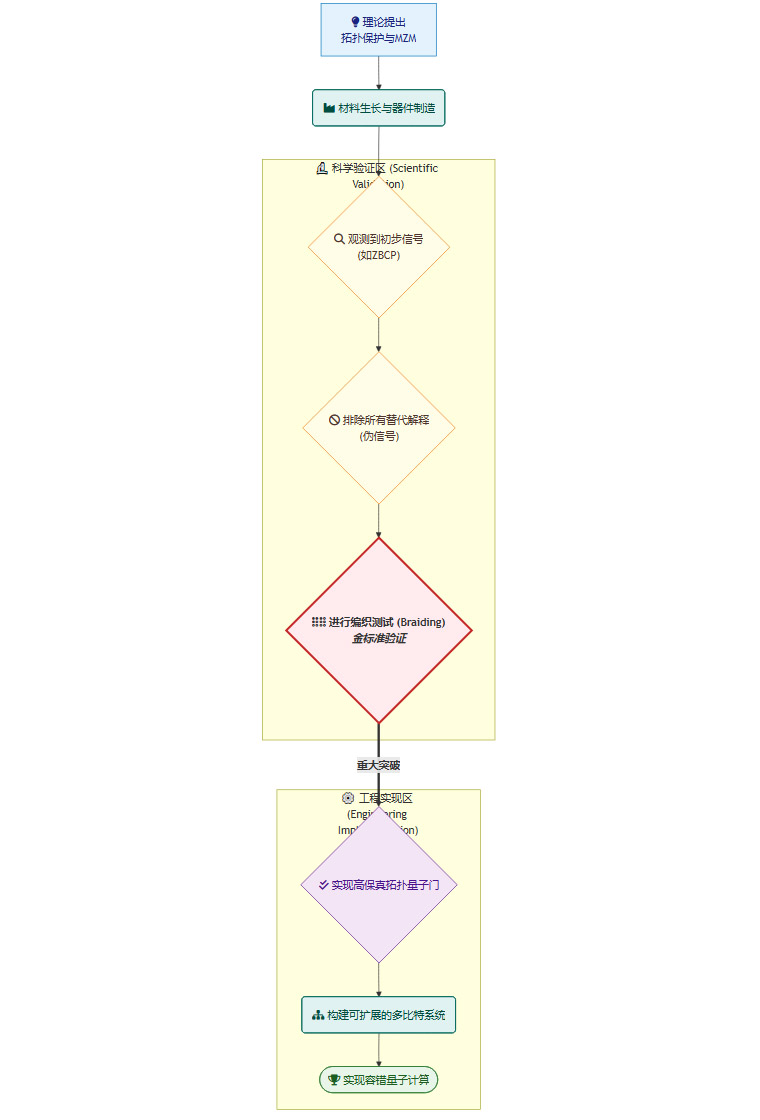

下面的流程图展示了拓扑量子比特从理论到现实所必须跨越的重重关卡。

目前,微软的进展主要集中在C和D阶段,而整个路线的成败,悬于能否跨越关键的E阶段——编织测试。

💠 四、 若赌局功成:产业与社会的连锁反应

如果微软最终能够提供无可辩驳的证据,证明其拓扑路线在工程上是可行的,那么这不仅仅是一家公司的胜利,更将引发整个量子计算产业乃至更广泛科技领域的连锁反应。其影响将从根本上重塑我们对算力增长的预期。

4.1 路线分化与产业格局重塑

拓扑路线的成功,将立刻加剧量子计算领域已经出现的技术路线分化。目前,全球几大巨头正沿着不同的哲学进行布局,形成了一场高风险、高回报的淘汰赛。

微软的高杠杆赌注:微软的策略是典型的**“高风险、高回报”**。他们将宝押在基础物理的突破上,试图一劳永逸地解决纠错这个核心痛点。一旦成功,他们将获得巨大的后发优势,直接“弯道超车”,在硬件层面建立起难以逾越的护城河。

谷歌的渐进式优化:谷歌作为超导路线的领跑者之一,其策略更为务实和渐进。以其2024年发布的“Willow”芯片为例,其核心目标是在现有物理比特框架内,通过改进设计、提升材料质量和优化控制算法,不断降低物理错误率,并演示更高效的纠错编码。他们在表面码纠错方面已经取得了“盈亏平衡”的里程碑,证明了主动纠错在原理上的可行性。

IBM的生态系统整合:IBM则更侧重于构建一个从硬件、软件(Qiskit)到云平台(IBM Quantum Cloud)的完整生态系统。他们通过持续扩大芯片规模(如Kookaburra),并向全球用户开放其量子设备,旨在培养用户社群、积累应用案例,并推动量子-经典混合计算的范式。他们的逻辑是,在硬件尚未完全成熟时,通过软件和云服务来最大化现有“含噪”量子计算机的价值。

下面的表格可以直观地对比这三条路线的战略差异。

拓扑路线的成功,还将引发供应链重心的转移。当前,量子计算的供应链重心很大一部分在复杂的低温控制电子学、高精度微波源和信号处理系统上。而拓扑路线将把重心更多地转移到上游的特种材料生长、原子级精度的纳米制造工艺以及极低温下的器件良率控制上。

4.2 应用爆发:从理论模拟到现实创造

一旦可扩展的、容错的量子计算机成为现实,其算力将首先在那些传统计算机难以企及的领域掀起革命,这些领域通常涉及复杂的量子系统模拟。

制药与生命科学:当前,发现一种新药平均需要10年以上的时间和数十亿美元的投入。其中大量时间耗费在分子的筛选和临床前试验上。一台百万级逻辑比特的量子计算机,可以在几分钟内精确模拟一个复杂蛋白质(如病毒的刺突蛋白)与候选药物分子的相互作用。这意味着科学家可以进行**“in-silico”**(在计算机中)的药物设计,不再是盲目试错,而是直接“打印”出最有效的分子结构,将药物研发周期缩短一个数量级。

材料科学与能源:人类社会面临的许多重大挑战,都与材料相关。

常温超导体:量子计算机可以精确模拟材料的电子结构,帮助科学家设计出在室温常压下实现零电阻的超导材料。这将彻底改变全球的能源传输网络,消除电力损耗。

高效催化剂:化肥生产依赖的哈伯-博斯法(Haber-Bosch process),消耗了全球约2%的能源,并产生大量碳排放。量子计算机可以模拟固氮酶的催化过程,帮助设计出在温和条件下就能高效固氮的新型催化剂,从根本上改变农业和能源格局。

金融与优化:在金融领域,量子算法(如量子蒙特卡洛模拟)可以更精确地为金融衍生品定价、评估市场风险。在物流、交通、制造业等领域,量子计算机能够解决目前无法处理的超大规模组合优化问题,例如为全球数万个航班和机组人员规划最优路线,从而节省巨额成本。

4.3 安全外溢:PQC迁移的紧迫性

量子计算最广为人知的威胁,是其对现有公钥密码体系的毁灭性打击。基于大数分解(如RSA)和离散对数(如ECC)的加密算法,在Shor算法面前将不堪一击。

真正的威胁时间表,不取决于物理比特的数量,而取决于**“可用逻辑比特”**的出现时间。拓扑路线的潜在突破,正是加速这一时间表到来的最大变量。它可能在数年内,将实现数百个逻辑比特的门槛,从遥不可及变为近在眼前。

这催生了**“先收集,后破解”(Harvest Now, Decrypt Later)**的现实威胁。敌对机构可以现在就大规模截获和存储加密的敏感数据(如国家机密、商业情报、个人隐私),等待未来量子计算机成熟后再进行解密。

因此,全球范围内部署**抗量子密码(Post-Quantum Cryptography, PQC)**的紧迫性,与拓扑计算等颠覆性路线的进展直接挂钩。企业和政府机构不能再持观望态度,必须立即启动向PQC算法的迁移规划与密钥更新策略,这是一场与量子算力发展赛跑的“安全倒计时”。

4.4 职业与教育的认知迭代

量子时代的到来,将引发一场深刻的职业结构转型。高薪人才的洼地,将从传统的软件开发,转向更深层次的交叉学科领域。

量子算法工程师:他们需要深刻理解量子力学原理,设计能够在新硬件上运行的算法。

量子纠错架构师:无论是主流路线还是拓扑路线,纠错依然是核心。这个角色需要设计和实现高效的纠错协议。

量子材料科学家:尤其对于拓扑路线,能够生长出完美晶格、缺陷极少的半导体-超导材料的专家,将成为产业链的基石。

量子系统验证与校准工程师:负责确保庞大而复杂的量子系统能够精确、稳定地运行。

为了应对这一变革,全球的教育体系也正在悄然升级。从顶尖大学的物理和计算机系,到基础教育阶段的科普,量子科学与技术的知识正在被加速普及。2025年被联合国定为“国际量子科学与技术年”,正是这一全球趋势的体现。

结论

微软的“Majorana 1”芯片及其所代表的拓扑路线,为深陷“纠错荒”的量子计算领域,打开了一扇充满想象力的大门。它不再是现有路线的修补和改良,而是一次对问题根源的直接挑战,试图用物理学的优雅,一举解决工程学的笨拙。若能成功,量子计算的发展曲线将被重绘,从渐进式的线性增长,突变为爆发式的指数增长。

然而,从一个充满争议的物理现象,到一个稳定可靠的工程器件,再到一个可扩展的计算系统,这条道路上依然布满了荆棘与迷雾。科学的严谨性要求我们,在看到无可辩驳的、可重复的编织实验证据之前,必须保持审慎。这场围绕不同技术路线的竞赛,本质上是一场长期的淘汰赛。它考验的不仅是技术实力,更是战略耐心和对基础科学的持续投入。

最终的现实,很可能是一个阶段性的演进过程。短期内,争议与验证将持续并存;中期,各路线将进入残酷的工程化对决,比拼谁能率先拿出有意义的逻辑比特;长期来看,只有那条能够在算力扩展性、经济成本和工程可行性这三个维度上取得最佳平衡的路线,才能最终胜出,握住开启下一个计算纪元的金钥匙。

📢💻 【省心锐评】

拓扑路线是物理学对工程学的豪赌。赌赢了,量子计算将跳过蹒跚学步,直接进入冲刺阶段;赌输了,行业仍需在纠错的泥潭中继续跋涉。

.png)

评论