【摘要】微软RE-IMAGINE框架揭示,当前AI模型在面对题目微小变化时推理能力大幅下降,暴露出“死记硬背”本质。本文深度解析该研究的技术细节、理论基础、实验方法与行业影响,探讨AI推理能力的边界与未来挑战。

引言

人工智能(AI)在近十年取得了令人瞩目的进步,尤其是以GPT、Gemini、Claude等为代表的大型语言模型(LLM),在各类标准化测试中屡屡刷新纪录,甚至在部分推理任务上超越了人类平均水平。AI的“聪明”似乎已成为共识,许多行业和个人对其寄予厚望。然而,AI的“聪明”究竟是理解,还是记忆?当题目稍作变化,AI还能像人类一样灵活应对吗?

2025年6月,微软研究院剑桥分校与印度分校的研究团队联合发布了一项重磅研究,提出了RE-IMAGINE框架,系统性地检验了当前主流AI模型的推理能力。研究结果令人警醒:即便是最先进的AI模型,在面对题目中数字、变量名等微小变化时,准确率也会大幅下降,暴露出“死记硬背”的本质。这一发现不仅挑战了我们对AI能力的认知,也为AI的安全应用、模型训练和未来发展指明了新的方向。

本文将围绕RE-IMAGINE框架的理论基础、技术实现、实验设计、核心发现、行业影响及未来展望,进行全方位、深层次的剖析。无论你是AI开发者、研究者,还是关注AI应用的行业人士,都能从中获得有价值的洞见。

一、RE-IMAGINE框架的理论基础与设计理念

1.1 研究背景:AI推理能力的质疑

1.1.1 AI的“高分”与“理解”之谜

近年来,AI模型在各类标准化测试中表现优异,甚至在数学、逻辑、代码等推理任务上超越了人类平均水平。许多AI产品宣传其“推理能力”,但这些能力究竟是“理解”还是“记忆”?研究者们发现,AI模型可能只是记住了训练数据中的答案模式,而非真正掌握了解题的逻辑。这一现象在实际应用中屡见不鲜:AI在标准题库中表现优异,但面对稍有变化的新题时却频频出错。

1.1.2 朱迪亚·珀尔的“因果推理阶梯”理论

微软团队受到著名统计学家朱迪亚·珀尔(Judea Pearl)提出的“因果推理阶梯”理论启发。该理论将人类认知分为三个层次:

观察(Seeing):仅仅观察世界,描述发生了什么。

干预(Doing):主动改变某些条件,观察结果如何变化。

反事实(Imagining):思考如果历史条件不同,结果会怎样。

这一理论为AI推理能力的分层评估提供了坚实的理论基础。

1.2 RE-IMAGINE框架的三层次推理评估体系

RE-IMAGINE框架以“因果推理阶梯”为蓝本,设计了三层次的推理能力测试:

1.2.1 观察层面

AI模型需解答原始、未经修改的题目。此类题目与训练数据高度相似,考查模型的记忆与基础推理能力。

1.2.2 变化层面

对原题进行微调,包括:

改变数字(如5变7)

更换变量名(如“小明”变“李雷”)

添加无关信息(如“小明住在北京”)

这些变化对人类几乎无影响,但对AI模型却是巨大挑战。

1.2.3 想象层面

在原题基础上引入新条件、反事实设定,甚至与原有条件冲突,考查模型的复杂推理与因果理解能力。

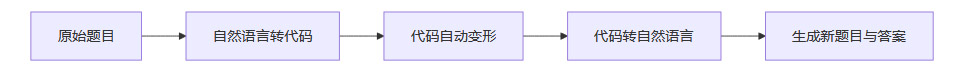

1.3 “问题变形工厂”:自动化题目生成系统

1.3.1 系统原理

RE-IMAGINE框架的核心创新之一,是开发了一个自动化的“问题变形工厂”。其流程如下:

1.3.2 系统优势

高效自动化:可批量生成成千上万道题目变体,极大提升测试规模与一致性。

多领域适用:支持数学、代码、逻辑等多种题型。

自动标注答案:每道新题自动生成标准答案,便于大规模评测。

二、RE-IMAGINE框架的实验设计与评测体系

%20拷贝-hmbt.jpg)

2.1 多领域基准测试集

研究团队在四个领域的权威数据集上验证了RE-IMAGINE框架:

2.2 题目变形类型与实验变量

2.2.1 题目变形类型

数值变形:仅改变题目中的数字

变量名变形:更换人名、变量名等

无关信息添加:插入与解题无关的描述

逻辑条件变形:添加、修改或冲突条件

代码微调:如加号变减号、字符串内容变化

2.2.2 实验变量控制

为确保性能下降源自题目变化本身,研究团队严格控制:

推理步骤数量:变形题与原题推理复杂度一致

题目长度与结构:避免因题目变长或结构变化引入额外难度

2.3 评测指标与方法

准确率:模型答对题目的比例

性能下降幅度:变形题与原题准确率差异

模型规模对比:不同参数量模型的表现差异

领域泛化能力:跨领域题目变形下的表现

三、核心实验发现与技术解读

%20拷贝-okve.jpg)

3.1 数学推理测试:微小变化即致准确率大幅下降

3.1.1 数值变形的冲击

在GSM8K小学数学题测试中,研究团队发现:

原题准确率高达95%

仅仅改变题目中的数字,准确率下降约10%

变量名变形、无关信息添加也会导致不同程度的性能下降

这意味着,AI模型在面对“见过的题”时表现优异,但对“变形题”适应性极差。

3.1.2 模型规模与抗干扰能力

大模型(如GPT-4、GPT-o1)在无关信息干扰下表现相对较好,能部分过滤“噪音”

小模型(如Llama-2-7B)更容易被无关信息误导,准确率下降更明显

3.1.3 “想象”层面测试的严峻挑战

在添加新条件、反事实设定后,所有模型准确率均大幅下降

即使是最先进的GPT-o1模型,也难以应对复杂逻辑变化

3.2 代码理解测试:模式记忆的局限性

3.2.1 代码微调的影响

在CRUXEval和Loop测试中,哪怕仅将加号改为减号,或更改字符串内容,模型准确率也会明显下降

说明模型对代码的理解更多依赖于“模式记忆”,而非真正的语义推理

3.2.2 代码逻辑变形的挑战

复杂的循环不变量推理、条件分支变化,模型表现更差

反映出当前AI模型在代码理解上的“脆弱性”

3.3 因果推理与“双重反事实”测试

3.3.1 实验设计

“双重反事实”测试:判断“如果原因发生,结果会出现”与“如果原因不发生,结果不会出现”

旨在检验模型对因果关系的真实理解

3.3.2 结果分析

所有模型在该测试中表现不佳

暗示当前AI系统在因果推理方面存在重大短板

3.4 训练示例多样化的提升作用

3.4.1 实验发现

在训练时同时提供原题与变形题,模型在变化题目上的表现显著提升

但在“想象”层面(复杂逻辑变化)下,提升有限

3.4.2 启示

多样化训练有助于提升模型泛化能力

但仅靠增加数据量,难以根本解决推理能力不足的问题

四、RE-IMAGINE框架的技术创新与行业意义

4.1 技术创新点

4.1.1 自动化题目变形系统

实现了题目-代码-题目的自动转换与变形

支持大规模、系统化的推理能力评测

4.1.2 多领域适用性

同一套框架可应用于数学、代码、逻辑等多领域

具备极强的扩展性与通用性

4.1.3 系统性评估体系

三层次设计全面反映模型推理能力

可作为AI推理能力评测的行业标准

4.2 行业应用与现实意义

4.2.1 AI安全与可靠性

AI系统在医疗、自动驾驶等关键领域应用广泛

如果仅靠“死记硬背”,面对新情况时极易出错,带来安全隐患

4.2.2 AI教育与培训

当前模型训练方法以大数据统计学习为主

研究表明,仅靠增加数据量难以获得真正的推理能力

未来需开发更注重逻辑结构理解的训练方法

4.2.3 AI产品开发与部署

开发者应重视模型在“新题”上的表现,而非仅关注标准测试集成绩

设计AI应用时需考虑模型的泛化能力与安全机制

4.2.4 政策制定与行业监管

理解AI模型的局限性,有助于制定更科学的行业标准与监管政策

特别是在安全关键领域,需加强人工监督与风险防控

五、理论反思与未来展望

%20拷贝.jpg)

5.1 “什么是真正的智能?”的再思考

如果AI只能在“见过的题”上表现优异,面对新情况就出错,是否称得上“智能”?

这不仅是技术问题,更是哲学与认知科学的核心议题

5.2 未来研究方向

5.2.1 更强的推理模型架构

探索结合符号推理与神经网络的新型架构

加强模型的逻辑结构理解与因果推理能力

5.2.2 训练方法创新

设计更具挑战性的训练任务,促进模型主动“思考”而非“背诵”

引入多样化、反事实、跨领域的训练样本

5.2.3 泛化能力与安全机制

研究如何提升模型在“未见过题型”上的表现

构建更健壮的AI安全防线,防止模型在新场景下“翻车”

5.2.4 通用推理能力评测工具

推动RE-IMAGINE等框架成为行业通用的推理能力评测标准

促进AI研究社区在模型评估方法上的协作与进步

结论

微软RE-IMAGINE框架的研究为AI推理能力的评估与提升提供了全新视角。研究结果清晰地表明,当前AI模型在面对题目微小变化时,推理能力大幅下降,暴露出“死记硬背”的本质。这一发现不仅对AI技术本身提出了更高要求,也为AI的安全应用、模型训练、行业监管和未来发展指明了方向。

AI的未来,绝不仅仅是“背题高手”,而应成为真正理解世界、具备灵活推理能力的智能体。RE-IMAGINE框架的提出,是AI走向“理解”而非“记忆”的重要一步。对于AI开发者、研究者、行业应用者乃至政策制定者而言,这项研究都具有深远的启示意义。

📢💻 【省心锐评】

“AI推理短板暴露无遗,RE-IMAGINE框架敲响警钟。技术再炫,也别忘了逻辑才是智能核心,未来路还长!”

.png)

评论