【摘要】揭示AI产品在成本与体验间博弈的核心策略——提示词路由。文章深入剖析其降本增效的商业价值、潜在的用户信任风险,并提供一套兼顾透明、可控与安全的系统化落地方法。

引言

你或许有过这种经历。

问AI“今天天气怎么样”,它能秒回。

让它“写一份母婴电商创业的商业计划书,包含未来三年的现金流预测”,它就明显“慢”了下来,仿佛在深度思考,过一会儿才交出一份像模像样的答卷。

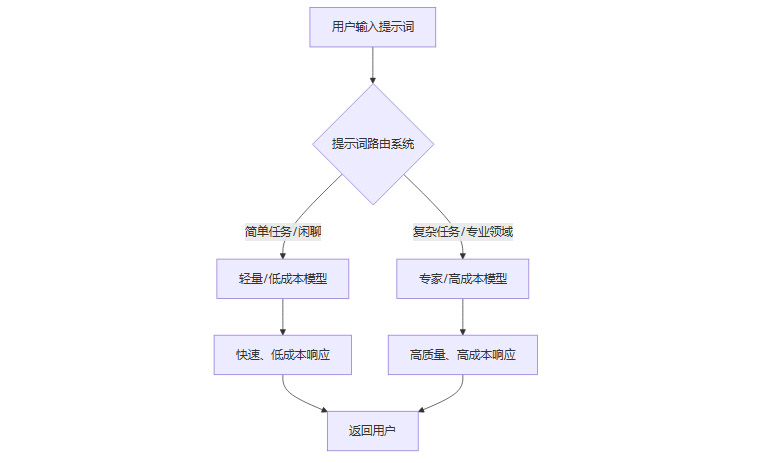

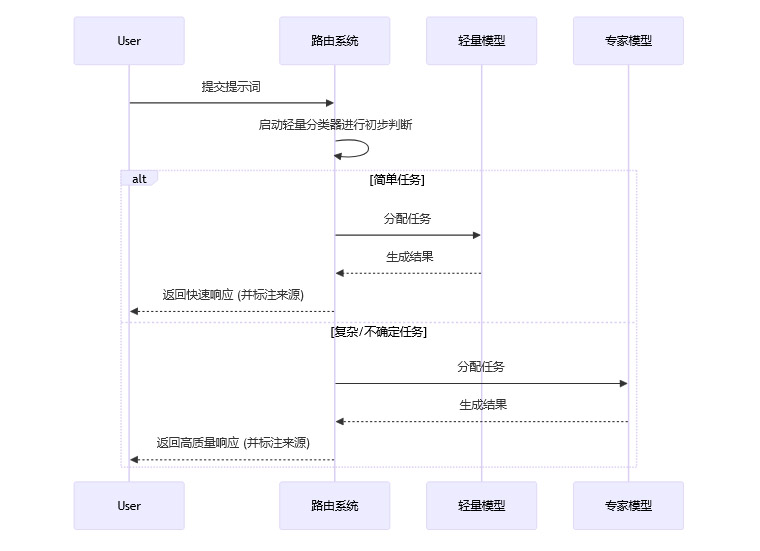

这并非AI的情绪波动,而是你正在亲历一场席卷整个行业的静默革命——提示词路由(Prompt Routing),也叫模型路由(Model Routing)。

简单说,在你提交问题的瞬间,系统就给你的任务打了标签。你的提示词随即进入一个智能调度室,被指派给不同“能力”和“身价”的大模型。简单问题,交给最便宜、最快的“实习生模型”;复杂难题,立刻呼叫最贵、最强的“专家模型”。

这套“看人下菜”的机制,正悄悄改变着我们与AI互动的方式,也深刻影响着AI产品的商业命脉。它是一门在效率与信任之间走钢丝的艺术,既可能成为产品续命的良药,也可能沦为侵蚀用户根基的毒药。

一、AI的十字路口:从“秀肌肉”到“精打细算”

%20拷贝-uodq.jpg)

1.1 “大力出奇迹”的蛮荒时代

AI大模型的早期,是一个“秀肌肉”的时代。

各家公司都在比拼谁家的模型参数更多、能力更强、在各种跑分测试中拔得头筹。那是一个用绝对算力“大力出奇迹”的阶段,仿佛谁的“大脑”最强,谁就能赢得未来。产品逻辑也极其简单粗暴,即用最强的模型应对所有用户的全部请求。

这种策略在技术验证阶段无可厚非,但当产品走向市场,一个极其现实的问题便浮出水面。

1.2 成本,那把悬在头顶的剑

成本。

运行一次像GPT-4或Gemini Pro这样的顶级模型需要多少钱?每一次交互的背后,都是数据中心里成千上万张昂贵GPU燃烧的电费。英伟达的CEO黄仁勋就曾直言不讳地指出,AI的推理成本“高得惊人”。

更让AI巨头和创业公司CEO们心惊肉跳的是,他们通过数据分析发现,用户问得最多的问题,居然是“你好”、“你叫什么”、“讲个笑笑话”这类简单交互。据统计,超过90%的用户请求,其复杂度和价值都远低于顶级模型的处理能力上限。

让一个“爱因斯坦”级别的大脑,天天回答这种问题,成本高到离谱。

这就像你倾尽家产组建了一支F1车队,结果发现90%的业务是送外卖。

一个尴尬的局面出现了,产品体验越好,用户规模越大,公司可能亏得越快。AI产品之间的竞争,正在从一个单纯比拼“智商”的游戏,演变成一个同时比拼“财商”的残酷生存战。

1.3 “提示词路由”的应运而生

在这种背景下,做AI产品的指导思想发生了根本性转变,从“活儿好”转向“活下去”。

一个成功的产品必须同时具备价值、可用性、技术可行性和商业可行性。疯狂烧钱的模式,显然违背了最后一条。于是,“提示词路由”应运而生,它不再是锦上添花的技巧,而是关乎生死的续命良药。

它的核心思想很简单,大家终于想明白了,AI产品实现高效的关键,不是用最强的大脑解决所有问题,而是用最合适的资源,去解决合适的问题。就像你不会用牛刀去杀鸡,也不会让一个公司的CEO去回复每一封客服邮件。

提示词路由的本质,是一个智能的、自动化的任务分发系统。它通过对用户输入(提示词)进行快速分析,判断其意图、复杂度和领域,然后像一个交通警察一样,将任务导向最匹配的模型处理。

通过这种方式,AI产品得以在保证关键任务质量的同时,大幅削减不必要的开支,从而走向商业上的可持续发展。

二、💡 提示词路由的价值罗盘,不止于省钱

提示词路由带来的好处是多维度的,它不仅直接作用于成本,更深远地影响着产品体验、规模化能力和未来的迭代效率。

三、⚔️ 看不见的降级,看得见的风险

%20拷贝-vpiv.jpg)

听起来很美,对吧?高效、省钱,用户还能更快得到简单问题的答案。

但只要这套系统不透明,一个念头就会开始在用户心中盘旋——“我被‘降级’处理了吗?”

这就是提示词路由背后,那把悬在所有AI产品头上的达摩克利斯之剑。它在带来效率的同时,也伴随着一系列不容忽视的风险。

3.1 路由错误的灾难性后果

这是最直接、最致命的风险。

如果系统判断失误,把一个复杂且严肃的问题路由给了一个知识库不全、推理能力差的“实习生模型”,后果可能不堪设想。

想象一下以下场景:

医疗咨询:用户输入“我最近总是头疼,伴有视力模糊,帮我分析一下可能的原因”,系统误判为简单问题,调用了一个基础模型,给出了“可能是压力大,多休息就好”的泛泛之谈,从而延误了用户就医。

法律求助:用户描述了一个复杂的合同纠纷,希望AI分析其中的法律风险,但系统将其分配给了一个不具备专业法律知识的模型,生成了存在严重漏洞的建议。

金融决策:用户要求分析某支股票的财报并预测未来走势,一个能力不足的模型可能会基于过时或错误的数据,给出一个误导性的投资建议。

在这些高风险领域,一次路由错误,轻则贻笑大方,重则可能危及用户的财产、健康乃至生命。

3.2 用户信任的致命侵蚀

当路由机制不透明时,信任的堤坝便会开始出现裂缝。

当用户开始怀疑自己提交的每一个复杂任务,是否都被系统“偷偷地”用一个更便宜、更笨的模型处理了,信任就开始崩塌。他们会觉得产品在“糊弄”自己,尤其是在付费服务中。

这种感觉,就像你花五星级酒店的钱,却怀疑自己住的房间用的是快捷酒店的床单。

哈佛商学院的教授 Shoshana Zuboff 在其著作《监控资本主义时代》中深刻地描述了这种信息不对称带来的权力失衡。当用户无法知晓背后运行的机制时,他们就从“使用者”沦为了被操纵的“数据源”。这种不确定性和被蒙蔽感,会极大地损害用户忠诚度和付费意愿。

3.3 “体验黑箱”带来的持续猜疑

因为路由策略不透明,用户永远不知道自己得到了多大程度的服务。这种“黑箱”操作,会让最忠实的用户也变得斤斤计较。

他们会反复测试,试图找出规律。

“我用同样的问题问了三次,为什么两次快一次慢?”

“是不是我加上‘请详细分析’这几个字,它就会调用更好的模型?”

“这个回答看起来有点敷衍,是不是给我用的便宜模型?”

这种持续的猜疑会消耗掉用户对产品的热情,让他们从一个轻松的使用者,变成一个时刻提防的“测试员”。长此以往,用户粘性将不复存在。

3.4 产品伦理与合规风险

在医疗、金融、法律等受到严格监管的行业,随意对模型进行“降级”处理,可能不仅仅是体验问题,更可能触犯行业规范和法律法规。

例如,如果一个AI医疗诊断产品为了节省成本,在分析关键病例时使用了未经认证的低配模型,一旦出现误诊,产品方将面临巨大的法律诉讼和合规处罚。

3.5 安全攻击面的扩大

路由系统本身也可能成为新的攻击目标。恶意行为者可能通过构造特定的提示词,来欺骗路由分类器。

提示词注入:在看似简单的请求中,注入恶意指令,试图让低权限的“实习生模型”执行越权操作。

角色重定义:通过复杂的伪装,让分类器误判任务类型,从而以低成本调用高权限模型,进行资源滥用。

这些攻击都需要在路由的前端设置有效的判别与护栏策略,否则整个系统的安全性将受到威胁。

一个现实的案例是,部分平台在处理涉及用户情绪或敏感话题的内容时,会自动将请求路由到一个经过严格审查的“安全版”模型,但这个过程对用户完全不透明。这虽然保证了内容安全,却也引发了关于用户知情权和平台透明度的广泛争议,凸显了在路由设计中平衡安全与透明的重要性。

四、⚙️ 落地实践:在“偷懒”与“糊弄”之间走钢丝

真正的智能,要知道自己的边界,懂得用更小的代价,撬动更大的价值。这正是商业社会运转的基本法则。

一个懂得动态分配资源、实现效率最大化的系统,无疑是更聪明的。但这种“聪明”必须有一个不可动摇的底线,那就是对用户价值的绝对尊重。

“偷懒”(高效地使用资源)和“糊弄”(以次充好欺骗用户)之间,隔着一条名为“透明”与“信任”的鸿沟。以下是一套系统化的落地方法,旨在帮助AI产品在享受降本增效红利的同时,守住信任的底线。

4.1 奠定基石:透明化与用户可干预

这是所有策略的出发点,也是建立信任的第一步。

路由透明化:在AI生成的回答末尾,用小字或图标清晰地标注本次服务由哪个级别的模型提供。例如,“由轻量模型提供支持”或“由专家模型深度思考”。这保障了用户的基本知情权。

用户可干预:在输入框附近提供一个选项,允许用户手动选择“我需要最高质量的回答”。哪怕这意味着需要更长的等待时间和更高的费用(在付费产品中),也要把最终的选择权还给用户。这让用户从被动的接受者,变为了主动的参与者。

4.2 构建路由核心:分类、分层与分发

这是路由系统的技术核心,决定了其准确性和效率。

4.2.1 建立任务分层标签体系

首先,需要定义一个清晰的任务分级标准。这通常是一个多维度的评估体系。

4.2.2 设计高效的路由分类器

有了标签体系,就需要一个分类器来自动给任务“打标签”。

轻量级前置分类:最常见的做法是,先用一个非常便宜、快速的小模型或者传统的机器学习模型(甚至是规则引擎)作为“前台接待”。它只负责对任务进行粗略的分类,判断出“极简单”、“极复杂”和“不确定”这几类。

二段式路由:对于“不确定”的复杂任务,可以采用“二段式”路由。第一阶段由轻量分类器判断其大致方向,第二阶段再由一个能力稍强的模型进行更精细的判别,最终决定是否调用最顶级的“专家模型”。

4.3 设置安全网:双阈值保障机制

为了防止灾难性的路由错误,必须建立严格的“安全网”。

领域强制阈值:在系统层面设定一个“强制高配”的领域列表。一旦检测到用户的请求涉及医疗、法律、金融等预设的高风险领域,无论分类器如何判断,系统都应强制调用最高级别的模型。在这里,安全和专业性拥有绝对的优先权,绝不能为了节省成本而妥协。

不确定性阈值:为路由分类器设定一个置信度阈值。如果分类器对某个任务的判断置信度低于这个阈值(比如,它有60%的把握认为是简单任务,40%认为是复杂任务),系统应采取保守策略,自动升档,将其交给更高级别的模型处理,以防误判。

4.4 衡量效果:建立质量与成本的KPI体系

一个没有度量的系统是无法优化的。需要建立一套清晰的KPI来持续监控路由系统的表现。

质量维度KPI

成本与效率维度KPI

4.5 驱动进化:反馈与持续优化的闭环

路由系统不是一成不变的。它需要通过持续学习来变得更聪明。

结构化反馈:除了简单的“赞”和“踩”,应提供更结构化的反馈选项,如“回答不准确”、“不够详细”、“偏离主题”等。这些标签可以直接用于优化路由分类器和模型本身。

自动化评估:利用AI来评估AI。可以训练一个专门的“评估模型”,自动对生成结果进行打分,并将低分样本和路由决策进行关联分析,找出路由策略的薄弱环节。

A/B测试:对于新的路由策略,不要全量上线。通过A/B测试,在小部分用户中验证新策略对质量和成本KPI的影响,确认效果后再逐步推广。

将“提示词修改 -> 路由决策 -> 结果评估 -> 策略优化”的全流程自动化,可以极大地降低试错成本,实现路由系统的高效迭代。

4.6 前置护栏:安全第一

在所有流程开始之前,必须先进行安全检查。

轻量级前置判别器:在请求进入路由系统之前,先用一个极快的轻量编码器或规则引擎作为“门卫”,专门拦截已知的恶意输入,如提示词注入、越狱攻击等。这比在主流程中处理更高效、更安全。

高风险语域的拒绝/替代方案:对于明确处于伦理边界之外或法律禁止的请求,系统不应尝试去“智能”处理,而应明确拒绝,并尽可能提供安全、可行的替代路径(如“我无法提供医疗建议,请咨询专业医生”)。

4.7 留存证据:日志与合规

最后,必须记录下每一次路由决策的全过程。

详细的日志应包括用户原始提示词、路由分类器的判断依据、最终选择的模型、模型的输出结果以及质量评分。这些记录不仅是未来优化策略的数据金矿,更是在出现用户争议或合规审计时,能够明确“为什么当时会这样路由”的关键证据。

五、🔭 未来趋势:更聪明的调度,更深的信任

%20拷贝-wzst.jpg)

提示词路由技术本身也在快速进化。未来,我们将看到更智能、更值得信赖的路由系统。

智能化与个性化:未来的路由系统将不仅仅基于单次的提示词,还会结合用户画像、历史交互行为和上下文语境,进行更加个性化和动态的决策。它会“认识”你,知道你是一个偏好深度内容的专家,还是一个喜欢轻松闲聊的用户。

多模型协同(Mixture of Experts, MoE):更高级的路由不再是“非A即B”的选择题,而是演变为一个协作任务。系统可能会将一个复杂问题拆解,让擅长数据分析的模型处理数据部分,让擅长文字生成的模型组织语言,最终协同完成一个高质量的回答。

伦理与合规内嵌(Ethics by Design):合规要求和伦理底线将不再是事后检查的补丁,而是会直接被写入路由规则的核心。系统在设计之初,就会被植入不可逾越的红线,自动规避高风险操作。

用户信任为核心:最终,所有的技术进化都会回归到同一个原点——用户信任。一个无法赢得用户信任的AI产品,无论技术多么先进,成本多么低廉,都注定没有未来。因此,透明、可干预、价值优先,将永远是提示词路由设计的黄金法则和核心护城河。

结论

提示词路由的真正意义,不是“用最强的大脑解决所有问题”,而是“用最合适的资源解决合适的问题”。它标志着AI产品的发展,从一个纯粹的技术竞赛,步入了一个技术、商业和用户价值三者共舞的成熟阶段。

在这场平衡的艺术中,一味追求技术上的“最强”,会死于成本;一味追求成本上的“最低”,则会死于用户的抛弃。

一个可持续的AI产品,不仅要算得清财务账,更要守得住信任账。只有在透明、可控、绝对尊重用户价值的前提下,对AI资源进行动态、高效的分配,才能在激烈的竞争中真正地“活下去”,并赢得长远的未来。用户的信任,永远都是这个时代最稀缺、也最宝贵的资源。

📢💻 【省心锐评】

技术上的‘聪明’,若以牺牲用户信任为代价,终将是商业上的愚蠢。路由的终点,应是价值,而非成本。

.png)

评论