【摘要】大模型中间件作为AI基础设施的关键枢纽,正深刻重塑大模型的高效部署与算力调度格局。本文系统梳理了中间件在算力调度、适配层、平台化、容器化、服务化、弹性化等方面的技术演进与创新路径,深入探讨其对AI系统资源利用率、弹性、可维护性和未来生态的深远影响。

引言

在人工智能技术飞速发展的今天,大模型已成为推动产业智能化升级的核心引擎。然而,随着模型规模的指数级增长,算力资源的高效调度、模型的灵活部署与系统弹性的提升,成为制约AI大模型落地的关键瓶颈。大模型中间件应运而生,作为连接底层算力与上层应用的技术枢纽,正以前所未有的速度推动AI基础设施的演进。它不仅优化了资源利用率,提升了系统弹性,还通过平台化、服务化、容器化等技术趋势,为企业和开发者提供了灵活、高效的AI能力集成路径。本文将从算力调度、适配层、平台化、容器化、服务化、弹性化等多个维度,系统梳理大模型中间件的技术演进、创新实践与未来趋势,力求为读者呈现一幅立体、鲜活的技术全景。

一、算力调度与资源优化:AI基础设施的“神经中枢”

%20拷贝.jpg)

1.1 异构算力管理与资源池化

1.1.1 资源池化的技术逻辑

在大模型推理与训练过程中,算力资源的异构性日益突出。CPU、GPU、FPGA、ASIC等多种硬件平台各具优势,如何将这些资源高效整合,成为AI基础设施演进的核心课题。大模型中间件通过资源池化技术,将不同类型的算力资源虚拟化为统一的算力池,实现跨设备、跨区域的动态调度。资源池化不仅提升了资源利用率,还为模型的弹性部署和高并发处理提供了坚实基础。

1.1.2 动态调度的实现机制

资源池化的核心在于动态调度。中间件通过实时监控各类算力资源的负载、健康状态和地理分布,结合业务优先级、模型特性等多维度信息,智能分配最优算力资源。例如,在高并发场景下,系统可自动将推理任务分配至负载较低的GPU节点,或在资源紧张时切换至FPGA进行低延迟推理。动态调度机制极大提升了系统的吞吐能力和稳定性。

1.1.3 资源池化的实际成效

资源池化带来的直接效益体现在以下几个方面:

资源利用率提升:多品牌、多类型算力资源整合后,整体利用率显著提升,减少了资源闲置和浪费。

推理性能增强:动态调度机制保障了高并发、低延迟的业务需求,提升了用户体验。

运维复杂度降低:统一的资源池化管理简化了运维流程,降低了人力成本。

1.2 动态路由与智能调度

1.2.1 路由策略的智能化演进

大模型中间件的动态路由能力,是实现智能调度的关键。系统可根据输入内容、业务优先级、硬件负载等多维度信息,自动选择最优的模型和算力资源。智能路由不仅提升了推理效率,还实现了资源分配的精细化与高效化。

1.2.2 多模型协同与分阶段调度

在实际应用中,往往需要多模型协同工作。中间件支持分阶段调度,即在不同业务流程阶段调用不同模型,实现资源的最优分配。例如,初筛阶段采用轻量模型,精细判断阶段调用大模型,既保障了效率,又兼顾了精度。

1.2.3 智能调度的技术路径

智能调度的实现依赖于以下技术路径:

实时监控与反馈:系统持续监控各节点负载、响应时间等指标,动态调整路由策略。

优先级队列管理:根据业务紧急程度、用户等级等设定多级优先队列,保障核心业务优先处理。

自适应学习机制:通过历史数据分析与机器学习,优化调度策略,实现持续自我进化。

1.3 模型压缩与性能优化

1.3.1 轻量化技术的应用

随着大模型参数量的激增,模型压缩与轻量化成为提升部署效率的关键。中间件集成了混合精度量化、结构化剪枝等技术,将模型体积压缩至原模型的1/8,同时保持性能稳定。推理延迟可降至23ms,极大提升了响应速度。

1.3.2 性能优化的多维路径

算子融合与内存优化:通过算子融合、内存复用等手段,减少数据搬运和冗余计算。

异步执行与流水线并行:支持异步任务调度和流水线并行处理,提升系统吞吐能力。

硬件加速适配:针对不同硬件平台,自动选择最优的推理引擎和加速库,充分释放底层算力潜力。

二、大模型适配层与平台化发展:AI能力的“统一接口”

2.1 多框架与多模型兼容

2.1.1 标准化适配层的价值

大模型生态的多样性,要求中间件具备强大的兼容能力。通过构建标准化适配层,中间件屏蔽了底层硬件与模型框架(如TensorFlow、PyTorch、ONNX等)的差异,实现了统一接入与管理。这一机制极大降低了模型迁移与集成的门槛,提升了系统的灵活性。

2.1.2 多模型无缝对接

适配层不仅支持主流大模型的无缝对接,还能灵活集成自研模型和第三方模型。开发者无需关心底层细节,只需通过标准API即可完成模型的注册、部署与调用,极大提升了开发效率。

2.1.3 兼容性带来的生态扩展

模型迁移便捷:不同框架间的模型可快速迁移,降低了技术锁定风险。

多模态融合:支持文本、图像、语音等多模态模型的协同处理,拓展了AI应用的边界。

生态开放性:适配层的开放接口为第三方开发者和合作伙伴提供了创新空间,推动了生态繁荣。

2.2 平台化与流程自动化

2.2.1 统一平台的技术架构

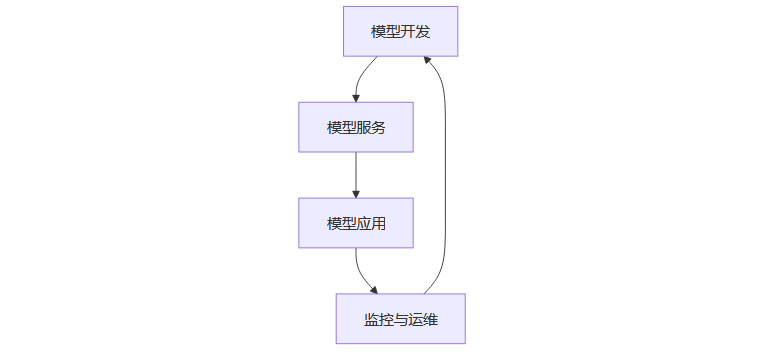

大模型平台化发展趋势日益明显。通过构建统一的大模型平台,实现了模型开发、部署、运维、监控的全流程自动化。平台通常采用分层架构,将模型开发、服务、应用三层有机整合,显著降低了开发门槛,提升了系统的可维护性与扩展性。

2.2.2 自动化流程的优势

开发自动化:支持自动化的数据预处理、模型训练、超参调优等流程,提升开发效率。

部署自动化:一键部署、自动扩缩容、灰度发布等能力,保障了系统的高可用性。

运维自动化:实时监控、自动告警、智能诊断等功能,降低了运维难度。

2.2.3 平台化的未来演进

未来,平台化将进一步向多模态融合、跨域协同、智能体自治等方向演进,成为AI能力集成与创新的核心载体。

2.3 多模态融合与开源生态

2.3.1 多模态融合的技术趋势

随着AI应用场景的丰富,单一模态已难以满足复杂业务需求。中间件平台正加速向多模态融合演进,支持文本、图像、语音等多种数据类型的协同处理。多模态融合不仅提升了模型的泛化能力,还拓展了AI的应用边界。

2.3.2 开源协作与生态共建

开源协作成为平台发展的重要方向。通过开放接口、共享数据集(如LAION-5B等),中间件平台吸引了大量开发者和研究者参与,推动了跨模态模型创新与生态繁荣。开放的技术生态为AI产业注入了持续创新的活力。

三、容器化、服务化与弹性化:AI系统的“柔性骨架”

%20拷贝.jpg)

3.1 容器化部署与云原生架构

3.1.1 容器化的技术优势

容器化技术(如Docker、Kubernetes)已成为大模型部署的主流方式。通过容器镜像打包模型及其依赖,实现环境一致性和快速交付。容器化部署支持多副本弹性扩缩容、故障自愈、灰度发布等能力,极大提升了系统的可维护性和弹性。

3.1.2 云原生架构的演进

Kubernetes等容器编排系统支持GPU资源的细粒度调度和多模型版本的并行部署,适应高并发、异构集群的复杂场景。云原生架构为AI系统提供了高度灵活的基础设施,支持按需扩展和弹性伸缩。

3.1.3 容器化部署的实际成效

环境一致性:开发、测试、生产环境高度一致,减少了“环境不一致”带来的问题。

快速交付:模型及依赖一键打包,极大缩短了上线周期。

弹性扩缩容:根据业务流量自动调整副本数量,保障系统的高可用性。

3.2 服务化与微服务架构

3.2.1 服务化的技术路径

大模型中间件推动AI能力以API化、微服务化方式对外提供,便于业务系统灵活调用与集成。服务化架构支持模型热更新、A/B测试、灰度发布等功能,提升了系统的敏捷性与稳定性。

3.2.2 微服务架构的优势

解耦与复用:各AI能力以独立服务形式存在,便于解耦与复用。

弹性伸缩:各服务可独立扩缩容,提升了系统的弹性。

敏捷迭代:支持快速上线、回滚和版本管理,提升了开发与运维效率。

3.2.3 服务化带来的系统变革

服务化不仅提升了系统的灵活性,还为AI能力的快速集成与创新提供了坚实基础。业务系统可按需调用AI服务,实现“即插即用”的能力扩展。

3.3 弹性伸缩与自动扩缩容

3.3.1 弹性化的技术实现

弹性化是大模型推理服务应对负载波动和资源高效利用的关键。中间件通过Knative、Kubernetes HPA/VPA等机制,根据实时流量和GPU利用率动态调整副本数量,实现资源的最优分配。

3.3.2 冷启动优化与预热机制

为应对高并发场景下的服务稳定性和低延迟响应,中间件集成了冷启动优化与预热机制。系统可提前预热部分副本,缩短冷启动时间,保障业务的连续性。

3.3.3 自动扩缩容的实际成效

资源利用率提升:根据实际负载动态分配资源,避免资源浪费。

服务稳定性增强:高并发场景下自动扩容,保障服务的稳定性和低延迟。

运维压力降低:自动化扩缩容机制减少了人工干预,提升了运维效率。

3.4 容器化、服务化与弹性化的协同效应

3.4.1 技术协同的价值

容器化、服务化与弹性化三者并非孤立存在,而是在大模型中间件架构中形成了高度协同的技术体系。容器化为服务化提供了灵活的部署单元,服务化则将AI能力以标准化接口暴露,弹性化机制则确保了系统在负载波动时的自适应能力。这种协同效应,使得AI系统能够在复杂多变的业务环境下,始终保持高可用、高性能和高扩展性。

3.4.2 典型协同场景

多模型并行部署:通过容器化和服务化,支持多版本、多类型模型的并行部署与热切换,满足不同业务需求。

弹性资源调度:弹性化机制与容器编排系统深度集成,实现算力资源的动态分配与回收,提升整体资源利用率。

自动化运维:服务化架构结合自动扩缩容与健康检查,实现故障自愈与自动恢复,极大降低了运维复杂度。

3.4.3 协同效应的未来展望

随着AI基础设施的持续演进,容器化、服务化与弹性化的协同将进一步深化,推动AI系统向更高层次的智能自治和自适应演进。未来,AI中间件有望实现全链路自动化、智能化运维和跨域资源协同,成为企业数字化转型的坚实基石。

四、未来趋势与挑战:AI中间件的“进化之路”

%20拷贝.jpg)

4.1 技术演进方向

4.1.1 智能化与自动化

大模型中间件正加速向智能化、自动化方向演进。未来的中间件将集成更强大的智能调度引擎,支持多模态融合、可持续学习和自适应优化。系统能够根据业务需求和资源状态,自动调整调度策略,实现真正的“无人值守”AI基础设施。

4.1.2 平台生态化

平台生态化是大模型中间件发展的必然趋势。通过开放标准化接口,推动开源协作与生态共建,中间件平台将吸引更多开发者、企业和研究机构参与,形成多模型、多场景的协同创新生态。生态化不仅提升了平台的创新能力,也加速了AI技术的产业化落地。

4.1.3 安全与合规

随着AI应用的普及,数据安全、模型安全和合规治理的重要性日益凸显。未来的大模型中间件将集成更完善的安全机制,包括数据加密、访问控制、模型安全评估和合规审计等,保障企业数据主权与业务安全,助力AI健康可持续发展。

4.2 主要挑战

4.2.1 算力资源分散与数据孤岛

尽管资源池化和动态调度技术不断进步,算力资源分散和数据孤岛问题依然存在。多云、多集群环境下,算力资源的统一管理和数据的高效流通仍需进一步突破。未来需要更智能的资源编排和数据治理机制,打破资源与数据的壁垒。

4.2.2 模型更新与推理延迟

大模型的快速迭代和频繁更新,对中间件的兼容性和推理延迟提出了更高要求。如何在保障系统稳定性的同时,实现模型的无缝热更新和低延迟推理,是中间件需要持续攻克的技术难题。

4.2.3 技术投入与效益平衡

企业在推进大模型中间件建设过程中,需平衡技术投入与实际效益。过度追求模型能力,可能导致资源浪费和系统复杂度提升。未来,企业应更加关注调度效率、资源利用率和业务价值的协同提升,避免陷入“模型能力竞赛”而忽视“调度效率竞赛”。

结论

大模型中间件作为AI基础设施的核心枢纽,正以前所未有的速度推动大模型的高效部署与智能调度。通过算力调度优化、适配层构建、平台化发展,以及容器化、服务化、弹性化等技术创新,中间件极大提升了AI系统的资源利用率、弹性和可维护性。它不仅为企业实现降本增效和数字化转型提供了坚实技术支撑,也为AI技术的产业化落地和生态繁荣注入了强大动力。

展望未来,随着智能化、平台化和安全合规能力的持续提升,大模型中间件将在更多行业和场景中深入落地,成为推动AI从实验室走向产业实践的核心引擎。企业和开发者应紧跟技术演进步伐,积极拥抱中间件带来的创新机遇,共同开创AI智能基础设施的新纪元。

📢💻 【省心锐评】

“中间件的本质是资源效率与工程效能的平衡器。技术竞赛的下半场,胜负手不在单点突破,而在全局调度。”

.png)

评论