【摘要】语音合成技术正经历一场深刻变革。微软VIBEVOICE凭借其单次生成90分钟多人对话的惊人能力,以及创新的双分词器与扩散生成架构,重新定义了AI语音的边界。这项技术在实现3200倍超高压缩率的同时,保证了业界领先的音质与自然度,为内容创作、教育及人机交互等领域开启了全新可能。

引言

长久以来,语音合成(Text-to-Speech, TTS)技术留给大众的印象,似乎总与单调、机械的电子音联系在一起。尽管技术不断进步,但要生成一段听起来既自然流畅又富有情感的长篇对话,尤其是包含多个角色的互动,始终是横亘在行业面前的一道难题。传统的TTS系统在处理短句时已相当成熟,可一旦面对长达数十分钟的剧本,便会暴露出音色漂移、情感断裂、节奏不自然等诸多问题。

现在,局面彻底改变了。微软研究院最新发布的VIBEVOICE项目,如同一声惊雷,宣告了语音合成技术正式迈入“大模型时代”。它不再是那个只能逐字逐句“朗读”的工具,而是一位能够驾驭长达90分钟、支持多达四人复杂对话的“AI播音员”。

这项技术的出现,不仅仅是时长和角色数量的简单叠加。它的背后,是一套全新的架构设计与技术理念的胜利。VIBEVOICE巧妙地将大型语言模型的上下文理解能力与扩散模型的生成能力相结合,实现了在超高压缩率下生成高保真、情感丰富且交互自然的语音流。这不仅解决了传统技术的诸多痛点,更为播客、有声书、在线教育等内容创作领域带来了颠覆性的想象空间。

接下来,我们将深入剖析VIBEVOICE的技术内核,看它究竟是如何打破桎梏,将AI语音的真实感与表现力推向一个全新高度的。

一、🎼 技术核心与创新突破

%20拷贝.jpg)

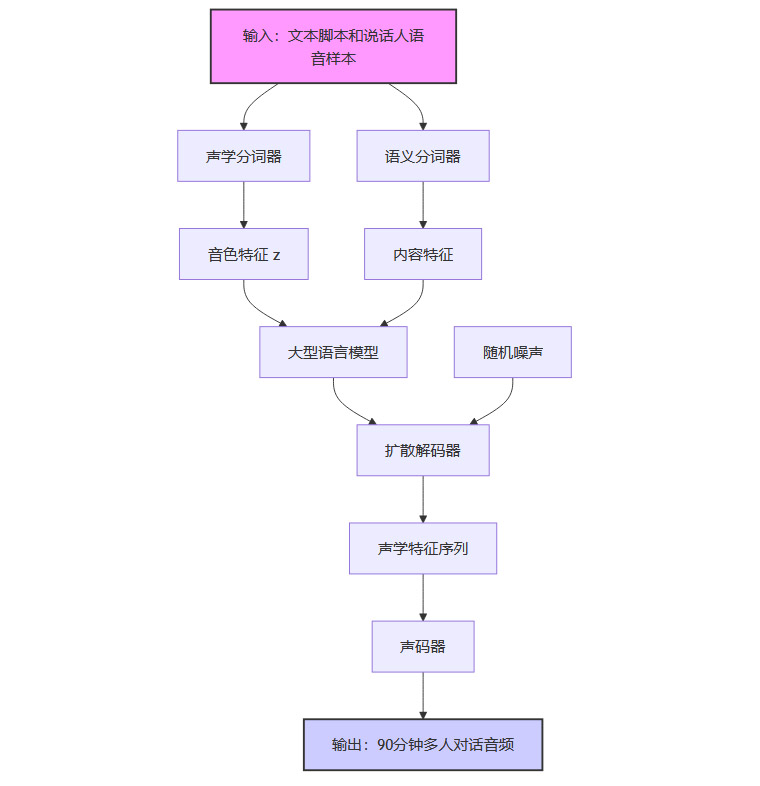

VIBEVOICE的强大能力,源于其在底层架构上的数项关键创新。它并非对现有技术的修补,而是一次彻底的重构。整个系统可以看作一个高效协同的语音生成流水线,其核心在于双分词器架构、扩散生成机制以及强大的长序列建模能力。

1.1 超越极限的时长与多角色支持

VIBEVOICE最直观的突破,在于其惊人的生成长度和多角色支持能力。

90分钟连续生成

这在以往是不可想象的。传统TTS系统受限于模型上下文窗口和计算能力的瓶颈,通常在处理超过30分钟的音频时就会出现质量显著下降的问题,更不用说连续生成一个半小时。VIBEVOICE通过高达64K token的上下文长度,成功实现了对超长文本和音频序列的连续建模,确保了在整个90分钟的生成过程中,语音的连贯性、音色的稳定性和情感的自然过渡。最多四位说话人同台

支持多说话人本身不新奇,但要让四位角色的对话听起来像真人一样自然互动,则极为困难。VIBEVOICE通过精巧的输入格式设计,为每个说话人分配了独立的音色特征。在生成过程中,角色切换平滑流畅,毫无生硬感。更重要的是,模型能够捕捉到对话中的细微之处,比如自然的呼吸声、恰到好处的停顿,甚至是轻微的唇齿音,这些细节共同构成了高度拟真的听感。

这项能力的实现,直接将AI语音的应用场景从短消息播报、导航提示等,拓展到了播客、有声剧、多人教学课程等长内容领域。

1.2 架构的革新乐章:双分词器与扩散生成

VIBEVOICE的架构设计,可以比作一个精密的“拼图工坊”。它巧妙地将语音信号分解、理解、再重构,每一步都体现了设计的巧思。

1.2.1 双分词器协同架构:声学与语义的精准剥离

VIBEVOICE首创了声学(Acoustic)与语义(Semantic)双分词器(Dual Tokenizers)协同工作的架构。这种设计思路的核心,是将语音中“怎么说”(音色、韵律、情感)和“说什么”(内容、含义)这两个维度进行解耦,分别处理,再由大模型统一调度。

声学分词器(Acoustic Tokenizer)

这个组件的目标是用最少的信息量来表达最丰富的语音特征。它基于一种名为σ-VAE的变分自编码器结构。研究团队对其进行了深度优化,成功将24kHz采样率的原始音频,压缩到了**每秒仅7.5个令牌(7.5Hz)**的超低频率。这意味着什么?一个惊人的3200倍压缩率。

相比之下,业界流行的Encodec模型,其压缩效率大约是VIBEVOICE的1/80。这种极致的压缩,极大地降低了后续大语言模型处理序列的计算负担,是实现90分钟超长语音生成的物理基础。它就像一位顶级的速记员,能用最简洁的符号记录下演讲者所有的语气神态。

语义分词器(Semantic Tokenizer)

如果说声学分词器关注的是“声音的外壳”,那么语义分词器则专注于“内容的内核”。它的训练方式非常巧妙,通过一个自动语音识别(ASR)的代理任务来学习。简单说,就是让模型去听一段语音,然后预测出对应的文字。训练完成后,只保留其编码部分。这样一来,这个分词器就学会了从语音波形中提取纯粹的语义信息,有效解决了传统TTS中常见的音色与语义不匹配的难题(比如用悲伤的语气说一件开心的事)。

1.2.2 扩散解码器(Diffusion Head):从噪声到天籁的艺术

当大语言模型理解了文本内容和角色分配后,如何将这些理解转化为真实的音频?答案是扩散解码器。

VIBEVOICE采用了一个轻量级的扩散模型(仅4层结构,约1.23亿参数)作为音频的最终生成器。它的工作原理极具艺术感:

起点是随机噪声,就像一块未经雕琢的璞玉。

大语言模型(如Qwen2.5-1.5B/7B)会输出一系列隐藏状态,这些状态包含了对每一帧音频应该如何生成的详细“指令”。

扩散解码器以这些“指令”为条件,通过10轮迭代式的去噪过程,逐步将随机噪声雕琢成清晰、高保真的声学特征。

这个过程既高效又精准,确保了最终生成的音频不仅音质卓越,而且完全忠实于大模型的意图,充满了丰富的细节和表现力。

下面是VIBEVOICE工作流程的简化示意图:

1.3 长序列建模的艺术:驾驭复杂对话流

要实现长达90分钟的对话,不仅需要高效的压缩,更需要模型具备强大的长序列建模能力。VIBEVOICE通过将上下文长度扩展至64K token,为处理复杂对话流奠定了基础。

其输入格式的设计也颇具匠心,采用一种**“角色标识-语音特征-文本脚本”交错拼接**的方式。这种格式让模型能够清晰地理解每个角色的音色是什么,以及他们分别要说什么话。在生成过程中,模型可以无缝地在不同角色之间切换,保持每个角色音色的高度一致性,使得整个对话听起来自然流畅,毫无割裂感。

二、📊 性能表现与行业坐标

一项技术是否具有革命性,最终要靠数据和实际听感来检验。VIBEVOICE在多项主观和客观评测中,都展现出了对现有主流系统的全面超越。

2.1 主观评测:人耳的最终裁决

研究团队邀请了24位专业评估员,对VIBEVOICE与包括谷歌Gemini 2.5 Pro在内的其他顶尖TTS系统生成的长对话音频进行盲听测试。评估维度包括真实感(Realism)、丰富度(Richness)和整体偏好(Overall Preference)。

结果显示,VIBEVOICE-7B版本在所有维度上都取得了最高分,全面领先于所有竞争对手。

这些分数直观地说明,在专业听众的耳朵里,VIBEVOICE生成的语音最接近真人录音,情感和细节也最为丰富。

2.2 客观指标:数据不会说谎

除了主观听感,客观技术指标同样印证了VIBEVOICE的卓越性能。

内容准确性(词错误率, WER)

使用强大的Whisper-large-v3模型对生成的语音进行识别,VIBEVOICE的词错误率极低。1.5B版本甚至低至1.11%,7B版本为1.29%。这说明模型不仅“说得好听”,而且“说得准确”,内容保真度非常高。说话人相似度(Speaker Similarity)

这项指标衡量生成的语音与原始说话人音色的相似程度。VIBEVOICE在中文测试中获得了高达0.744的分数,证明其能够高度还原并保持特定角色的声音特征。音质指标

在PESQ、STOI、UTMOS等行业公认的音质评估标准上,VIBEVOICE的声学编码器重建的音频质量均达到业界领先水平,几乎与原始录音无异。

2.3 优秀的泛化与可扩展性

一个优秀的模型架构,不仅要在特定任务上表现出色,还应具备良好的泛化和可扩展能力。

VIBEVOICE虽然主要为长对话设计,但在传统的短语音合成任务上同样表现优异。更重要的是,从1.5B参数规模扩展到7B的过程中,模型的各项性能指标都获得了持续且显著的提升。这清晰地展示了“暴力美学”的有效性,即随着模型规模的增大,其能力边界也在不断拓宽,显示出巨大的未来潜力。

三、🚀 应用前景:赋能内容创作与千行百业

%20拷贝.jpg)

VIBEVOICE的诞生,为众多行业带来了变革性的机遇。它的价值远不止于一个技术演示,而是能够切实赋能实际应用的强大工具。

播客与有声内容制作

这是最直接的应用场景。内容创作者不再需要昂贵的录音设备和复杂的后期剪辑。只需提供文本脚本和少量语音样本,就能一键生成高质量、多角色、长达90分钟的播客或有声书。这将极大降低内容创作的门槛和成本,催生UGC(用户生成内容)音频市场的繁荣。教育与企业培训

在教育领域,可以自动生成多角色参与的教学情境对话,例如语言学习中的场景模拟、历史剧本的生动演绎等,提升学习的互动性和沉浸感。企业培训同样可以利用它制作更具吸引力的培训材料。虚拟助手与客户服务

未来的智能客服或虚拟助手,将不再是单调的一问一答。VIBEVOICE可以使其具备与用户进行长时间、多轮、多角色自然对话的能力,极大地提升人机交互的体验,让AI助手更像一个真实的“人”。无障碍与辅助技术

对于视障人士等群体,VIBEVOICE能够将海量的文字信息转化为自然、悦耳的多人有声读物,为他们提供更丰富、更生动的获取信息的方式。娱乐与游戏

在游戏和元宇宙中,可以为成千上万的NPC(非玩家角色)生成独一无二且富有表现力的语音,构建一个更加真实和沉浸的虚拟世界。

四、⚖️ 局限性与风险警示

任何强大的技术都是一把双刃剑。微软在发布VIBEVOICE的同时,也坦诚地指出了其当前的局限性,并对潜在的滥用风险提出了明确警示。

当前的技术局限

语言支持有限 目前模型主要针对英语和中文进行了优化。在处理其他语言时,可能会输出不准确甚至不恰当的内容。

无法处理复杂音频环境 VIBEVOICE专注于生成纯净的人声对话。它不支持多人同时说话的重叠语音,也无法主动生成背景音乐、环境噪声等复杂的音效。

商业应用需谨慎 微软明确表示,目前VIBEVOICE主要面向研究和开发社区,不建议直接用于生产环境,商业化落地前需要进行更充分的测试和优化。

伦理与合规风险

高质量的语音合成技术,也带来了“深度伪造”(Deepfake)的风险。为此,微软明确禁止将VIBEVOICE用于以下目的:声音冒充与欺诈

传播虚假信息

绕过生物识别身份验证

官方强调,使用者必须遵守法律法规,并对AI生成的内容进行明确标识,以防范潜在的滥用风险。这种负责任的态度,为整个行业树立了良好的榜样。

五、🔭 未来展望

%20拷贝.jpg)

VIBEVOICE已经为我们展示了语音合成的壮丽前景,但探索的脚步远未停止。未来的发展方向清晰而令人期待。

多语言与多角色扩展

随着训练数据的丰富,未来版本有望支持更多语种,并挑战更多角色(超过4人)的复杂对话场景。情感与氛围的精细控制

未来的模型或许能让用户更精细地控制角色的情感表达,甚至可以根据文本内容自动插入合适的背景音乐(BGM)或环境音效,创造更完整的听觉体验。实时合成与低延迟交互

降低生成延迟,实现高效的实时TTS,将为直播、实时翻译、游戏内对话等场景提供强大的技术基础。攻克复杂对话建模

对重叠语音、打断、抢话等更真实的对话现象进行建模,是未来研究的重要方向,这将使AI语音无限接近于真实的人类交流。

总结

VIBEVOICE的发布,无疑是AI语音合成技术发展史上的一个里程碑。它标志着该领域正式从“能听”的阶段,迈入了“好听”且“耐听”的全新阶段。

其创新的双分词器+扩散生成架构,在实现超高压缩率与顶级音质的平衡上取得了巨大成功。而90分钟超长时长和多角色支持,则彻底打破了传统TTS的应用天花板,为内容创作、人机交互等领域带来了变革性的机遇。

尽管当前技术仍存在语言支持、复杂环境建模等方面的局限,并且伴随着必须严肃对待的伦理风险,但VIBEVOICE所指明的技术路径和展现出的巨大潜力,已经足够令人振奋。微软选择将其开源,更将极大地推动整个AI语音技术生态的创新与规范发展。

一个可以预见的未来是,AI生成的声音将不再是冰冷的机器语言,而是能够传递情感、讲述故事、陪伴你我的温暖存在。语音合成的“大模型时刻”,已经到来。

如需体验和了解更多,可访问微软官方项目页面(aka.ms/VibeVoice)、GitHub仓库及相关技术报告。

📢💻 【省心锐评】

VIBEVOICE不是简单的技术迭代,而是语音生成范式的跃迁。它用工程的极致,解决了艺术的难题,让AI语音从“可用”真正走向了“好用”和“爱用”。

.png)

评论