【摘要】AI Agent的成功远不止于其搭载的大模型。真正的壁垒在于水面之下,那占据90%的系统工程,包括规划、记忆、工具调用、可观测性及安全机制。这些看不见的底层能力,共同构成了Agent可靠落地的基石。

引言

AI Agent(智能体)的热潮正席卷整个科技领域。我们惊叹于它自主执行任务的能力,仿佛看到了未来工作方式的雏形。但是,当我们将目光从那些炫酷的演示上移开,深入探究其背后时,会发现一个普遍的误解,许多人将Agent的成功简单归功于其背后强大的大语言模型。

这其实是一种只见树木,不见森林的看法。

如果用经典的“冰山模型”来比喻,用户能直接感知到的“聪明对话”和“自动化功能”,仅仅是浮在水面上的10%冰山一角。而决定这艘巨轮能否稳定航行的,是那隐藏在水面之下,占据了99%体积的庞大冰体——一套完整且复杂的系统工程。

这篇文章的目的,就是带你潜入水下,揭开那决定AI Agent成败的90%隐性工程的神秘面纱。我们将从其进化阶段谈起,剖析它与人类行为模式的根本差异,并系统性地拆解其成功的技术栈。这不仅关乎技术,更关乎我们如何构建真正可靠、安全且高效的智能体系统。

一、AGI进化之路 🗺️ 我们身处何方?

%20拷贝.jpg)

在深入Agent的技术细节之前,我们有必要先明确其在人工智能发展宏图中的位置。OpenAI的CEO山姆·奥特曼(Sam Altman)曾为通往通用人工智能(AGI)的道路描绘了一幅清晰的五阶段进化图。这条路就像一场升级打怪,每一阶段都代表着AI能力的质变。

那么,我们现在走到了哪一步?

下表清晰地展示了这五个阶段的定义与特征。

奥特曼早期的这些洞察,在当时还带有几分科幻色彩。但今天,他的预言正加速成为现实。我们无疑正处在激动人心的L3 Agent阶段。在这个阶段,AI不再仅仅是一个被动的问答机器,它开始主动地观察世界、调用工具、采取行动,以达成我们设定的目标。

二、行为模式的鸿沟 🧠 AI与人的本质区别

要构建一个能“像人一样执行任务”的Agent,首先必须理解它和人类在行为模式上的根本差异。这些差异直接决定了Agent系统设计的核心挑战与技术选型。

2.1 交互方式

人类是天生的“视觉动物”,我们的交互高度依赖图形用户界面(GUI)。我们点击按钮、拖动窗口、浏览网页。因此,为人类设计的产品,前端界面的优劣至关重要。

Agent则完全不同。它的世界由API、数据流和文本指令构成。它可以在后端直接与各种系统和服务进行交互,无需一个精美的前端。这种差异意味着,为Agent设计“界面”,本质上是在设计稳定、清晰、高效的API和数据协议。

2.2 处理模式

人类的大脑在处理任务时,很难同时“做事情”和“学东西”。这两者涉及到大脑的不同区域,我们通常需要专注。

但是,Agent可以通过强化学习(Reinforcement Learning)等机制,在执行任务的同时进行学习和优化。它完成一个操作后,系统可以立即给予反馈。这个反馈就像是游戏里的得分,告诉它“做得好”或者“做错了”。基于这些反馈,Agent会不断调整自己的策略,下一次遇到类似任务时就会表现得更好。

所以,为Agent设计产品时,一套有效的奖励机制是其持续进化的关键。比如,一个为Agent设计的浏览器,需要在它每次正确提取到信息时都给予一个正向反馈(+1分),这在为人类设计的浏览器中是不可想象的。

2.3 任务逻辑

人的工作模式很像计算机科学中的“贪婪算法”(Greedy Algorithm)。我们倾向于关注眼前最有利的局部最优解,一步步完成任务。上一个任务的结束,就是下一个任务的开始,这是一种典型的单线程、串行处理模式。

而AI Agent的模式则更接近“动态规划”(Dynamic Programming)。它能够在一个时间点上,并行处理多个任务节点,评估多种可能性,并从中选择通往全局最优解的路径。这种多线程、并行处理模式赋予了Agent极高的效率。

不过,这也带来了一个巨大的工程挑战。当Agent在一个节点上同时执行100个任务时,这些任务的进度各不相同,有的快,有的慢,有的甚至可能需要人工介入。如何高效地保持、切换和同步这些任务的状态,就成了一个必须解决的难题。一个强大的状态管理机制,是Agent能够稳定处理并发任务的前提。

2.4 责任边界

这是最核心也最容易被忽视的区别。人可以为自己的行为负责。你写的代码出了问题,你自己承担后果。

但如果一个AI Agent出了问题,谁来负责?

想象一下,如果AI生成的代码在你的电脑上运行后,删除了所有文件,这个责任该由谁来承担?是AI的开发者,还是使用者?这是一个复杂的法律和伦理问题。

为了解决这个难题,AI Agent在执行任务时,必须被置于一个“安全围栏”(Sandbox,沙盒)之中。这个沙盒就像一个虚拟的保护罩,将AI所有操作的影响都严格限制在一个安全的、可控的范围内。它确保了即使AI出现错误或被恶意利用,也不会对外部系统造成灾难性的破坏。

这个安全围栏并非一刀切地限制Agent的能力,而是一个动态的、基于策略的风险控制系统。它需要智能地判断哪些任务和信息可以安全地交由Agent处理,而哪些必须经过人工审核或直接禁止。

为了更直观地理解这些差异,我们可以用下表进行总结。

三、冰山之下 🧊 决定成败的90%系统工程

%20拷贝.jpg)

现在,让我们正式潜入水下,探索支撑AI Agent这座冰山的庞大技术体系。

如果把AI Agent比作一辆高性能汽车,那么我们熟知的大模型(如GPT-4、Claude 3)就是那台强劲的发动机。但是,只有发动机是无法造出一辆好车的。你还需要方向盘、底盘、变速箱、刹车、电控系统等等。这些部件协同工作,才构成了一个完整、可靠的系统。

AI Agent也是如此。它的成功,依赖于一个分层、协同的技术栈。

3.1 规划 (Planning) - Agent的“大脑管家”

没有规划能力的AI,就像一个没做复习提纲的学生,回答问题可能东拉西扯,思维跳跃。而一个具备强大规划能力的AI,则像一个靠谱的项目经理,懂目标、会拆解、能反思、会改进。

规划能力是Agent智能的核心体现,它通常包含以下四个关键环节。

3.1.1 目标拆解 (Subgoal Decomposition)

这是规划的第一步,也是最基础的一步。当Agent接收到一个宏大而模糊的任务时,比如“策划一场产品发布会”,它必须能将这个大目标拆解成一系列具体的、可执行的小任务。

确定发布会主题和目标受众

寻找并预订合适的场地

设计并制作演讲PPT

撰写并发布宣传文案

邀请媒体和嘉宾

……

这个过程就像是为项目创建一个To-Do List。目标拆解能力,是Agent处理复杂问题的关键所在。

3.1.2 思维链 (Chain of Thought, CoT)

在分配和执行这些小任务之前,一个聪明的Agent会先在“脑子”里把整个流程预演一遍。这个内部的“头脑风暴”过程,就是AI领域的“思维链”。

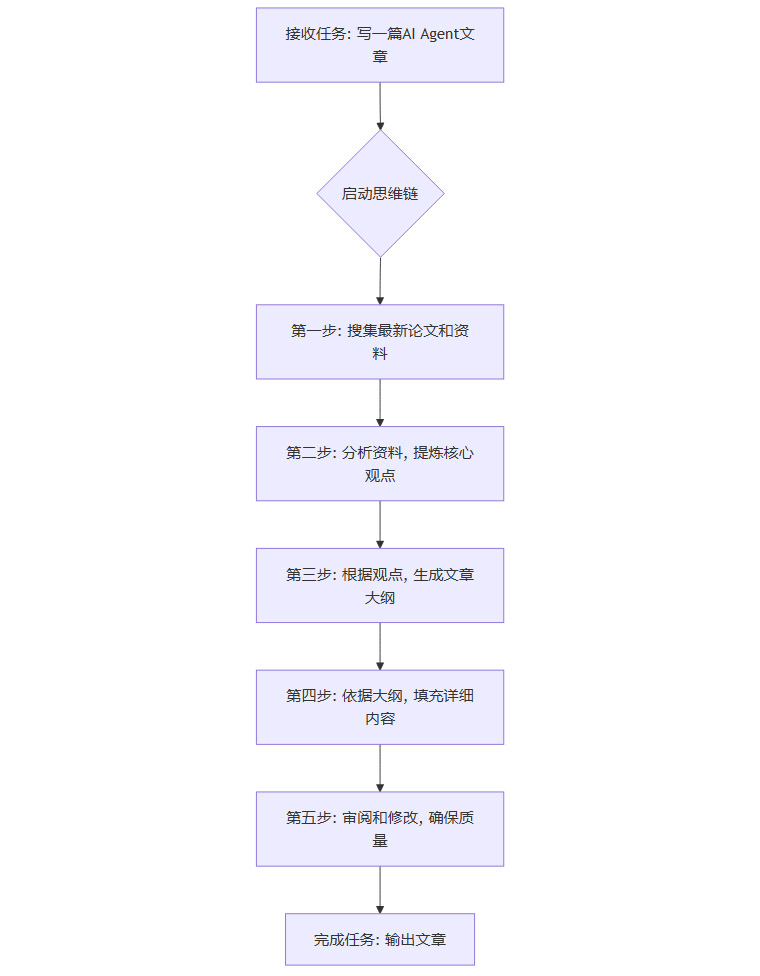

比如,当接到“写一篇关于AI Agent的文章”这个任务时,它的思维链可能是这样的。

正是因为有了这个“内在独白”,Agent才能将一个模糊的任务,转化为一个清晰、可执行的计划。更重要的是,当某个环节失败时(比如搜集资料失败),思维链能帮助Agent准确定位问题所在,并尝试自我修正(比如更换搜索引擎或关键词)。思维链是Agent拥有强大任务管理和自我纠错能力的核心。

3.1.3 反思 (Reflection)

任务完成的一个阶段后,Agent需要具备回顾和检查自己工作成果的能力。这就像我们写完代码后会进行Code Review,写完文章后会通读一遍。

代码检查

有没有语法错误?

输入输出逻辑是否符合预期?

有没有潜在的性能瓶颈?

文案检查

有没有错别字或语病?

逻辑是否连贯?

表达是否清晰?

反思能力让Agent从一个简单的执行者,变成了一个有质量意识的交付者。

3.1.4 自我批评 (Self-Critics)

这是比反思更高阶的能力。它要求Agent不仅能发现错误,还能主动给自己“挑毛病”,寻找改进空间。

AI写完一篇营销文案后,它可能会自我提问。

这个标题够吸引人吗?有没有更具冲击力的说法?

文中的案例是否具有说服力?

有没有逻辑重复的地方可以精简?

然后,它会基于这些“批评”对文案进行润色和迭代。自我批评,让AI从“只会输出”进化到了“会自我迭代”,这是其能力持续提升的关键。

3.2 记忆 (Memory) - Agent的“上下文感知器”

如果说规划是Agent的思维能力,那么记忆就是它感知和理解世界的基础。没有记忆,每一次交互都是一次冷启动,Agent永远无法真正“认识”你。

Agent的记忆系统通常分为两种。

3.2.1 短期记忆 (Short-term Memory)

这主要对应大模型的上下文窗口(Context Windows)。它就像人的工作记忆,只能记住最近一段时间内的对话内容。

你说,“我叫小宋。”

接着问,“我刚刚说我叫什么?”

AI能回答,“小宋。”

上下文窗口的大小直接决定了Agent能处理的瞬时信息量。不同模型之间差异巨大。

但是,短期记忆的容量终究是有限的。一旦对话内容超出了窗口上限,最早的信息就会被遗忘,就像我们聊天聊久了会忘记开头说了什么一样。

3.2.2 长期记忆 (Long-term Memory)

为了让Agent拥有持久的记忆,我们需要一个外部的“记忆宫殿”。这通常通过RAG(检索增强生成)技术结合知识库来实现。

举个例子,你可以上传一份公司的产品手册,让AI Agent学习并“记住”。一周后,当你问它,“我们的产品支持哪些功能?” Agent不会依赖有限的上下文窗口,而是会去它的长期知识库里检索相关信息,然后生成精准的回答。

这个过程背后,是**向量数据库(Vector Database)**在发挥关键作用。像Chroma、Pinecone这样的数据库,能将海量信息转化为向量形式存储,并实现毫秒级的相似度检索。无论是企业私有知识库问答,还是记住你的个人偏好(比如你喜欢的写作风格),都离不开长期记忆系统的支持。

总结一下,短期记忆负责即时对话的流畅性,长期记忆负责知识的沉淀和个性化的延续。两者结合,才构成了一个完整的记忆体系,让AI更像一个会思考、能记忆的智慧伙伴。

3.3 工具调用 (Tools) - Agent的“手和脚”

一个只有大脑和记忆的Agent,终究只是一个“思想上的巨人,行动上的矮子”。要让它能真正地与物理世界和数字世界交互,就必须为它装上“手和脚”——也就是工具调用能力。

没有工具的AI,只能纸上谈兵。有了工具的AI,才能动手解决实际问题。

AI Agent的“工具箱”里通常包含以下几类工具。

搜索引擎

作用 突破大模型知识截止日期的限制,获取实时信息。

示例 调用Google、必应等API查询今天的天气或最新的新闻。

数据分析工具

作用 执行精确的计算、数据处理和可视化。

示例 调用Pandas、Excel API分析一份销售报表并生成图表。

代码执行器

作用 运行代码片段,完成编程任务或与本地系统交互。

示例 在一个安全的沙盒环境中执行Python代码来处理文件。

知识库

作用 从企业内部或特定领域的数据库中精准检索信息。

示例 查询公司内部的向量数据库,获取产品技术文档。

第三方应用API

作用 连接和操作外部服务,将Agent的能力无限扩展。

示例 调用日历API安排会议、调用邮件API发送邮件、调用支付系统完成交易。

工具调用是连接Agent的智能核心与现实世界的桥梁。没有它,Agent的价值将大打折扣。

3.4 可观测性 (Observability) - Agent的“体检系统”

与传统软件不同,AI Agent的运行过程充满了不确定性。

模型的回答可能偏离主题。

工具调用的顺序可能出错。

多个Agent协作时可能出现“踢皮球”的现象。

Token消耗或API调用成本可能在一夜之间飙升。

如果没有一套有效的可观测性系统,当Agent出错时,你就像在黑夜里寻找一只黑猫,根本不知道问题出在哪里、时间花在哪里、钱花在哪里。

可观测性让Agent不再是一个“黑箱”,而是一个可以随时“体检”、随时定位问题的透明系统。它主要包含三个维度。

在AI领域,已经涌现出许多优秀的可观测性平台,如LangSmith、Arize、LangFuse等开源或商业化方案,它们为开发者提供了调试、监控和优化Agent的强大武器。可观测性是AI Agent从Demo走向生产环境的必经之路。

3.5 认证与安全 (Authentication & Security) - Agent的“门禁卡”

在AI Agent的技术栈里,认证与安全是非常基础但至关重要的一层。没有认证的Agent,就像一个没有门禁的办公大楼,任何人都可以随意进出,既不安全,也不可控。

认证系统的必要性体现在以下几个方面。

保护用户身份 确保只有授权的员工才能使用企业内部的Agent。

保护数据安全 Agent往往需要接触隐私数据(如聊天记录、公司资料)。没有认证,极易造成数据泄露。

控制权限范围 不同角色的用户拥有不同的功能权限。例如,普通员工只能查询自己的考勤,而管理员才能导出全部报表。

审计与追踪 记录下谁在什么时间访问了Agent、做了哪些操作,方便日后追溯问题。

常见的认证方式包括传统的账号密码、更安全的API Key、企业级应用中广泛使用的OAuth 2.0,以及对安全性要求极高的多因素认证(MFA)和基于角色的访问控制(RBAC)。认证与安全体系,保证了Agent在与世界交互时的每一部操作都是可控、可追溯的。

3.6 协议与模型路由 (Protocols & Model Routing) - Agent的“调度中枢”

随着Agent生态的发展,两个新的工程挑战浮出水面,如何让不同的Agent协同工作?以及如何最高效地使用底层的大模型?

3.6.1 Agent协议 (Agent Protocols)

当系统中存在多个Agent时,它们之间需要一套标准的“语言”和“行为准则”来进行通信和协作。Agent协议就是为了解决这个问题而生的。它定义了Agent之间如何发现彼此、如何交换信息、如何委托任务。Google提出的A2A(Agent-to-Agent)开放协议就是这个方向的积极探索。Agent协议是实现复杂的多智能体系统(Multi-Agent System)的基础。

3.6.2 模型路由 (Model Routing)

很多时候,一个Agent系统会同时接入多个不同的大模型。模型路由就像一个智能的“派单员”,它会根据当前任务的类型和复杂度,决定调用哪个模型最合适。

这个机制的优势非常明显。

降低成本 简单的任务(如格式转换、简单计算)就用便宜的小模型;复杂的任务(如深度推理、长文写作)再调用昂贵的旗舰模型(如GPT-4、Claude 3.5)。

提升效果 不同的模型有各自擅长的领域。路由器可以“对症下药”,比如总结长文时调用Claude,写代码时调用DeepSeek Coder,处理多模态任务时调用Gemini。

增强系统弹性 当某个模型服务不可用时,路由器可以自动切换到备用模型,保证服务的连续性。

模型路由是实现Agent系统降本增效和高可用的关键技术。

3.7 底层基础设施 - Agent的“坚实地基”

在整个技术栈的最底层,是支撑一切运作的硬件与基座。这就像一座城市的道路、水电和网络。没有它们,再宏伟的建筑也只是空中楼阁。

基础大模型 (Foundation Models) 它们是Agent的“中央大脑”,提供了最核心的智能。但如前所述,一个只有大脑的Agent是无用的。它需要手脚(工具)、记忆(数据库)和完善的系统工程来发挥价值。这就是为什么我们说,大模型虽然是核心,但它只占Agent成功的10%。

数据处理 (ETL) ETL(提取、转换、加载)系统像一个“原料工厂”,源源不断地为Agent提供高质量、结构化的“数字养料”,这是Agent知识库更新和学习的基础。

数据库 (Database) 尤其是向量数据库,它们是Agent长期记忆的物理载体,是Agent能够“博闻强识”的保障。

计算资源 (CPU/GPU) 它们是Agent所有智能活动的物质基础。强大的算力,就像是为Agent注入了生命力。

四、未来展望 🚀 多智能体协作与行业垂直化

%20%E6%8B%B7%E8%B4%9D.jpg)

展望未来,AI Agent的发展将呈现两大趋势。

第一,多智能体协作(Multi-Agent System)将成为主流。未来的复杂任务,不太可能由一个“万能”的Agent完成,而更可能由一个各司其职的Agent集群(Agent Swarms)协同完成。比如,一个“项目经理Agent”负责任务拆解和协调,它会将设计任务分配给“设计师Agent”,将开发任务分配给“程序员Agent”,将测试任务分配给“测试工程师Agent”。这种分工协作的模式,将极大地提升系统的鲁棒性和解决复杂问题的能力。

第二,行业垂直化和工程化能力将决定商业价值。通用的Agent平台会继续存在,但真正的商业爆发点将出现在与特定行业深度结合的垂直Agent上。无论是金融、医疗、法律还是教育,谁能将Agent的底层工程能力与深刻的行业知识(Domain Knowledge)相结合,谁就能构建起真正的竞争壁垒。

最终,AI Agent将像今天的水、电、煤气一样,成为数字社会不可或缺的基础设施,无声地渗透到我们工作和生活的方方面面。

结语

回到我们最初的问题,为什么说AI Agent 90%的成功都藏在水面之下?

因为用户看到的,永远是那个最终呈现出的、流畅智能的结果。但为了实现这个结果,背后需要一个由规划、记忆、工具、可观测性、安全、路由等一系列复杂系统共同组成的“超级工程”。

大模型赋予了Agent思考的能力,但真正让它从一个“聪明的聊天机器人”蜕变为一个“可靠的超级员工”的,是这些看不见的、深植于水下的系统工程能力。

这不再是单纯的模型之战,而是系统集成、工程实践和行业理解的综合较量。那些能够将“冰山”水下部分建得又深又稳的公司,才会在未来的Agent时代中,成为真正的赢家。

📢💻 【省心锐评】

Agent的浪潮中,模型是那朵最耀眼的浪花,但决定海洋深度与广度的,永远是下面那股由系统工程、数据和安全构成的强大暗流。别只盯着浪花,要敬畏暗流。

.png)

评论