【摘要】密歇根大学最新研究揭示了如何通过G-ACT技术为AI装上“方向盘”,实现对AI编程语言选择的精确控制。这一突破不仅提升了AI在科学计算等领域的实用性,也为未来可控、可解释的AI智能体奠定了基础。

引言

人工智能的进步正以前所未有的速度改变着我们的世界,尤其是在自动化编程和科学计算领域。AI助手已经能够生成复杂的代码、辅助科研、甚至参与工程设计,但它们的“自主性”也带来了新的挑战——比如,AI往往会根据自身的“偏好”选择编程语言,而不是完全按照用户的需求行事。这种“性格”有时让人哭笑不得:你需要一辆F1赛车,AI却递给你一辆自行车。

密歇根大学的最新研究为这一难题带来了革命性的解决方案。研究团队通过深入分析AI神经网络的内部机制,开发出了一套名为G-ACT的智能控制系统,实现了对AI编程语言选择的精确调控。本文将带你深入了解这一技术突破的原理、实验过程、实际应用及其对AI未来发展的深远影响。

一、🧠 AI的语言偏好之谜:从“黑盒”到“性格”

%20拷贝.jpg)

1.1 AI写代码的“性格”是怎么来的?

AI编程助手的本质,是基于大规模神经网络模型(如Llama、Qwen等)在海量代码数据上的训练。它们像资深程序员一样,逐步形成了自己的“编程习惯”。但这些习惯并不总是与用户需求一致。比如,科学家需要高性能的C++代码,AI却更喜欢输出Python脚本。这种现象背后,隐藏着AI模型训练数据、规模、架构等多重因素的影响。

1.1.1 训练数据的“成长环境”

训练数据中Python代码占比高,AI自然更倾向于Python。

不同模型版本、参数规模,导致“性格”差异显著。

训练过程中的“调教”策略,也会影响AI的语言选择。

1.1.2 现实中的“偏好”表现

研究团队对主流AI模型进行了系统测试,发现:

小型模型(如Llama-3.2-3B)偏爱Java,Python选择率低。

大型模型(如Llama-3.3-70B)则更倾向于Python和Julia。

专业代码模型(如Qwen2.5-Coder-32B)虽然号称全能,但C++选择率极低。

这种差异就像同一家餐厅的两位大厨,一个擅长川菜,一个主攻粤菜。用户的需求如果与AI的“口味”不符,往往会陷入无奈。

1.2 AI“性格”带来的实际困扰

科学计算、工程仿真等领域,C++等高性能语言不可或缺。

AI助手却频繁输出Python,导致性能瓶颈、代码迁移成本高。

用户难以通过简单提示让AI“改掉习惯”,影响实际应用效率。

1.3 现有解决方案的局限

通过提示工程(Prompt Engineering)反复调整,效果有限且不稳定。

重新训练模型成本高昂,且难以针对每个用户需求定制。

缺乏对AI内部决策机制的可解释性,难以实现精确控制。

二、🔍 寻找AI大脑中的“开关”:神经元归因技术

2.1 神经元归因:AI“发动机”里的精密仪器

为了解决AI语言偏好难以控制的问题,研究团队采用了神经元归因(Neuron Attribution)技术。这一方法类似于用高精度仪器检测汽车发动机,找出哪个部件控制油门、方向盘。

2.1.1 神经元的“专业分工”

每个神经元在神经网络中负责不同的“任务”。

有的神经元对C++代码特征高度敏感,有的则专注于Python。

通过数学归因方法,可以量化每个神经元对特定语言的“兴奋度”。

2.1.2 关键神经元的发现

研究团队在不同模型的特定层,找到了对C++高度敏感的神经元。例如:

Llama-3.2-3B模型第27层的神经元6859,对C++有极强响应。

Qwen2.5-14B模型第31层也有类似的“C++侦探”。

2.2 实验验证:激活“开关”后的惊人变化

通过人为增强这些关键神经元的信号,AI模型的语言选择发生了戏剧性转变:

原本偏爱Java的模型,瞬间变身C++专家。

任务完成率、代码质量均有显著提升。

这种方法的直观效果令人振奋,但也暴露出一些局限性。

2.3 单点控制的局限

依赖单一神经元,控制效果容易受输入变化影响。

不同模型、不同任务下,关键神经元的位置和作用可能不同。

缺乏全局协调,难以应对复杂多变的实际需求。

三、🧭 从单点控制到智能导航:G-ACT系统的诞生

%20拷贝.jpg)

3.1 G-ACT:AI大脑的“智能导航员”

为克服单点控制的不足,研究团队开发了梯度精细化自适应激活导向框架(G-ACT)。这一系统不再依赖单一神经元,而是像经验丰富的乐队指挥,协调整个神经网络的多层次信号,实现对AI行为的全局导航。

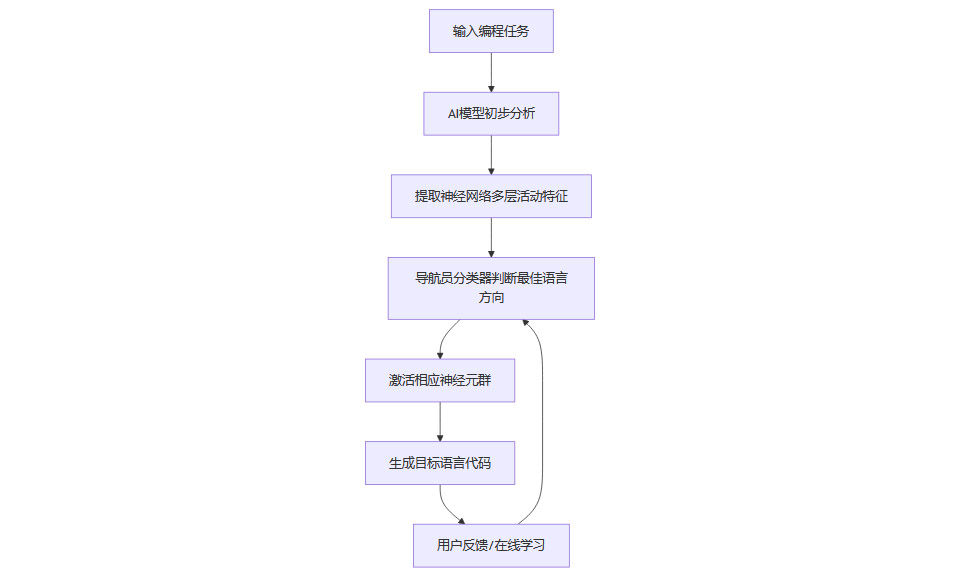

3.1.1 G-ACT的核心原理

收集AI在生成不同语言代码时的神经活动“路线样本”。

通过聚类算法,将复杂的神经活动模式归纳为几个主要“导航方向”。

在每一层神经网络中,训练小型“导航员”分类器,实时判断并引导AI选择最合适的编程语言。

3.1.2 G-ACT的创新点

多层次、分布式控制,提升了系统的精细度和稳定性。

导航员具备在线学习能力,能够根据实际使用情况持续优化。

控制组件轻量级,无需重新训练整个AI模型,易于集成和扩展。

3.2 G-ACT的工作流程

3.3 四大“导航方向”与多样化控制

G-ACT通过聚类分析,识别出四个主要的“编程偏好方向”,分别对应不同类型任务的最佳语言选择策略。这种多样化控制能力,使AI能够根据任务特性灵活切换语言风格,极大提升了实用性。

四、🚀 智能导航系统的优异表现:实验与评测

4.1 导航准确率与稳定性大幅提升

在Llama-3.2-3B等模型上的实验显示,G-ACT系统将平均导航准确率提升了15%,早期网络层的准确率从0%跃升至61.5%。这意味着AI在面对不同任务时,能够更早、更准确地做出语言选择。

4.1.1 多样化提问下的稳定性

研究团队设计了十种不同的提问模板,测试G-ACT的鲁棒性。

无论用户如何表达需求,G-ACT都能保持稳定的控制效果。

这种稳定性对于实际应用至关重要,避免了“提示工程”反复试错的困扰。

4.2 大模型上的适应性与效率

在更大规模的Llama-3.3-70B模型上,神经网络信号更加分散复杂,但G-ACT依然能够在关键层面实现有效控制。系统采用隐藏状态特征替代注意力头特征,进一步提升了控制效果。

4.2.1 性能与效率对比

G-ACT通过轻量级分类器,处理效率提升约30%。

这种效率提升对于大规模应用场景尤为重要。

4.3 代码生成质量的显著提升

在高斯-赛德尔迭代算法、计算流体动力学等复杂任务中,G-ACT控制下的AI不仅能够稳定选择C++,生成的代码也更加完整、规范,接近专业工程师水准。

4.3.1 代码质量评估要点

内存管理、收敛性检查、错误处理机制齐全。

多次运行结果一致,展现出高度可靠性。

复杂科学计算任务下,AI生成的代码结构合理、功能完备。

五、🔬 技术创新的深层意义:可控、可解释、可扩展的AI

%20拷贝.jpg)

5.1 非侵入式控制:AI“性格”随需而变

G-ACT的最大亮点在于其“非侵入性”设计。无需重新训练AI模型,只需加装轻量级控制组件,就能实现对AI行为的动态调节。这种方式类似于为汽车加装智能导航系统,不改变发动机结构,却极大提升了驾驶体验。

5.1.1 通用性与可扩展性

G-ACT可适配多种主流AI模型,具备良好通用性。

控制范围不仅限于编程语言选择,还可扩展到内容风格、专业领域偏好等多种行为调节。

5.2 可解释AI的重大进步

通过识别和操控神经网络中的特定组件,G-ACT让AI的决策过程变得透明可控。这对于构建可信赖的AI系统至关重要,尤其是在科学计算、工程设计等高精度领域。

5.2.1 可重现性保障

G-ACT能够嵌入持久的转换矩阵,确保同样输入下输出一致。

解决了传统AI输出随机性强、难以复现的痛点。

5.3 在线学习与自适应能力

G-ACT中的“导航员”并非一次性训练完成,而是能够在实际使用过程中持续学习和优化。这种设计让AI系统具备了高度适应性,能够随着用户需求和环境变化不断进化。

六、🌐 面向未来的AI智能体:可控性与可靠性的双重飞跃

6.1 AI智能体的可控性革命

随着AI智能体在自动化科研、工程仿真、智能制造等领域的广泛应用,如何实现对AI行为的精确控制成为行业关注的焦点。G-ACT的出现,为构建可控、可靠的AI智能体系统提供了坚实的技术基础。

6.1.1 关键应用场景

自动化科学实验:确保AI选择合适工具和方法,避免实验失败。

工程设计与仿真:根据任务需求自动切换编程语言和算法风格。

智能制造与机器人:实现对AI行为的实时调节,提升系统安全性和效率。

6.2 可重现性与行业标准

G-ACT的可重现性优势,使其在科学研究、工程应用等对结果一致性要求极高的领域具有独特价值。未来,G-ACT有望成为AI系统可控性和可重现性的行业标准。

七、⚙️ 技术挑战与局限性:现实与未来的平衡

%20拷贝.jpg)

7.1 计算开销与效率权衡

虽然G-ACT比传统方法更高效,但仍然增加了约40%的计算时间。这一“油耗”问题在大规模应用场景下需要进一步优化。

7.2 模型规模依赖性

在超大规模模型中,神经网络信号更加分散,G-ACT的控制效果会有所下降。研究团队通过调整特征提取方式,部分缓解了这一问题,但仍需持续探索更高效的控制策略。

7.3 通用性与扩展性挑战

目前G-ACT主要应用于编程语言选择,扩展到其他类型的行为控制还需进一步验证。不同任务、不同领域下的控制需求多样,如何实现更广泛的适应性,是未来研究的重要方向。

7.4 提示工程与人机协同

即使有了G-ACT,合理的提示设计依然重要。AI的表现不仅取决于内部控制系统,也受用户输入方式影响。未来的人机协同,将是AI可控性提升的又一关键。

八、🧪 实验设计的巧思与科学严谨性

8.1 多样化任务集与公平性保障

研究团队构建了包含84个科学编程挑战的测试集,涵盖基础算法到复杂科学计算。每个任务都不明确指定编程语言,考察AI的自主选择能力。

8.2 严格的统计方法

每个模型-任务组合进行25次重复测试,确保结果可靠。

100次与25次测试结果差异小于1%,验证了测试充分性。

8.3 多模板提问,避免偏差

每个测试问题设计十种不同提问模板,确保评测公平。

这种设计避免了因特定提示方式导致的结果偏差。

8.4 代码功能正确性验证

不仅评估语言选择,还验证生成代码的功能完整性和规范性。

G-ACT控制下的代码在功能实现上表现更优,体现了系统的实际价值。

结论

密歇根大学的G-ACT技术为AI编程助手装上了“方向盘”,实现了对AI行为的精确、可解释、可扩展控制。这一突破不仅解决了AI编程语言选择的顽疾,更为未来可控、可靠的AI智能体系统奠定了坚实基础。随着G-ACT等技术的不断完善,AI将变得更加个性化、专业化,真正成为人类高效、可信赖的智能伙伴。未来,我们有望看到AI在科学研究、工程设计、智能制造等领域发挥更大作用,而用户也将拥有调节AI“性格”的遥控器,开启一个更可控、更可靠的AI时代。

📢💻 【省心锐评】

“G-ACT是AI可控性的一大飞跃!未来AI助手将更像贴心伙伴,按需定制输出,值得行业深思与期待!”

.png)

评论