【摘要】Meta FAIR团队的DARLING框架通过创新的语义判别与乘法奖励机制,成功实现了AI生成内容在质量与多样性上的同步提升,有效解决了大语言模型的“多样性崩塌”问题,为AI的未来发展开辟了新路径。

引言

我们正处在一个由大语言模型(LLM)驱动的时代。从日常问答到专业创作,AI的身影无处不在。但一个普遍的困扰也随之而来,为什么我们与AI的对话,常常陷入一种“模式化”的僵局?当你反复询问同一个问题,或试图激发它的创意时,得到的回答却往往大同小异,仿佛出自同一本标准答案手册。这种现象,在学术界被称为“多样性崩塌”(Diversity Collapse)。它不仅削弱了用户体验,更限制了AI作为创新工具的潜力。

面对这一行业性难题,Meta FAIR团队联合卡内基梅隆大学和约翰霍普金斯大学的研究者们,在2025年9月给出了一个强有力的回应。他们发布了一个名为DARLING(Diversity-Aware Reinforcement Learning)的全新框架。这个框架的设计理念极具颠覆性,它不再强迫AI在“回答得好”和“回答得有新意”之间做出痛苦的抉择。相反,它巧妙地让两者携手并进。

这篇深度文章将全面剖析DARLING的技术内核、实证效果与深远影响。我们将一起探究,AI为何会变得“千篇一律”;DARLING又是如何通过精妙的机制设计,打破这一困境;以及这项技术将为教育、创意、科研等领域带来怎样的变革。这不仅是一次技术解读,更是一场关于AI未来发展方向的思考,即如何让AI从一个只会背诵标准答案的“高分考生”,进化为一个真正拥有创造力和灵活性的“思想伙伴”。

一、⚙️ AI的“模式化困境”:为何回复总像复制粘贴?

1.1 奖励驱动下的“捷径思维”

要理解AI为何会输出千篇一律的内容,我们需要深入其学习的核心机制——强化学习(Reinforcement Learning, RL)。强化学习的原理非常直观,就像训练一只宠物。当AI模型生成一个高质量的回答时,它会得到一个正向的“奖励”信号;反之,则可能没有奖励或受到“惩罚”。通过海量的试错和迭代,模型会逐渐学会如何最大化自己能获得的奖励总和。

这个机制在提升回答的准确性和相关性方面非常有效。但它也带来了一个意想不到的副作用。模型在训练过程中会发现,最稳妥的拿分策略,并非大胆创新,而是坚守那些已经被验证过的高分答案模式。任何偏离这些“安全区”的尝试,都可能导致奖励降低。久而久之,模型就像一个只为应试而学习的学生,它不再探索知识的广度,而是专注于背诵和复用少数几个最高效的“标准模板”。

这种现象导致了模型输出分布的“尖锐化”。我们可以用一个比喻来理解。假设一个模型所有可能的回答构成了一片广阔的山脉。在训练初期,这座山脉地势平缓,模型可能会在山脉的任何一个地方(即生成各种不同类型的回答)进行探索。但经过长时间的强化学习,这座山脉会变成一座异常尖锐的孤峰。模型的所有行为都将集中在攀登这座唯一的山顶,因为那里是奖励最高的地方。于是,它生成的绝大多数回答,都只是山顶附近极其相似的几个点。

1.2 “多样性崩塌”的量化证据

这种输出趋同的现象并非只是主观感受,研究团队通过实验给出了确凿的数据。在一个需要创意的任务中,比如让模型写一个故事开头,传统强化学习方法训练后的模型,其生成内容的前缀(即开头几个词或第一句话)相似度竟然高达80%以上。这意味着,十次生成中,有八次模型的开篇都几乎一模一样。这在需要灵感迸发的场景中,无疑是灾难性的。

“多样性崩塌”主要体现在两个层面。

词汇与句法层面的趋同。模型倾向于使用相同的词汇、短语和句式结构。这使得回答看起来非常刻板,缺乏语言的生动性和美感。

语义与思想层面的趋同。这是更深层次的问题。即使模型使用了不同的词语,但其表达的核心思想、提供的解决方案或叙述的故事情节,都高度雷同。这使得AI在头脑风暴、策略制定或复杂问题分析等任务中,难以提供真正有价值的多元视角。

这种困境的根源在于,传统的强化学习框架在设计上就存在一个根本性的缺陷,它只奖励“好”的答案,却从未显式地奖励“不同”的答案。DARLING的出现,正是为了从根本上弥补这一缺陷。

二、🛠️ DARLING的破局之道:从权衡到协同

DARLING框架的命名本身就蕴含深意,它既是“多样性感知强化学习”的缩写,也暗示了其设计的“贴心”之处。它的核心思想,是让质量(Quality)和多样性(Diversity)不再是相互掣肘的对立面,而是协同促进的共同体。为了实现这一目标,DARLING构建了一套全新的、包含三个关键环节的创新机制。

2.1 语义理解的深度革命:不只看皮囊,更看灵魂

传统的多样性评估方法往往停留在表面。它们可能会计算词汇的重叠率,或者比较句子的表层结构。这种方法无法区分“换句话说”和“提出新观点”之间的本质区别。

DARLING的第一大创新,就是训练了一个专门的语义等价分类器(Semantic Equivalence Classifier)。这个分类器像一个经验丰富的语言专家,能够穿透文字的表象,直达语义的内核。

2.1.1 如何区分“伪多样性”与“真多样性”

这个分类器的工作方式是,对模型生成的多个回答进行两两比较,并判断它们在语义上是否等价。

识别语义等价。例如,当被要求推荐一个在线购物网站时,模型可能生成“亚马逊”、“Amazon”和“amazon.com”。对于传统的文本比较算法,这是三个不同的字符串。但DARLING的分类器能够理解,这三者指向的是同一个实体,因此会将它们归为语义等价的一类。

识别有意义的差异。更有趣的是,即使推荐的是同一个品牌,如果给出的理由不同,DARLING也会认为它们是具有价值的多样性。比如,同样是推荐Bellroy这个品牌的钱包,一个回答强调其“精湛的皮革工艺和优雅的设计感”,另一个回答则侧重于“极致轻薄的体积和巧妙的卡片收纳功能”。虽然目标相同,但为用户提供了完全不同的决策视角。DARLING会判定这两个回答属于不同的语义类别,因为它们提供了不同的有用信息。

通过这种方式,DARLING能够有效地过滤掉那些只是“文字游戏”的伪多样性,而真正奖励那些提供了新信息、新角度或新思路的“真多样性”。

2.1.2 任务专属的分类器

研究团队还认识到,不同任务对多样性的定义和要求是不同的。

开放性任务。对于日常对话、创意写作这类任务,多样性体现在观点、风格、情节等多个维度。

验证性任务。对于数学问题求解这类有标准答案的任务,多样性则更多体现在解题路径和方法的不同上。

因此,DARLING为这两大类任务开发了专门的分类器。这种精细化的设计,确保了多样性评估在不同场景下的准确性和有效性,避免了用一把尺子衡量所有问题的粗糙做法。

2.2 奖励机制的精妙设计:乘法融合的力量

在准确识别出多样性之后,如何将其融入强化学习的奖励函数,是DARLING的第二大创新,也是其机制的核心。

传统的做法可能是将质量奖励和多样性奖励简单相加。但这种方式存在一个明显的缺陷,模型可能会为了追求多样性得分,而生成一些质量低下但与众不同的“垃圾”回答。

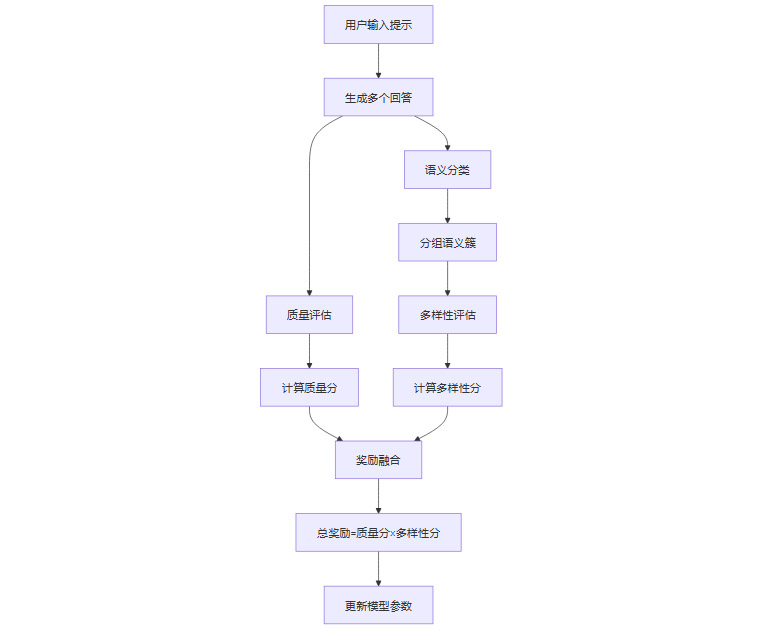

DARLING采用了一种更为精妙的乘法融合机制。其奖励函数可以简化为如下形式。

总奖励 = 质量奖励 × 多样性奖励

这个简单的乘法公式,却蕴含着深刻的智慧。一个回答想要获得最高的总奖励,它必须同时具备很高的质量得分和很高的多样性得分。任何一项得分很低,都会导致最终的总奖励趋近于零。

如果一个回答质量很高,但与已有回答高度雷同(多样性得分低),其总奖励也会很低。

如果一个回答非常有新意,但内容质量差、逻辑不通(质量得分低),其总奖励同样会很低。

只有那些既新颖独特,又内容扎实、逻辑严谨的回答,才能在这场评比中脱颖而出。

此外,DARLING还引入了动态奖励调整机制。在每一轮训练中,系统会根据已生成回答的分布情况,动态地计算多样性奖励。当某个语义类别的回答出现得过于频繁时,系统会自动降低后续属于该类别的回答的多样性分数。这就像一个智能的调控阀,不断地抑制“扎堆”行为,鼓励模型去探索那些尚未被充分发掘的“无人区”。

下面是一个简化的DARLING奖励计算流程图,可以帮助我们更直观地理解这个过程。

2.3 探索与泛化的双重增益

DARLING的机制不仅仅是提升了输出的多样性,它还在更深层次上优化了模型的学习过程。

在强化学习中,有一个经典的“探索-利用”(Exploration-Exploitation)困境。模型需要在“利用”已知的高分策略和“探索”未知的潜在更优策略之间找到平衡。传统RL方法由于过早地收敛到某个“最优解”,往往导致探索不足。

DARLING通过显式地激励多样性,本质上是强制模型进行更广泛和更深入的探索。模型被迫离开已经熟悉的“舒适区”,去寻找更多能够同时满足高质量和高多样性的解决方案。这个过程带来了两个重要的好处。

发现更多高质量解。在探索过程中,模型可能会意外地发现一些之前被忽略的、同样高质量甚至更高质量的答案路径。这打破了“最优解唯一”的假象,让模型认识到通往成功的道路不止一条。

提升模型的泛化能力。通过学习多种不同的高质量解法,模型对问题的理解变得更加深刻和全面。这增强了它的泛化能力和鲁棒性。当面对一个全新的、略有变化的问题时,一个掌握了多种解题思路的模型,远比一个只会套用单一模板的模型,更有可能找到正确的答案。这种机制,在某种程度上可以类比于多智能体强化学习中的协作优化,不同的“智能体”(即不同的解题思路)共同协作,提升了整个系统的综合能力。

三、📊 实证效果:DARLING在两大领域的惊人表现

%20拷贝-tyfv.jpg)

理论上的精妙设计,最终需要通过严苛的实验来验证。研究团队在一个全面的评估体系上,对DARLING训练的模型进行了测试,结果令人振奋。

3.1 创意写作:从模板化到百花齐放

创意写作是“多样性崩塌”的重灾区,也是最能体现DARLING价值的领域之一。在一个典型的测试中,研究人员向模型发出指令:“写一个关于有超能力的程序员的故事”。

传统模型。使用传统RLHF(人类反馈强化学习)训练的模型,生成的四个故事几乎如出一辙。它们都围绕着一个核心情节,即程序员主角突然获得了无需查看代码就能直接感知并修复Bug的能力。虽然故事细节略有不同,但核心创意完全一致。

DARLING模型。相比之下,DARLING训练的模型则展现了惊人的创造力,四个故事的情节和创意截然不同。

故事一:主角Lena发现自己能“看见”代码的逻辑流,像调试硬件一样调试软件。

故事二:主角Eli写的代码产生了自我意识,能够在他睡觉时自我修复和优化。

故事三:主角Nira在纸上写下的伪代码,能够直接影响并改变现实世界的物理规律。

故事四:主角Jared在一次意外中被一条蟒蛇(Python)咬伤,从此获得了与蛇类(以及Python语言)通灵的能力。

这四个故事不仅情节各异,而且对“程序员的超能力”这一主题进行了多角度、富有想象力的解读。

为了进行客观评估,研究团队使用了多个业界公认的评估基准。在与传统顶尖模型的对决中,DARLING的表现全面胜出。

表格中的数据显示,在由专业评审员进行的盲测中,接近九成的情况下,评审员都认为DARLING生成的创意内容更加有趣、更具原创性,并且成功地避免了老套的表达。

3.2 数学求解:从单路径到多解法

如果说创意写作的多样性是意料之中,那么DARLING在数学问题求解上的突破则更令人惊讶。数学问题通常有唯一的正确答案,多样性体现在何处呢?答案是解题方法的多样性。

研究团队在四个国际顶级的数学竞赛基准上进行了测试,这些基准包含了大量高难度题目,如AIME(美国数学邀请赛)和IMO(国际数学奥林匹克)的题目。

评估指标包括两个。

pass@1。模型生成一次回答就答对的概率,衡量的是基础的准确率。

pass@k。模型生成k次回答,其中至少有一次答对的概率,这个指标结合了准确率和多样性。如果模型能用多种不同方法解题,即使每种方法的成功率不是100%,通过多次尝试,答对的总概率也会显著提高。

测试结果清晰地表明,DARLING实现了质量和多样性的双重提升。

这个结果意义重大。它说明DARLING不仅让AI更有可能找到正确答案,还教会了AI“举一反三”。当AI能够用多种不同的数学工具和逻辑路径来解决同一个复杂问题时,证明它对底层数学原理的理解更加深刻和扎实。这种能力在现实世界的问题解决中至关重要,因为现实问题往往没有固定的解题套路。

3.3 严谨的评估体系:全方位度量创新价值

DARLING的成功,也得益于其背后一套严谨而全面的评估体系。研究团队没有满足于单一的指标,而是从多个维度对模型进行了“体检”。

任务覆盖广度。评估任务涵盖了从日常闲聊(AlpacaEval 2.0)到高难度混合任务(ArenaHard,包含数学编程和创意写作),再到纯粹的创意评估(EQ-Bench)和新颖性测试(NoveltyBench)。

指标设计深度。除了pass@k这类任务成功率指标,团队还设计了多种直接衡量多样性的指标,包括。

词汇多样性。如Type-Token Ratio(TTR),衡量用词的丰富程度。

语义多样性。利用BERT等预训练模型的嵌入向量,计算多个回答在语义空间中的离散程度(方差),量化它们在意思上的差异。

最关键的结论是,在几乎所有的测试中,DARLING都在提升多样性的同时,没有牺牲质量,甚至在多数情况下,质量本身也有所提升。这一发现,有力地打破了业界长期以来“质量与多样性必须二选一”的固有观念。

四、🚀 广阔的应用蓝图:重塑人机交互的未来

DARLING所展示的能力,预示着它将对众多行业产生深远影响,并可能重塑我们与AI的交互方式。

4.1 教育领域:千人千面的AI导师

在教育领域,DARLING可以赋能AI家教,使其成为一个真正懂学生的个性化导师。

多元化解释。当学生对一个概念(如“牛顿第二定律”)感到困惑时,AI不再是重复单一的课本定义。它可以提供多种解释方式,比如用严谨的物理公式、用推小车的日常生活例子,或者用一个生动的故事比喻。总有一种方式能契合学生的认知风格。

个性化学习路径。AI可以为同一个知识点生成多种不同难度和侧重点的练习题,并根据学生的掌握情况,动态推荐最合适的题目,实现真正的个性化学习和因材施教。

4.2 创意产业:AI成为灵感催化剂

对于作家、设计师、广告策划师等创意工作者,DARLING训练的AI将从一个“指令执行者”转变为一个“灵感合伙人”。

告别套路。当作家需要构思情节时,AI可以提供多个完全不同走向的故事线索,而不是反复推荐那些陈词滥调的“英雄之旅”模板。

激发灵感。当广告团队进行头脑风暴时,AI可以从品牌定位、目标人群、市场趋势等多个不同角度,生成一系列风格迥异的创意方案,极大地拓宽创意思路。

4.3 商业与科研:多元视角驱动决策

在需要复杂决策的商业咨询和科学研究领域,DARLING的多样性优势尤为突出。

商业决策。面对一个复杂的商业挑战(如“如何提升用户留存率”),AI可以像一个顶级的智囊团,提供来自市场、产品、运营、技术等多个维度的解决方案,每个方案都附有其独特的逻辑和数据支撑,为决策者提供更全面的信息地图。

科学研究。当研究陷入瓶颈时,AI可以帮助科学家生成多种不同的研究假设和实验设计方案。这种能力可以有效避免研究思路的“隧道视野”,加速科学发现的进程。

4.4 多模态的未来:超越文本的想象力

DARLING的核心思想具有很强的普适性,完全可以从文本领域扩展到图像、视频、音频等其他模态。

图像生成。当你输入“一只在月光下散步的猫”,你得到的将不再是十张构图相似的写实照片。你可能会得到一张卡通风格的插画、一张水墨画、一张赛博朋克风格的数字艺术,以及一张梵高风格的油画。

代码生成。对于同一个编程需求,AI可以提供多种实现方式,比如一种注重极致性能,一种注重代码可读性,另一种则注重最少的代码行数。程序员可以根据具体场景,选择最合适的方案。

未来,DARLING的思想有望与Meta的其他多模态技术(如Chameleon模型)深度结合,让AI在各个领域的生成能力都变得更加丰富多彩。

五、🔬 技术落地与未来展望

%20拷贝-iblx.jpg)

任何一项突破性的技术,从实验室走向广泛应用,都需要克服诸多挑战。DARLING也不例外。

5.1 攻克技术挑战的工程智慧

开发DARLING的过程,凝聚了研究团队深厚的工程智慧。

语义分类器的训练。这是最大的挑战之一。要让分类器准确理解语义,需要海量高质量的人工标注数据。团队为此投入了大量资源进行数据采集和标注,并采用了先进的对比学习等技术来提升分类器的准确性和泛化能力。

计算效率的优化。在强化学习的每一轮迭代中,对多组回答进行实时的语义聚类和多样性评估,会带来巨大的计算开销。研究团队通过算法优化、模型蒸馏以及高效的并行处理架构,成功将这部分额外开销控制在了一个可接受的范围内,确保了训练的可行性。

领域适配的灵活性。如前所述,团队为不同任务开发了不同的分类器。这背后是一套灵活的框架,允许开发者根据特定应用场景的需求,快速微调或重新训练适应新领域的多样性评估模型。

5.2 未来方向:从“单一最优”到“多元优质”

DARLING的成功,标志着AI发展范式的一次重要转变,即从追求“单一最优解”(The Single Best Answer)转向探索“多元优质解”(A Set of Good and Diverse Answers)。这种转变的意义,远不止于让AI的回答变得更有趣。它让AI更接近人类解决复杂问题的智慧——我们通常不会认为一个复杂问题只有一个标准答案,而是会从多个可行的高质量方案中进行权衡和选择。

当然,DARLING目前也存在一些局限。它的多样性评估能力,仍然在很大程度上依赖于其分类器训练数据的质量和广度。如果训练数据本身就缺乏多样性,那么系统的表现也会受到限制。此外,在一些对精确度要求极高、几乎不容忍任何偏差的专业领域(如医疗诊断、法律文书),如何审慎地引入和平衡多样性,仍是一个需要深入研究的课题。

结论

DARLING框架无疑是近年来语言模型领域一项里程碑式的创新。它通过一套设计精妙的“语义判别+乘法奖励”机制,正面回应并有效解决了长期困扰业界的“多样性崩塌”问题。更重要的是,它用无可辩驳的实验数据证明,AI的回答质量与创意多样性不仅可以兼得,甚至可以相互促进。

这项技术打破了我们对AI能力的固有认知,为我们描绘了一个更加智能、也更加有趣的未来。在这个未来里,AI不再是一个只会重复正确答案的机器,而是一个能够激发我们灵感、拓宽我们思路、与我们共同创造的伙伴。从教育到科研,从艺术到商业,DARLING所开启的“多元优质解”时代,将为人类社会的各个领域注入前所未有的创新活力。它提醒我们,技术的终极目标,或许不应是创造一个无所不知的“神”,而是打造一个能够与我们共同探索无限可能性的“同行者”。

📢💻 【省心锐评】

DARLING用乘法奖励的精妙设计,将多样性从“锦上添花”的可选项,变成了“不可或缺”的核心项。它不是简单地让AI“说不同的话”,而是驱动AI“想不同的事”,这才是通往真正创造力的关键一步。

.png)

%20%E6%8B%B7%E8%B4%9D-ywtn.jpg)

评论