【摘要】本文系统梳理了任务逆向生成与课程学习在GUI智能体中的应用,深度拆解MobileGUI-RL的自我探索与文本世界模型筛选机制,探讨提示词工程的进阶实践,展望智能体自适应与泛化能力的未来发展。

引言

在智能体技术飞速发展的今天,如何让AI在复杂多变的GUI环境中高效学习、泛化和自适应,成为业界与学界关注的焦点。传统的监督学习和静态任务设计,已难以满足智能体在实际应用中面对的多样化挑战。为此,任务逆向生成与课程学习应运而生,成为推动智能体能力跃迁的关键引擎。

MobileGUI-RL作为移动端GUI智能体领域的创新代表,通过自我探索、轨迹逆向工程和文本世界模型筛选,构建了高效的任务生成与课程学习体系。与此同时,提示词工程的进阶应用,极大优化了任务生成、筛选与智能体训练流程。本文将以MobileGUI-RL为核心案例,系统梳理任务逆向生成与课程学习的理论基础、技术实现与实际成效,深入探讨提示词工程在智能体自适应学习中的深度融合与未来趋势。

一、任务逆向生成与课程学习的理论基础

%20拷贝-phuz.jpg)

1.1 任务逆向生成:从结果到任务的反向推理

任务逆向生成,是指通过分析智能体在GUI环境中的探索轨迹,反向推导出能够覆盖多样场景和能力边界的自然语言任务指令。这一过程不仅丰富了训练任务的多样性,还能动态适配智能体当前的能力,实现“以学定教”的课程学习策略。

1.1.1 逆向生成的本质与价值

元提示设计:逆向生成本质上是一种“元提示”设计。通过AI的输出反推输入提示词,优化任务生成质量,为智能体提供多样化、高质量的训练数据。

能力边界探索:通过逆向生成,能够发现智能体尚未覆盖的能力边界,推动其不断突破自我限制。

动态适配:任务指令的生成与智能体能力动态适配,形成个性化的学习路径。

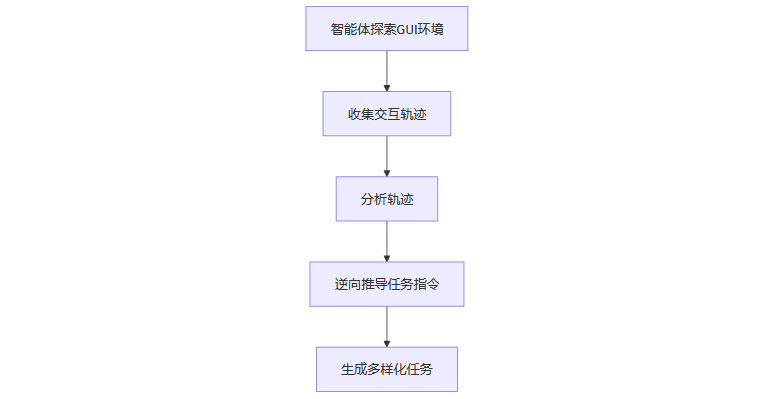

1.1.2 逆向生成的流程

1.2 课程学习:难度递进的智能体成长路径

课程学习强调任务难度的渐进式分配,让智能体从易到难逐步掌握复杂操作,提升泛化与长期学习能力。

1.2.1 课程学习的核心机制

任务难度分级:将任务按难度分级,智能体先学习基础操作,再逐步挑战更复杂的任务。

动态课程推送:根据智能体当前能力,动态调整任务难度,实现个性化课程推送。

多样性与挑战性兼顾:既保证任务的多样性,又确保每个任务对智能体具有适度挑战性。

1.2.2 课程学习的优势

提升泛化能力:通过多样化、递进式任务训练,智能体能够更好地适应新环境和新任务。

促进长期学习:课程学习为智能体提供了持续成长的动力和路径,避免陷入局部最优。

二、MobileGUI-RL的自我探索与任务生成机制

2.1 启发式随机探索:智能体的主动发现

MobileGUI-RL在移动端GUI环境中,采用启发式随机探索策略,智能体进行带偏好的随机游走,优先探索未被覆盖的界面元素,避免重复循环,最大化任务空间的覆盖度。

2.1.1 启发式探索的实现

界面元素优先级:智能体根据界面元素的覆盖情况,动态调整探索优先级。

避免重复:通过记录已访问元素,智能体避免在同一界面反复操作。

最大化覆盖:探索策略旨在最大化任务空间的多样性和覆盖度。

2.1.2 启发式探索的成效

任务多样性提升:智能体能够发现更多样化的任务场景,为后续任务生成提供丰富素材。

能力边界拓展:通过主动探索,智能体不断拓展自身能力边界。

2.2 轨迹逆向工程:从操作到任务的高效生成

基于探索得到的交互轨迹,MobileGUI-RL利用大模型(如GPT-4o)自动逆向生成自然语言任务指令。这一过程是提示词逆向工程的实际应用,通过分析已完成的操作序列,反推出能引导模型复现该行为的高质量提示词。

2.2.1 轨迹逆向工程的流程

收集交互轨迹:记录智能体在GUI环境中的每一步操作。

轨迹分析:对操作序列进行结构化分析,提取关键行为与目标。

任务指令生成:利用大模型,根据操作轨迹自动生成对应的自然语言任务指令。

多样性优化:通过“元提示”模板,要求AI根据操作轨迹推测任务指令,提升任务生成的多样性和质量。

2.2.2 轨迹逆向工程的优势

高效任务生成:自动化生成任务指令,极大提升任务设计效率。

质量与多样性兼顾:结合大模型的理解与生成能力,确保任务指令既准确又多样。

2.2.3 轨迹逆向工程的流程图

三、基于文本世界模型的任务筛选

%20拷贝-fbsf.jpg)

3.1 文本世界模型:任务筛选的智能守门员

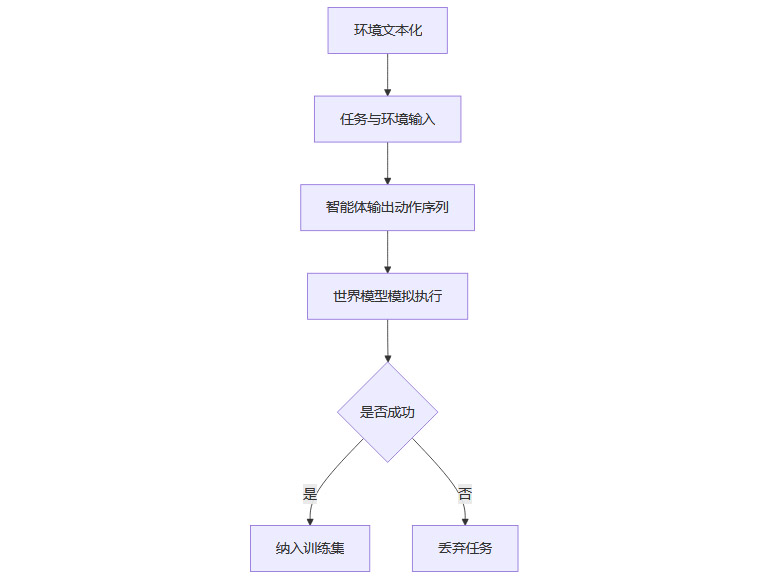

文本世界模型作为轻量级预筛选器,极大提升了任务筛选的有效性。其核心在于用大模型对主屏幕进行文本化描述,结构化为包含各UI元素属性的列表。

3.1.1 环境建模

文本化描述:将GUI界面转化为结构化文本,包含各UI元素的属性、位置、状态等信息。

环境抽象:通过文本世界模型,智能体能够在抽象层面理解和操作GUI环境。

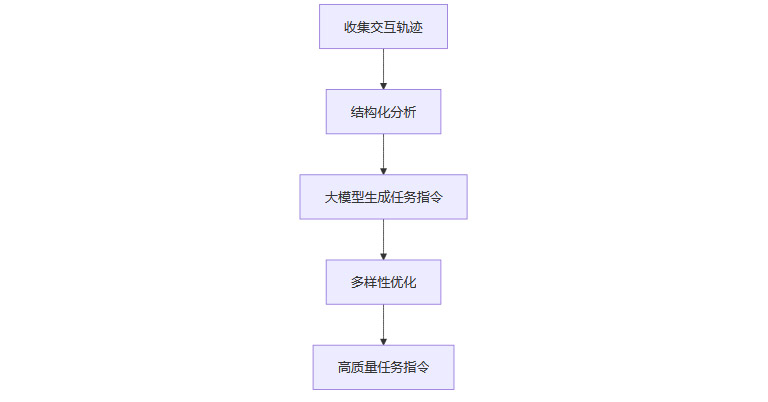

3.1.2 模拟执行

任务与环境输入:基础智能体接收任务指令和环境描述。

动作序列输出:智能体输出预期的动作序列。

世界模型模拟:文本世界模型模拟动作效果,生成新的状态描述,判断任务是否可行。

3.1.3 准入条件

步数限制:仅当模拟在步数限制内达到成功状态时,任务才被纳入训练集。

有效性筛选:避免无效或超出当前能力范围的任务,提升训练效率和数据质量。

3.1.4 文本世界模型的流程图

3.2 文本世界模型的多重价值

可行性预验证:在任务正式训练前,预先验证任务的可行性,避免资源浪费。

规划与反思能力增强:通过世界模型,智能体能够进行多步骤任务规划与反思,提升复杂任务的完成率。

子目标生成:世界模型可引导智能体生成子目标,分解复杂任务,提升多步骤任务规划能力。

四、课程学习与强化学习闭环

4.1 能力适配与难度递进的课程体系

MobileGUI-RL通过自我探索、轨迹逆向工程和文本世界模型筛选,自动构建了“能力适配—难度递进”的任务课程体系。

4.1.1 动态适配

能力评估:系统实时评估智能体当前能力水平。

任务难度调整:根据能力评估结果,动态调整任务难度,实现个性化课程推送。

4.1.2 多样性与挑战性兼顾

自我探索保障多样性:通过主动探索,智能体不断发现新任务,保证任务多样性。

文本世界模型筛选挑战性:筛选机制确保每个任务对智能体具有适度挑战性,避免过于简单或过于复杂的任务。

4.1.3 强化学习优化

MobGRPO算法:将轨迹级奖励均匀分配至每一步,结合复合奖励设计(效率奖励+提前终止惩罚),解决长周期任务的信用分配难题。

策略稳定性提升:强化学习优化算法提升了智能体的策略稳定性和任务完成质量。

4.1.4 数据质量优先

高质量小样本优于大规模低质样本:精选高质量、多样化任务是提升智能体能力的关键。实验证明,136个高质量样本即可超越传统监督微调,跨平台动作预测准确率提升15%。

4.2 课程学习的流程表

五、提示词工程与逆向生成的深度融合

%20拷贝-cnbk.jpg)

5.1 提示词逆向工程:智能体训练的高级利器

MobileGUI-RL的任务逆向生成机制,是提示词工程在智能体训练中的高级应用。通过分析交互轨迹,反推最能激发模型能力的任务指令,并不断迭代优化。这一过程与提示词工程中的“结果-反推-优化-再试验”流程高度一致。

5.1.1 逆向推导与优化

结果导向:以智能体的实际操作结果为导向,反推最优任务指令。

迭代优化:不断调整和优化提示词,提升任务生成的质量和多样性。

5.1.2 结构化与动态化提示词设计

结构化提示词:课程学习不仅体现在任务难度递进,还体现在提示词结构的逐步复杂化,引导模型在不同阶段学习不同层次的推理与操作能力。

动态置信度评估:通过协同探测框架和动态评分机制,提升任务完成率和步骤成功率,形成“感知→推理→行动”闭环。

5.1.3 奖励相关提示词设计

奖励函数结合:提示词工程可结合强化学习奖励函数,通过设计奖励相关提示词,激励智能体生成更高效的执行轨迹。

5.2 提示词工程的流程表

六、MobileGUI-RL的实际成效与案例分析

6.1 高质量样本驱动的能力跃迁

MobileGUI-RL通过136个高质量样本,成功超越传统微调方法,跨平台动作预测准确率提升15%。这一成果验证了高质量、小样本与课程学习结合的巨大潜力。

6.2 动态置信度与人工干预的创新实践

通过动态置信度评估和人工干预机制,复杂任务完成率从26%提升至88.2%,步骤成功率高达95.9%。这一机制为智能体的可控性和安全性提供了坚实保障。

6.3 世界模型引导的多步骤任务规划

世界模型不仅用于任务筛选,还能引导智能体生成子目标,分解复杂任务,显著提升多步骤任务的规划与执行能力。

七、未来展望:智能体自适应与泛化能力的进阶之路

%20拷贝-dmoq.jpg)

随着世界模型、课程学习和提示词工程的不断进化,GUI智能体将在以下几个方面实现更高水平的自适应与智能化:

多模态输入融合:结合视觉、文本、语音等多模态输入,提升智能体的环境理解与交互能力。

个性化课程推送:根据用户需求和智能体能力,动态推送个性化学习课程,实现真正的“以学定教”。

动态置信度评估:通过实时置信度评估与人工干预,提升智能体的可控性与安全性。

结构化与动态化提示词设计:推动提示词工程向更结构化、动态化方向发展,提升任务生成与智能体训练的智能化水平。

复杂任务处理能力提升:通过世界模型引导和课程学习,智能体将具备更强的复杂任务规划与执行能力,推动实际应用落地。

结论

任务逆向生成与课程学习,已成为推动GUI智能体能力跃迁的核心动力。MobileGUI-RL通过自我探索、轨迹逆向工程和文本世界模型筛选,构建了高效的任务生成与课程学习体系,极大提升了智能体的泛化能力和实际应用价值。提示词工程的深度融合,不仅优化了任务生成与筛选流程,还推动了智能体从“反应式”向“深思熟虑型推理者”转变。未来,随着相关技术的不断进步,GUI智能体将在多模态输入、个性化课程推送、动态置信度评估等方面实现更高水平的自适应与智能化,为复杂任务处理和实际应用落地提供坚实基础。

📢💻 【省心锐评】

任务逆向生成与课程学习,正让智能体变得更聪明、更可靠,未来可期。

.png)

评论