【摘要】面对大模型带来的新型安全挑战,传统防护手段已显不足。一套覆盖AI全生命周期的纵深安全体系变得至关重要。该体系以精细化权限管理为基石,融合大模型中间技术,将安全措施内嵌于数据处理、模型训练、应用推理的每一个环节。通过角色划分、权限矩阵、内容风控、合规治理与透明化技术,系统性地解决了数据泄露、模型投毒、隐私侵犯等核心风险,为构建安全、合规、透明的可信AI应用提供了坚实的实践路径。

引言

大模型技术正以前所未有的速度渗透到各行各业。它们强大的能力在带来巨大机遇的同时,也打开了新的风险敞口。数据泄露、模型投毒、提示词注入、隐私侵犯等问题,像幽灵一样盘旋在每一个AI应用的周围。

传统的网络安全防火墙和访问控制,在这些新型、复杂的威胁面前,显得有些力不从心。我们需要的不再是简单的“外挂式”补丁,而是一套全新的安全思维范式。这套范式必须深入AI的“骨髓”,从数据诞生的那一刻起,直到模型最终提供服务的每一秒,都进行全流程的保护。

因此,一个以大模型中间技术为支撑、以精细化权限管理为核心、以全链路纵深防御为目标的综合安全保障体系,应运而生。它不再是亡羊补牢,而是未雨绸缪。

本方案将详细拆解这一体系。它融合了基于角色的访问控制(RBAC)、最小权限原则、动态权限调整、行为审计、内容安全检测、合规治理,以及透明化与可解释性等多种手段。同时,它也借鉴了业界成熟的安全实践,力求为构建真正可信的AI应用提供一份详尽的行动指南。

一、🏰 权限之基:角色定义与精细化管理

%20拷贝-rstz.jpg)

安全体系的构建,始于对“人”和“权限”的严格管理。如果每个人都能接触到所有数据和模型,那么任何技术防护都将是空中楼阁。最小权限原则是这里的金科玉律,即只授予完成任务所必需的最小权限。

1.1 角色划分与职责

在典型的大模型开发流程中,我们可以清晰地划分出四个核心角色,每个角色都承担着不可或替代的职责。

数据清洗师

他们的工作是AI流水线的起点。他们面对的是最原始、最混杂的数据。其核心职责是对这些原始数据进行清洗、去重、格式化,并执行初步的脱敏处理,最终输出干净、合规、可用的数据集。他们是数据的“净化师”。数据标注师

他们是模型“认知”的塑造者。他们接收由数据清洗师处理过的干净数据,并为其打上高质量的标签。无论是分类、问答对还是情感倾向,这些标注数据将直接决定模型学习的质量。他们是数据的“启蒙者”。算法工程师

他们是模型的大脑设计师。他们负责模型的架构设计、算法开发与持续优化。他们会调用标注好的数据集来训练和微调模型,不断探索提升模型性能的更优路径。他们是模型的“架构师”。训练工程师

他们是模型训练过程的“管家”和“护卫”。他们负责管理和维护庞大的训练集群,执行算法工程师设计的训练任务,监控训练过程,评估模型性能,并负责模型上线前的最后安全测试与部署。他们确保整个训练过程高效、稳定且安全。

1.2 权限矩阵与管理机制

定义了角色,下一步就是为他们戴上“紧箍咒”——一套严格的权限矩阵。这个矩阵清晰地规定了每个角色能对哪些资产(数据、模型等)进行何种操作(读、写、执行)。

这个矩阵的设计背后,是几个关键的管理机制在支撑。

1.2.1 动态权限与生命周期管理

权限不是一成不变的。一个完善的系统应该支持权限的动态调整。例如,当一个项目启动时,相关人员被授予权限;当项目结束或人员调离时,权限应被立即、自动地撤销。这避免了因权限残留而导致的安全风险。

1.2.2 多因素认证(MFA)

对于所有涉及核心资产的敏感操作,例如修改模型核心参数、删除大规模数据集、部署模型到生产环境等,必须启用多因素认证(MFA)。这意味着除了密码,用户还需要提供第二重验证,如手机验证码、指纹或硬件密钥。这为关键操作增加了一道坚固的防线。

1.2.3 不可篡改的行为审计

“凡走过,必留下痕迹”。系统必须记录下所有角色的每一次操作,并生成不可篡改的审计日志。这些日志详细记录了“谁(Who)在什么时间(When)从哪里(Where)对什么(What)做了什么(How)”。这不仅能在发生安全事件时提供精准的溯源依据,其本身的存在也对潜在的违规行为构成了强大的威慑。

1.2.4 统一权限中间件

在复杂的系统中,权限管理不应分散在各个子系统中。我们需要一个统一的权限管理中间件。这个中间件作为整个系统的“权限中枢”,集中负责所有权限的分配、校验、审计和回收。它可以与公司内部的身份认证系统(如LDAP/AD)集成,实现单点登录和统一身份管理,大大简化了管理复杂性,并确保了权限策略的一致性。

二、💧 数据之源:全流程安全管理

%20拷贝-alzr.jpg)

数据的质量和安全是模型能力的基石。垃圾进,垃圾出(Garbage In, Garbage Out)的道理在AI领域尤为真切。因此,必须对数据进行从采集到标注的全流程精细化管理。

2.1 数据分级与脱敏

并非所有数据都生而平等。在数据入库的第一时间,就应进行分级分类。

对于涉及个人隐私的数据,敏感信息识别与脱敏是强制性动作。可以利用自动化工具(如开源的Microsoft Presidio或商业解决方案)结合自定义规则库,对数据中的个人身份信息(PII)、银行卡号、联系方式等进行扫描,并采取匿名化、假名化或数据屏蔽等方式进行处理。

2.2 数据清洗与标注质量

清洗和标注环节是确保模型“学得正、学得好”的关键。

自动化与人工复核

利用脚本和算法自动过滤掉大部分噪声数据、低质量数据和重复数据。但对于一些边界案例和高风险样本,必须引入人工审核机制,确保数据质量。合规比例控制

根据《生成式人工智能服务管理暂行办法》等法规要求,训练数据中包含的违法和不良信息比例必须被严格控制。实践中,这个比例应远低于法规上限(如5%),力求趋近于零。双人标注与一致性校验

对于主观性强或特别重要的标注任务(如内容定性、情感判断),应采用双人或多人背靠背标注的模式。通过计算标注者之间的一致性(如Kappa系数),来评估和保障标注质量。

2.3 数据血缘与可追溯性

建立**数据血缘(Data Lineage)**追踪机制至关重要。这意味着需要记录数据从采集、清洗、标注到最终被哪个版本的模型使用的完整链路。一旦发现模型出现问题或数据存在污染,可以快速定位问题源头,进行回滚或修复,避免灾难扩大。

三、🛠️ 模型之炼:训练与部署安全

模型训练是资源和智力高度密集的环节,其安全直接关系到AI应用的核心竞争力。

3.1 安全的训练环境

模型训练不应在开放的网络环境中进行。必须构建一个安全的、隔离的训练环境。

网络隔离:训练集群应部署在独立的VPC(虚拟私有云)中,通过严格的防火墙和安全组策略,限制对外的网络访问。

访问控制:只有授权的训练工程师和算法工程师才能访问训练环境和相关资源。所有访问都应通过堡垒机进行,并记录详细的操作日志。

基础设施安全:定期对训练环境的操作系统、依赖库进行漏洞扫描和安全加固,防止被黑客利用漏洞入侵。

3.2 模型资产的保护

模型本身,包括其参数文件和代码,是极其宝贵的核心资产。

加密存储:所有模型文件、参数和训练日志都应进行加密存储。即使存储介质被盗,没有密钥也无法读取内容。

模型水印:可以考虑在模型中嵌入独特的、难以察觉的数字水印。这是一种主动的保护措施。如果模型在未经授权的情况下被泄露或滥用,可以通过提取水印来追溯泄露源头,为维权提供证据。

3.3 深度防御:应对模型投毒与后门攻击

除了常规防护,我们还必须警惕更隐蔽的攻击,如模型投毒。这类攻击在训练阶段植入“后门”,在推理阶段通过特定“触发器”引爆,危害极大。

3.4 隐私计算:构建数据安全的护城河

当我们需要利用多方敏感数据进行联合训练,或在云上处理高度机密信息时,传统的加密和访问控制就不够了。**隐私计算(Privacy-Preserving Computation)**技术应运而生,它旨在实现“数据可用不可见”,即在不暴露原始数据内容的前提下,完成计算和分析任务。

3.4.1 机密计算(Confidential Computing)

机密计算解决了数据在**“使用中”**的安全问题。传统数据保护主要关注“传输中”(用TLS加密)和“存储中”(用磁盘加密),但数据一旦加载到内存进行计算,就是明文状态,存在被恶意软件或特权用户窃取的风险。

核心原理:机密计算通过硬件(如Intel SGX、AMD SEV等)在CPU内部创建一个被称为**“可信执行环境”(TEE,Trusted Execution Environment)**的加密隔离区。这就像在计算机内部开辟了一个无法被窥探的“保险箱”。

工作流程:数据以加密形式进入TEE,在TEE内部解密并进行计算,计算结果在离开TEE前再次加密。整个过程,即便是云服务商或操作系统管理员,也无法访问TEE内部的明文数据和代码。

在LLM中的应用:

保护敏感训练数据:金融机构、医疗机构可以在不将客户隐私数据暴露给云平台的情况下,安全地利用云端算力进行模型训练。

保护模型知识产权:企业可以将自己专有的模型架构和参数放在TEE中进行训练和推理,有效防止核心IP被窃取。

实践挑战:当前TEE的硬件内存容量相对有限,对于动辄千亿参数的大模型,单机TEE难以承载。因此,分布式TEE方案是未来的发展方向,但这会引入更高的技术复杂性。

3.4.2 联邦学习(Federated Learning)

联邦学习的核心理念是**“数据不动模型动”**,它是一种分布式的机器学习范式,尤其适用于数据孤岛问题。

核心原理:多个数据持有方(如多家医院)可以在不共享本地数据的情况下,联合训练一个共享模型。

工作流程:

中央服务器初始化一个全局模型,并将其分发给各个参与方。

各参与方利用本地数据对模型进行训练,但不上传原始数据,只上传加密或加扰后的模型更新(如梯度或模型权重)。

中央服务器安全地聚合所有参与方的模型更新,用以优化全局模型。

重复以上过程,直至模型性能收敛。

在LLM中的应用:

跨机构联合建模:多家银行可以联合训练一个更强大的反欺诈大模型,而无需共享各自的客户交易数据。

终端个性化微调:手机输入法可以利用用户在本地的输入习惯来微调模型,提升个性化推荐的准确性,同时用户的输入数据永远不会离开设备。

安全补充:单纯的联邦学习仍有隐私风险(如通过模型更新反推原始数据)。因此,实践中通常需要结合差分隐私等技术,对上传的模型更新添加噪声,提供更强的数学意义上的隐私保护。

3.4.3 差分隐私(Differential Privacy)

差分隐私提供了一种可量化的隐私保护承诺。其核心思想是,在数据集的计算结果中添加经过精确计算的“噪声”,使得查询结果对于数据集中是否存在任意单个个体的信息不敏感。

核心原理:如果一个算法在包含你的数据和不包含你的数据两种情况下,输出结果的概率分布几乎相同,那么这个算法就满足差分隐私。攻击者无法从结果中确定你的数据是否被使用。

隐私预算(ε):这是衡量隐私保护强度的关键参数。ε越小,添加的噪声越多,隐私保护水平越高,但计算结果的准确性(模型效用)会相应下降。在实践中,需要在隐私和效用之间做出权衡。

在LLM中的应用:

保护训练数据:在训练开始前,对原始数据集应用差分隐私处理。

保护模型更新:在联邦学习中,各参与方在上传模型梯度前,先用差分隐私添加噪声。

3.5 安全对齐与鲁棒性增强

一个强大的模型,不仅要聪明,更要“懂规矩”。

安全对齐(Safety Alignment):通过监督微调(SFT)和来自人类反馈的强化学习(RLHF),向模型灌输人类社会的价值观和行为准则。简单来说,就是用大量高质量的“正向”和“反向”示例,教会模型什么是该说的,什么是不该说的。

对抗性训练:这就像给模型“打疫苗”。主动制造一些典型的攻击样本(如轻度的提示词注入、包含偏见的提问),并将它们加入到训练数据中。通过学习这些“坏”样本,模型能够增强对同类攻击的“免疫力”,提升其鲁棒性。

四、🛡️ 应用之盾:推理阶段的动态防御

%20拷贝-twiw.jpg)

模型上线提供服务后,就暴露在了真实、复杂的网络环境中。必须为其构建一个强大的“安全护盾”。

4.1 输入输出内容风控

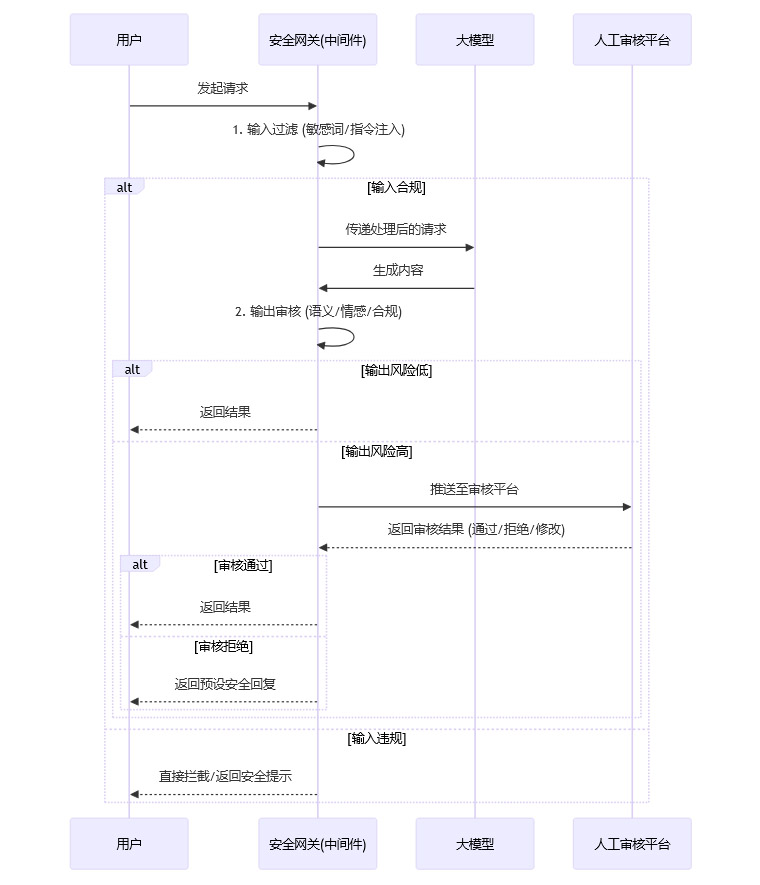

这是保障应用安全的最后一道,也是最重要的一道防线。一个典型的风控流程如下所示。

输入过滤:部署大模型防火墙(LLM-WAF),实时检测并拦截包含敏感词、恶意指令、提示注入攻击的输入。

输出审核:对模型生成的内容进行实时合规检测。这不仅是简单的关键词匹配,更需要借助NLP技术进行语义分析,识别那些“话里有话”的违规内容。

4.2 内容风险分级处置

对于检测到的风险,应采取分级处置策略。

这个过程形成了一个反馈闭环。人工审核的结果不仅用于处理当次请求,更会作为高质量的标注数据,反哺给风控模型和LLM本身,使其持续进化,变得越来越智能。

五、📜 合规治理与透明化

在强监管的背景下,合规是AI应用生存的底线。

5.1 遵循法律法规

开发和运营大模型应用,必须严格遵守《网络安全法》、《数据安全法》、《个人信息保护法》以及《生成式人工智能服务管理暂行办法》等一系列法律法规。这意味着在数据处理、用户隐私保护、内容生成等方面,都要有明确的合规策略。

5.2 备案与安全评估

根据规定,提供生成式AI服务的应用在上线前,必须完成算法备案和安全评估。这通常需要向监管部门提交包括安全报告、风险评估、拦截词库、评测题库等在内的一系列材料,并接受审核。

5.3 提升透明度

虽然模型的内部决策过程复杂,但我们仍可以在多个层面提升其透明度。

全链路审计:利用中间件统一收集和加密存储所有安全相关的日志,包括权限变更、数据访问、API调用、内容审核记录等。这些日志应支持仪表盘可视化展示,便于安全人员监控和审计。

对外公示:在产品界面或官网的适当位置,向用户公示模型的备案信息、数据来源的基本情况、以及为保障安全合规所采取的主要措施。这有助于建立用户信任。

可解释性工具:对于内部调试和分析,可以借助如SHAP、LIME等可解释性工具,来分析模型做出某个具体判断的原因,这对于理解和修复模型的偏见或错误非常有帮助。

六、🔄 持续运营与安全迭代

安全不是一次性的建设,而是一个持续对抗和演进的过程。

红队测试与攻防演练:定期组织内部或邀请外部的安全专家,扮演攻击者(红队),对系统进行全方位的模拟攻击。这能最直接地发现系统中的薄弱环节和未知漏洞,从而驱动安全策略的持续优化。

用户反馈与策略更新:建立通畅的用户反馈渠道。用户在使用中发现的不良内容或安全问题,是改进模型和安全策略的宝贵输入。安全团队应持续收集和分析这些反馈,动态更新敏感词库、优化风控模型。

安全意识培训:定期对所有参与模型开发和运营的人员进行安全意识和技能培训。人的因素是安全链条中最重要也最脆弱的一环,提升整个团队的安全素养至关重要。

总结

构建可信AI,是一场持久战,也是一项系统工程。本文提出的方案,从精细化的权限管理出发,贯穿了数据、模型、训练、应用的全生命周期。

它强调技术与管理的结合。没有精细化的角色和权限划分,再好的技术也可能因为内部疏忽而失效。

它强调纵深防御。从输入端的WAF,到训练中的隐私计算,再到输出端的多层审核,层层设防,不寄希望于任何单一的“银弹”。

它强调持续迭代与反馈闭环。无论是红队测试的发现,还是人工审核的“难例”,都应成为驱动安全体系进化的宝贵燃料。

大模型的浪潮势不可挡,而安全,正是决定这股浪潮是带来福祉还是灾难的堤坝。构建坚实、智能、可持续的安全体系,是我们每个从业者义不容辞的责任。

📢💻 【省心锐评】

大模型安全,别总想着堵漏洞。从权限、数据到模型内部,把规矩立好,让AI“学好”,比什么都强。

.png)

%20%E6%8B%B7%E8%B4%9D-hica.jpg)

评论