【摘要】OpenAI更新ChatGPT使用政策,禁止在医疗、法律、财务领域提供个案化专业建议。此举旨在主动对齐欧盟AI法案与FDA规范,隔离法律风险,并预示着AI正从通用模型向可信的垂直领域解决方案演进。

引言

2023年10月29日,OpenAI悄然更新了其模型的使用政策。这一调整在随后的几周内,通过开发者社区与媒体的传播,迅速成为技术圈的焦点。其核心内容直指ChatGPT等模型最受争议也最具潜在价值的应用场景——禁止提供专业的医疗、法律和财务建议。

这并非一次简单的功能削减。从技术架构师的视角看,这更像是一次深思熟虑的战略性后撤。它标志着大型语言模型(LLM)的开发者,在经历了“能力狂飙”的阶段后,开始系统性地转向“责任优先”的工程范式。这次边界的重绘,背后是全球监管浪潮、技术内在局限性与未来商业模式探索三者交织作用的结果。它不仅影响着数亿普通用户的使用体验,更深刻地预示了AI技术栈下一阶段的演进方向。

🎯 一、 政策解析:边界的重绘与技术落脚点

%20拷贝-zjgx.jpg)

此次政策更新的核心,在于为模型的输出能力划定一条清晰的红线。这条红线区分了“通用知识科普”与“个案化专业咨询”。前者被允许,后者则被严格禁止。

1.1 禁止范围:高风险领域的“硬隔离”

OpenAI的禁令主要集中在三个与个人福祉、财产和权利密切相关的高风险(High-Stakes)领域。这些领域的共同特点是,错误的建议可能导致不可逆的严重后果,且从业者通常需要持有专业牌照并承担法律上的受托责任(Fiduciary Duty)。

为了更清晰地理解其边界,我们将具体禁止的行为整理如下:

这些限制的本质是阻止模型输出可直接执行(Actionable)且与个体强相关的指令性内容。

1.2 允许范围:通用知识的“安全区”

政策收紧的同时,OpenAI也明确了模型可以继续提供服务的“安全区”。这个区域聚焦于非个案化、通用性、教育性的信息。

这种划分的底层逻辑是,模型可以作为信息检索和知识解释的强大工具,但不应成为承担决策责任的代理。

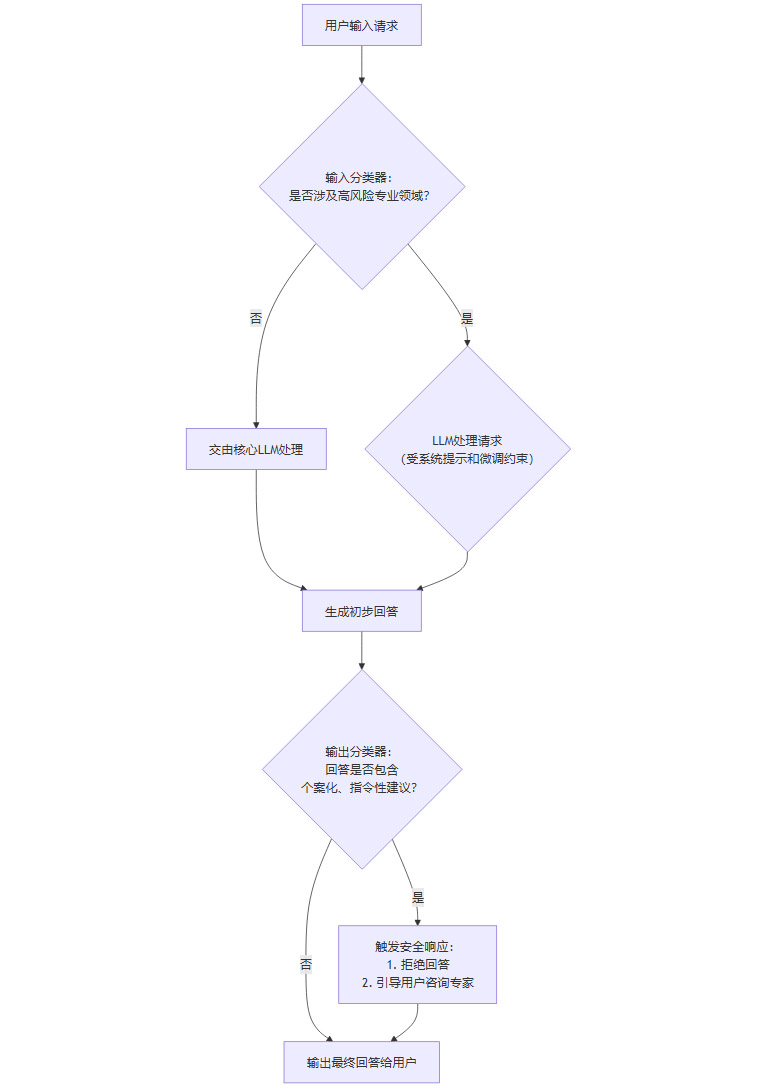

1.3 执行机制:从模型能力到安全护栏

用户最直观的感受是,当提出越界的请求时,模型会明确拒绝并引导其寻求专业人士的帮助。例如,Reddit用户上传医学影像被拒,就是这一机制触发的典型案例。从技术实现上看,这种“拒答”并非简单的关键词屏蔽,而是一个多层次的安全体系。

指令微调(Instruction Fine-Tuning):在模型的预训练和微调阶段,就通过大量的负样本进行训练。这些样本包含明确的“拒绝提供专业建议”的指令和示范回答,让模型从根本上学习到这条边界。

提示工程(Prompt Engineering):在每次会话开始时,系统会通过一个隐藏的元提示(Meta-Prompt)或系统提示(System Prompt)为模型设定角色和行为准则,其中就包含了“你不能扮演医生/律师/理财顾问”等约束。

输入/输出过滤器(I/O Filters):在用户输入和模型输出的环节,部署了独立的分类器模型。这些分类器专门用于检测请求是否涉及高风险领域,或者模型的输出是否包含了违禁的建议内容。一旦检测到,就会触发拒答或改写机制。

红队测试(Red Teaming):OpenAI持续雇佣专家团队,通过对抗性测试,不断寻找绕过安全护栏的方法(即“越狱”),然后用这些失败案例来加固模型和过滤器的鲁棒性。

我们可以用一个简化的流程图来表示这个决策过程:

这个流程清晰地展示了,模型的响应不再是单一的生成过程,而是一个内置了多重校验与风险控制的复杂工作流。

🎯 二、 驱动力深潜:合规、担责与技术局限的共振

OpenAI此次调整并非心血来潮,而是多重压力下的必然选择。其中,全球性的AI监管立法是其最直接的外部推力。

2.1 全球监管对齐:EU AI Act与FDA的“达摩克利斯之剑”

全球范围内,针对AI的立法进程正在加速,其中以欧盟的《人工智能法案》(EU AI Act)最具代表性和影响力。

2.1.1 欧盟《人工智能法案》的风险分层模型

EU AI Act的核心思想是基于风险的分层监管。它将AI系统分为四个等级:

不可接受风险(Unacceptable Risk):全面禁止。如政府主导的社会评分系统。

高风险(High Risk):受到最严格的监管。ChatGPT在医疗诊断、法律判决辅助等场景的应用,几乎确定会被归入此类。

有限风险(Limited Risk):需履行透明度义务。如聊天机器人需告知用户正在与AI交互。

最小风险(Minimal Risk):基本不受限制。

对于“高风险”AI系统,法案要求其在投入市场前和整个生命周期中,必须满足一系列严苛的要求,包括:

高质量的数据集:确保训练数据的准确性和无偏见。

详细的技术文档与记录保存:具备完整的可追溯性。

清晰的用户信息与透明度:让用户了解系统的能力和局限。

有效的人类监督(Human Oversight):确保任何时候都能由人进行干预。

极高的准确性、鲁棒性和网络安全水平。

更关键的是,违反法案的罚款极为高昂,最高可达公司全球年营业额的7%或3500万欧元(以较高者为准)。面对如此明确且严厉的法律框架,OpenAI主动收缩在高风险领域的服务,是最理性的风险规避策略。

2.1.2 美国FDA对医疗AI的监管框架

在美国,食品药品监督管理局(FDA)对用于医疗目的的软件(Software as a Medical Device, SaMD)有着成熟的监管体系。如果一个AI应用的功能是“驱动临床管理”,例如通过分析影像来诊断疾病,它就会被视为医疗设备,必须经过严格的审批流程才能上市。

OpenAI的ChatGPT作为通用模型,并未也难以通过FDA的审批。因此,明确禁止其提供医疗诊断服务,是避免触犯FDA监管红线的必要举措。

2.2 法律责任规避:无法承受的“受托”之重

在法律和金融领域,专业人士对其客户负有受托责任。这意味着他们必须以客户的最佳利益行事,并对自己的建议承担法律后果。

LLM目前的技术特性决定了它无法承担这种责任:

“幻觉”问题(Hallucination):模型可能会一本正经地编造事实、法律条款或判例,这种信息的不可靠性在专业领域是致命的。

知识截止日期(Knowledge Cut-off):模型的知识是静态的,无法实时跟进最新的法律法规或市场动态。

缺乏上下文理解:模型无法真正理解用户个人情况的全部复杂性和细微差别,其建议往往是基于概率的“文本补全”,而非真正的逻辑推理和利弊权衡。

如果OpenAI允许其模型提供此类建议,一旦用户因采纳错误建议而蒙受损失,OpenAI将面临无穷无尽的诉讼。因此,从法律和商业风险管理的角度,剥离这些功能,将责任链牢牢地锁定在持牌的人类专家身上,是唯一的选择。

2.3 技术伦理的自省:从“能做什么”到“该做什么”

这次调整也反映了AI行业内部正在发生的一场深刻的理念转变。在技术发展的早期,行业的焦点是不断突破模型能力的上限(Scaling Law),即“能做什么”。但随着技术影响力的指数级增长,其潜在的负面效应也日益凸显。

现在,头部公司开始更多地思考“该做什么”和“不该做什么”。这是一种技术伦理的成熟表现。将“个案化、可执行的专业指令”明确归类为高风险应用并加以限制,正是这种责任优先于能力的思维转变的具体体现。这不仅是对外部监管的回应,也是对技术自身社会责任的内在要求。

🎯 三、 架构演进:从通用大模型到垂直领域可信AI

%20拷贝.jpg)

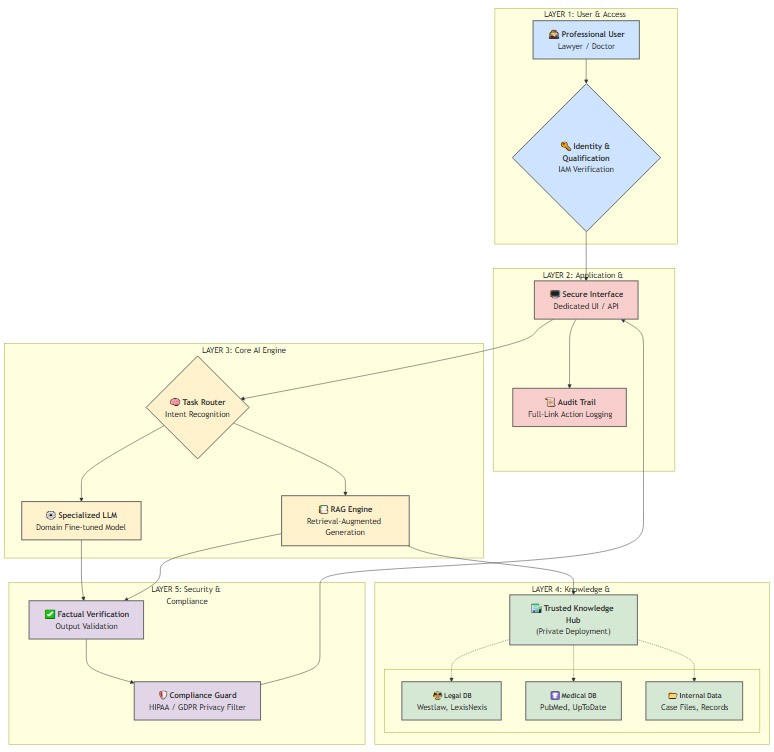

禁止通用模型提供专业建议,并不意味着AI在这些领域的终结。恰恰相反,它可能催生一个全新的、更具商业价值的市场——面向持证专业人士的垂直领域AI解决方案。

3.1 通用模型的局限性与垂直化的必然性

通用大模型(如公版的ChatGPT)在专业领域的应用,存在几个难以克服的结构性缺陷:

知识源的泛化与污染:其训练数据来自广阔的互联网,虽然知识面广,但也混杂了大量过时、错误、甚至有害的信息。对于需要绝对精准的专业领域,这是不可接受的。

缺乏领域特有的推理能力:法律推理需要严密的逻辑链,医疗诊断需要复杂的鉴别诊断流程。这些都不是通用模型所擅长的。

合规与隐私的挑战:处理医疗记录(HIPAA)、客户财务数据(GDPR)等敏感信息,需要极高的安全和隐私保护标准,通用开放式平台难以满足。

因此,未来的专业AI服务,必然走向垂直化、专用化和可信化。

3.2 垂直领域AI的技术架构设想

一个面向律师的“ChatGPT法律版”或面向医生的“医疗版”,其技术架构将与通用版截然不同。它会是一个集成了多重可信增强机制的复杂系统。

这个架构的核心组件包括:

身份与资质验证(Identity and Access Management, IAM):这是系统的入口。必须通过与权威机构(如律师协会、医师协会)的数据库API对接,严格验证使用者的专业资质。这是确保系统被用于专业辅助而非滥用的第一道防线。

检索增强生成(Retrieval-Augmented Generation, RAG):这是保证信息准确性的关键。模型不再仅仅依赖其内部的“记忆”,而是被强制要求从一个可信的、实时更新的、私有化的专业知识库中检索相关信息,并基于这些信息来生成答案。这极大地降低了“幻觉”的风险,并使得所有答案都有据可查。

领域专用微调LLM(Domain-Specific Fine-tuned LLM):基础模型会使用海量的专业文献、案例、法律条文进行深度微调,使其掌握领域的专业术语、推理模式和行文风格。

全链路审计与留痕(Audit Trail):用户的每一次查询、模型的每一次回答、引用的每一条知识源,都会被完整记录,形成不可篡改的日志。这对于事后追责、合规审查至关重要。

人在环路(Human-in-the-Loop):系统设计上会鼓励甚至强制专业人士对AI生成的内容进行审核、修改和最终确认,AI始终扮演的是“副驾驶”而非“自动驾驶”的角色。

3.3 商业模式的重塑

这种垂直化的解决方案,其商业模式也将从目前面向C端的订阅制,转向面向B端和专业人士的高价值企业服务。收费模式可能包括按调用量计费、按席位订阅、或与专业数据库打包销售。这不仅为OpenAI等公司开辟了新的收入来源,也为传统的专业数据库服务商(如律商联讯、万方数据)提供了与AI技术结合的转型契机。

🎯 四、 生态影响与未来展望:人机协作的新范式

%20拷贝.jpg)

OpenAI的这次政策调整,将在整个AI生态中引发一系列连锁反应,并塑造未来人机协作的新形态。

4.1 对普通用户:从“万能顾问”回归“高效工具”

对于普通用户而言,将ChatGPT作为免费“私人顾问”的时代已经结束。这无疑会带来一定程度的失落感,特别是对于那些曾借助它降低信息获取成本的用户。用户需要重新调整对通用AI的预期,理解其边界,将其定位为一个强大的信息检索、文本处理和知识学习工具,而非决策的替代品。信息的可得性与决策的可靠性之间的权衡,被再次放大。

4.2 对专业人士:从“潜在威胁”变为“赋能杠杆”

此前,许多专业人士对AI持有一种复杂的态度,既看到了其潜力,也感到了被替代的威胁。新政策的出台,在某种程度上为他们提供了“职业防护盾”,明确了AI的辅助地位。未来,专业人士的工作流将被深度重塑。

律师:可以利用AI在几秒钟内完成过去需要数小时的案例研究、合同模板比对、证据摘要等工作。

医生:可以利用AI快速分析海量医学文献,获取最新的诊疗指南,或辅助撰写病历报告。

金融分析师:可以利用AI处理复杂的财务报表,识别市场趋势,生成研究报告初稿。

AI将成为专业人士的认知增强器(Cognitive Augmentor),将他们从重复性、信息密集型的工作中解放出来,更专注于需要经验、判断力和人际沟通的核心价值环节。

4.3 对开发者生态:合规成为应用开发的必修课

对于构建在OpenAI API之上的广大第三方应用开发者而言,他们同样需要遵守这一政策。这意味着,任何试图“包装”ChatGPT提供专业咨询服务的应用,都将面临被封禁的风险。开发者在设计产品时,必须内置相应的安全护栏和免责声明。AI应用的开发,将不再仅仅是技术问题,更是一个合规问题和产品伦理问题。

4.4 后续关注点

此次调整只是一个开始。未来,我们还需要持续关注几个关键问题:

政策执行的粒度:拒答机制的“误判率”和“漏判率”如何?是否存在申诉或白名单机制?

API与集成的落地:在API调用中,这些限制的执行力度是否与Web界面一致?

地区监管差异:不同国家和地区的监管政策不一,OpenAI是否会推出区域化的合规策略?

开源模型的挑战:对于不受单一公司控制的开源大模型,如何实现类似的风险管控,将成为整个开源社区面临的共同挑战。

结论

OpenAI为ChatGPT划定的新边界,绝非一次简单的功能取舍。它是一次深刻的战略聚焦,是AI产业从野蛮生长的探索期,迈向规范化、责任化、商业化深水区的关键一步。通过主动拥抱监管、隔离法律风险,OpenAI不仅保护了自身,也为整个行业树立了一个“责任优先”的标杆。

这一举措暂时关闭了通用AI通往专业咨询的大门,但同时,它也推开了一扇通往垂直领域、可信AI的窗。未来的AI,将不再追求成为一个无所不知的“先知”,而是会分化为一系列精准、可靠、安全的“专家助手”,深度嵌入各行各业的工作流之中,最终实现与人类专家之间更成熟、更可持续的协作共生。对于我们技术从业者而言,理解并适应这一转变,将是把握下一波AI技术浪潮的关键。

📢💻 【省心锐评】

OpenAI此举是战略性收缩,用短期功能限制换取长期合规安全。它宣告了通用AI“万能顾问”幻想的终结,开启了垂直领域“可信AI助手”的黄金赛道,责任与合规正成为AI产品的核心竞争力。

.png)

%20%E6%8B%B7%E8%B4%9D-uukw.jpg)

评论