【摘要】SuperSimpleNet开创性地构建了一个统一框架,能够无缝适应全监督、弱监督、混合监督与无监督四种工业检测场景。它通过精巧的合成异常生成与双分支架构,在保证顶尖精度的同时实现了9.5毫秒的极速推理,真正解决了工业AI落地中的数据标注难题。

引言

在现代制造业的精密世界里,产品表面的一个微小瑕疵,可能就是一道关乎成败的裂痕。质量检测,这道生产流程的最后防线,其重要性不言而喻。长久以来,这道防线主要由人类的眼睛守护。但人眼终究不是精密的仪器,疲劳、主观判断、效率瓶颈,这些都成了悬在产品质量头上的达摩克利斯之剑。

人工智能的浪潮涌来,带来了自动化的曙光。基于计算机视觉的缺陷检测系统开始在产线上崭露头角。但新的问题也随之而来。这些AI系统往往像个“挑食的孩子”,对喂给它们的数据有着苛刻的要求。有的模型,必须要有大量精确标注了缺陷位置的“精装教科书”才能学会;有的模型,则只能消化完全没有缺陷的“健康样本”,通过找不同来发现问题。

这种“挑食”的特性,给实际的工业应用带来了巨大的麻烦。工厂的数据情况是复杂多变的。一条新产线,可能只有海量的正常样本;生产了一段时间后,或许积累了一些有缺陷的样本,但工人只来得及贴上“不合格”的标签,没时间去精细描绘缺陷在哪。更常见的情况是,数据仓库里混杂着各种类型的样本。为每一种情况都去开发、部署、维护一套独立的AI系统,成本高昂,效率低下。

工业界一直在呼唤一个“不挑食”的、能够适应各种数据环境的“全能选手”。

现在,这个选手登场了。来自卢布尔雅那大学计算机与信息科学学院的三位研究者Blaz Rolih、Matic Fucka和Danijel Skocaj,带来了他们的杰作——SuperSimpleNet。这项研究成果的论文《No Label Left Behind: A Unified Surface Defect Detection Model for all Supervision Regimes》已公开发表(arXiv:2508.19060),并且代码也已在GitHub上开源(https://github.com/blaz-r/SuperSimpleNet),为整个行业带来了全新的解决方案。

SuperSimpleNet的设计哲学,正如其论文标题所言,“不浪费任何一张标签”。它像一位经验丰富的全科医生,无论拿到的是详细的“病历本”(完全监督)、简单的“诊断记录”(弱监督)、混杂的资料(混合监督),还是仅仅一叠“健康体检报告”(无监督),它都能从中学习,并给出精准的判断。这不仅仅是一次技术的迭代,更是对工业缺陷检测范式的一次重新定义。

一、💡 SuperSimpleNet - 一场颠覆性的技术革命

%20拷贝-ptot.jpg)

SuperSimpleNet之所以被称为颠覆性,是因为它从根本上解决了工业AI应用中最核心的矛盾之一,即算法对特定标注数据的依赖性与工业现场数据多样性之间的矛盾。它用一个统一、优雅的框架,实现了对所有主流监督范式的兼容。

1.1 统一范式:告别数据标注的“选择困难症”

在SuperSimpleNet出现之前,缺陷检测领域壁垒分明,不同的监督范式对应着不同的技术路线。企业在选择方案时,常常陷入“选择困难症”。SuperSimpleNet则打破了这些壁垒,让选择变得简单。

它能够灵活适应以下四种学习场景:

完全监督学习 (Fully Supervised)

这就像是开卷考试,每一张缺陷图都附带了精确到像素的“标准答案”(Mask)。模型可以清晰地知道缺陷在哪里、长什么样。这是最理想的情况,但标注成本也最高。弱监督学习 (Weakly Supervised)

这好比是判断题,只告诉模型这张图“有缺陷”或“无缺陷”,但不指明具体位置。这种标注成本低廉,在工业界很常见。混合监督学习 (Mixed Supervised)

这是工业现场最真实的写照。数据集中既有少量精细标注的样本,也有大量只有图像级标签的样本。如何同时利用好这两种信息,是业界的一大难题。无监督学习 (Unsupervised)

这是最极端的情况,训练数据里全是“好”的产品,没有任何缺陷样本。模型需要自己学会什么是“正常”,然后把一切“不正常”的都揪出来。

SuperSimpleNet通过一个统一的模型架构和训练策略,将这四种看似迥异的场景完美地融合在一起。

1.2 核心三驾马车:创新技术的协同之力

SuperSimpleNet的强大能力,源于其三大核心技术创新的协同作用。它们就像支撑起这座技术大厦的三根支柱,缺一不可。

1.2.1 改进的合成异常生成

这是模型能够在数据稀疏时依然表现出色的秘密武器。它能在特征层面创造出以假乱真的“人造缺陷”,极大地丰富了训练数据,帮助模型学习更泛化的缺陷模式。

1.2.2 简单高效的双分支架构

模型设计了两个协同工作的“部门”,一个负责精确定位(分割分支),一个负责全局判断(分类分支)。这种设计既保证了对细节的洞察力,又具备了宏观的决策能力,实现了精度与效率的平衡。

1.2.3 统一的学习框架

这是整个系统的“大脑中枢”。通过一个巧妙的控制参数,框架能够智能地判断当前数据的类型,并自动调整学习策略,确保每一份标注信息都物尽其用,真正做到“No Label Left Behind”。

二、🎨 合成异常的艺术:从像素涂抹到特征雕刻

如果说数据是模型的食粮,那么在食粮不足时,学会自己“烹饪”就显得至关重要。SuperSimpleNet的合成异常生成技术,就是一位顶级的“数据大厨”。传统方法生成人工缺陷,往往像是在图像上随意涂抹色块,生硬而不自然。SuperSimpleNet则完全不同,它的过程更像是一场精密的艺术创作。

2.1 生成流程的精妙编排

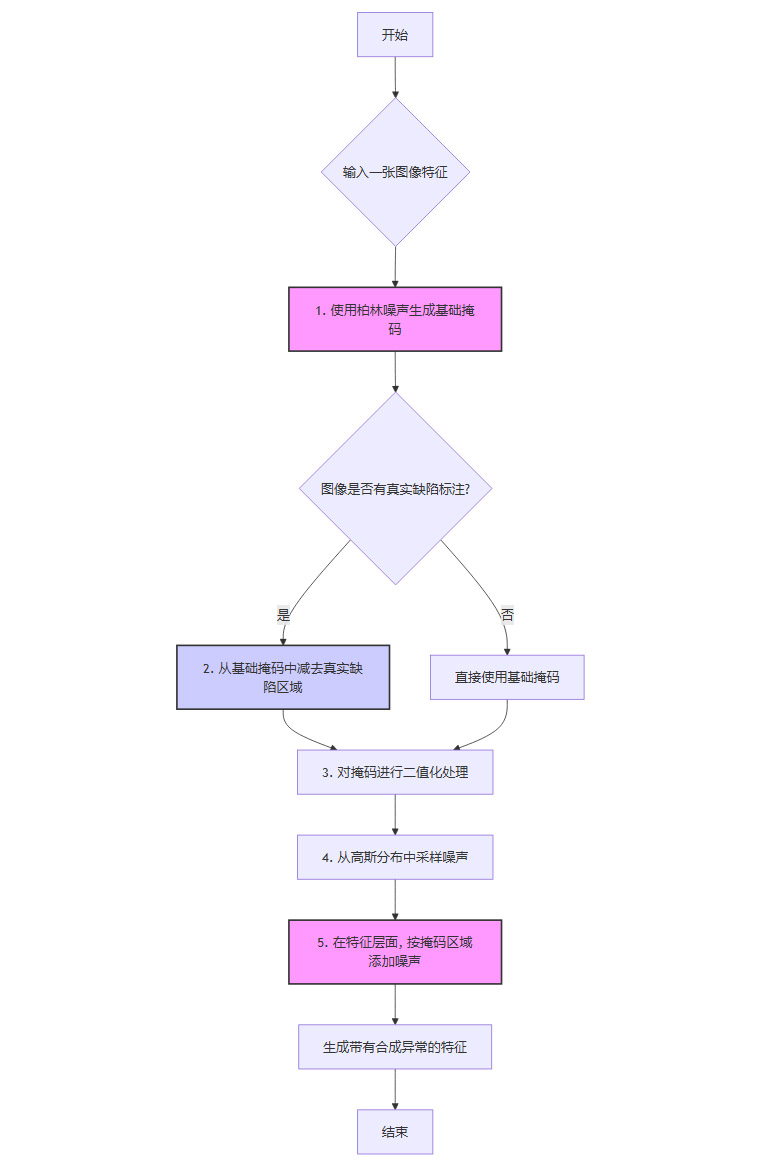

整个合成过程被精心设计为几个步骤,确保了生成异常的真实性和有效性。我们可以用一个流程图来清晰地展示这个过程。

这个流程有几个关键的创新点:

柏林噪声 (Perlin Noise) 的运用

它不像普通随机噪声那样杂乱无章,而是能产生自然的、空间上连续的纹理。用它生成的缺陷掩码,在形状和分布上更接近真实的裂纹、划痕或污渍。避免与真实缺陷重叠

这是一个极其巧妙的设计。如果一张图已经有了真实的缺陷标注,系统会确保新生成的人工缺陷不会与它重叠。这就像一位画家在画作上添加新的元素时,会小心翼翼地避开已经完成的主体,避免信息冲突和混淆。特征层面的注入

这是与传统方法最本质的区别。SuperSimpleNet不是在原始的像素图像上“画”缺陷,而是在经过深度网络提取的“特征图”上添加噪声。这好比不是给菜肴表面撒调料,而是将味道直接注入到食材的精华之中。这样做的好处是,生成的异常更符合真实缺陷在深度特征空间中的表达方式,对模型的训练也更有效。

2.2 场景自适应的智慧

这位“数据大厨”还懂得根据不同的“食客”(监督场景)调整“菜谱”。它通过调整柏林噪声的二值化阈值,来控制生成异常的大小和强度。

这种自适应的策略,使得合成异常生成机制在任何场景下都能发挥最大的效用,成为SuperSimpleNet强大泛化能力的重要保障。

三、🔬 双分支架构:显微镜与望远镜的完美结合

%20拷贝-cbax.jpg)

为了同时完成“哪里有缺陷”和“到底有没有缺陷”这两个任务,SuperSimpleNet采用了一种精妙的双分支架构。这就像一个侦探团队,既有手持放大镜、仔细勘察现场的法证专家,也有站在高处、掌控全局的总指挥。

3.1 分割分支:像素级的“现场勘查员”

这个分支的核心任务是精确定位。它继承了其前身SimpleNet的基础设计,负责对图像进行逐像素的分析,最终生成一张异常概率图(Anomaly Map)。在这张图上,每个像素点的亮度代表了该点是缺陷的概率。

为了让这位“勘查员”的工具更趁手,研究团队还为它配备了一个特征适配器 (Feature Adaptor)。这个小模块可以对从骨干网络提取的特征进行微调,使其更好地适应当前特定的缺陷检测任务,从而提升定位的准确性。

3.2 分类分支:全局视角的“总指挥”

分类分支则负责回答那个更宏观的问题,这个产品合格吗? 它不纠结于每个像素的细节,而是着眼于整张图像的全局信息,给出一个总体的异常评分。

这个分支的设计看似简单,却蕴含着巧思。它使用了一个5×5的大尺寸卷积核。相比于常见的3×3卷积核,更大的卷积核意味着更大的感受野,能够一次性捕捉到更大范围的上下文信息。这就像总指挥用的是广角望远镜而不是显微镜,能更好地把握全局态势,有效减少因局部纹理扰动而产生的误报。

3.3 协同作战:信息流动的艺术

这两个分支并非各自为战,它们之间存在着巧妙的信息交互。分割分支生成的异常概率图,在作为最终定位结果输出的同时,还会被传递给分类分支,作为其决策的额外参考信息。

这个设计意义重大。它相当于“现场勘查员”将详细的勘查报告提交给了“总指挥”。总指挥在做出最终判断时,不仅有自己的全局观察,还有了一份详尽的局部证据。这种信息的融合,使得全局判断更加稳健可靠,尤其是在处理那些微小、分散或者与背景极其相似的隐蔽性缺陷时,效果显著。

3.4 损失函数的精巧设计

为了训练好这两个分支,研究团队也为它们量身定制了不同的“KPI考核标准”,也就是损失函数。

分割分支的损失函数

它采用了截断L1损失 (Clipped L1 Loss) 和 焦点损失 (Focal Loss) 的组合。截断L1损失 主要用于处理像素分布的极度不平衡(绝大部分像素是正常的)。它设定了一个阈值,当预测误差超过这个阈值时,损失不再增加,这可以防止模型被少数特别困难的像素点“带偏”,增强了训练的稳定性。

焦点损失 则专注于让模型更多地关注那些难以分类的像素点(比如缺陷的边缘),通过动态调整权重,实现“重点攻关”。

分类分支的损失函数

它只使用了焦点损失。因为对于图像级的二分类任务(正常/异常),焦点损失能够很好地处理样本不均衡问题(通常正常样本远多于异常样本),并聚焦于那些容易混淆的图像。

四、⚙️ 智能训练策略:因材施教的学习大师

SuperSimpleNet最令人赞叹的,莫过于其能够根据不同标注情况智能调整训练策略的能力。它就像一位顶级的教学大师,懂得对不同基础的学生“因材施教”。而实现这一切的“开关”,就是一个简单的控制参数 γ。

4.1 核心控制阀:γ参数的妙用

在训练过程中,每当模型拿到一张图片,它会首先判断这张图片的标注类型,然后通过设置γ的值来决定两个分支的学习模式。

这个设计堪称神来之笔。它巧妙地回避了一个经典难题,在只有图像级标签时,如果强迫分割分支去“猜”缺陷的位置,很可能会导致模型学到错误的定位知识,反而污染了特征表示,影响整体性能。通过γ参数,SuperSimpleNet确保了在任何时候,模型的学习都是在有明确监督信号的指导下进行的。

4.2 合成与真实的共舞

合成异常在整个训练策略中也扮演着多重角色。

在无监督场景下,它是模型唯一的“老师”,模型完全依赖它来理解什么是“缺陷”。

在其他监督场景下,它则变成了“助教”,作为真实缺陷样本的补充。研究团队的实验惊人地发现,即使在有大量真实缺陷数据的全监督场景下,加入合成异常的训练依然能够显著提升模型性能。这充分说明,通过合成数据来增加训练样本的多样性,对于提升模型的泛化能力至关重要。

4.3 幕后的工程美学

除了这些核心设计,SuperSimpleNet的成功也离不开一系列扎实的工程技巧。这些细节如同精密仪器的零部件,共同保证了系统的稳定与高效。

学习率调度器 (Learning Rate Scheduler) 在训练后期自动降低学习率,帮助模型更精细地收敛到最优解。

梯度裁剪 (Gradient Clipping) 防止在训练过程中因梯度爆炸导致的不稳定,保证了训练过程的平稳。

距离变换加权 (Distance Transform Weighting) 在计算损失时,降低对缺陷边界像素的权重,因为这些像素的标注往往存在不确定性,这样做可以减少标注噪声带来的负面影响。

五、📊 全面性能验证:在四大战场上的王者表现

%20拷贝-wjsm.jpg)

理论上的优雅设计,最终需要通过严苛的实验来证明其价值。研究团队在四个业界公认的高难度工业缺陷检测基准数据集上,对SuperSimpleNet进行了全方位的“大考”。

5.1 跨行业数据集概览

这次“大考”的考场覆盖了多个行业,确保了验证的全面性。

SensumSODF 制药行业数据集,包含软硬两种胶囊的图像,缺陷类型多样。

KSDD2 钢铁表面缺陷数据集,缺陷微小且与背景纹理相似,检测难度大。

MVTec AD 经典的工业异常检测基准,包含15个类别的产品,场景丰富。

VisA 另一个大规模、高难度的工业异常检测基准。

5.2 性能数据横向对比

在这些数据集上,SuperSimpleNet的表现堪称惊艳。它不仅在自己擅长的“统一”赛道上一骑绝尘,在各个“单项”赛道上也展现出了与顶级专用模型分庭抗礼甚至超越的实力。

核心性能指标对比 (AU-PRO %)

从表格中可以清晰地看到,SuperSimpleNet在所有场景下都达到了业界顶尖水平。尤其是在弱监督和混合监督场景下,其性能与完全监督场景的差距微乎其微,这正是其“不浪费标签”设计哲学的最佳体现。

5.3 速度与效率的较量

在工业界,精度和速度同等重要。一个模型再准,如果处理一张图片需要几秒钟,那也无法应用在高速运转的产线上。SuperSimpleNet在设计之初就充分考虑了效率问题。

推理速度对比

9.5毫秒的处理时间,意味着每秒可以处理超过260张图片。这个速度足以满足绝大多数工业实时检测的需求,展现了其在性能和效率之间取得的极致平衡。

5.4 消融实验:探寻成功的基石

为了验证每个创新点的具体贡献,研究团队还进行了详尽的消融实验,就像拆解一台精密仪器,逐一分析每个零件的作用。

核心组件贡献分析 (以AU-PRO % 提升为例)

实验结果清晰地证明了,SuperSimpleNet的每一项设计都不是冗余的,它们共同构成了模型强大的综合能力。

六、🏭 落地为王:工业场景的广泛适用性

SuperSimpleNet的真正价值在于其强大的场景适应能力,它几乎可以无缝对接到一条产线从建立到成熟运营的全生命周期。

7.1 新建产线:从零开始的冷启动

在产线调试或新产品试产阶段,往往只有大量的合格品样本。此时,SuperSimpleNet可以在无监督模式下运行,仅通过学习正常样本的外观,就能有效识别出任何偏离正常模式的异常品。7.2 生产初期:数据稀疏的爬坡期

随着生产的进行,开始出现少量缺陷品。工人可能只来得及做简单的“合格/不合格”判定。这时,系统可以切换到弱监督模式,利用这些宝贵的图像级标签来优化模型,提升检测性能。7.3 稳定生产:混合数据的常态化

在日常生产中,质检部门可能会对一些典型的、高发的缺陷进行精细标注以供分析,而对大多数缺陷品仍只做简单判定。SuperSimpleNet的混合监督能力在此刻大放异彩,它能同时消化这两种数据,实现信息利用的最大化。7.4 成熟产线:数据丰富的精益求精

对于质量要求极高、数据积累充分的成熟产线,可以采用完全监督模式。此时SuperSimpleNet将发挥其全部潜力,不仅能做出最准确的判断,还能提供精确的缺陷定位和分割结果,为后续的工艺改进和质量分析提供详尽的数据支持。

七、🤔 理性审视:系统的局限与未来改进空间

%20拷贝.jpg)

尽管SuperSimpleNet取得了巨大的成功,但研究团队依然以严谨的科学态度,指出了其存在的局限性和未来的改进方向。

对预训练模型的依赖

系统性能的发挥,很大程度上得益于在ImageNet上预训练的WideResNet50骨干网络。如果检测对象的视觉特征与自然图像(如动物、风景)差异过大,预训练模型的特征提取能力可能会打折扣。微小缺陷的检测挑战

由于网络在处理过程中存在下采样操作,对于那些面积占比极小(如小于图像面积1%)的缺陷,检测能力会有所下降。虽然可以通过提高输入分辨率来缓解,但这会带来计算成本的增加。超参数的泛化性

虽然模型对超参数表现出了一定的鲁棒性,但在面对一个全新的、特性迥异的应用领域时,可能仍需要经验丰富的工程师进行一些参数调优,才能达到最佳效果。正常变异的边界

在某些工业场景中,正常产品本身就存在一定的外观变异(如木材的天然纹理、纺织品的细微织法变化)。如何让模型准确区分这些正常的变异和真正的缺陷,仍然是一个开放性的挑战。

结论

SuperSimpleNet的问世,为工业表面缺陷检测领域带来了一股清新的变革之风。它用一个统一而优雅的框架,漂亮地解决了长期困扰业界的“数据标注”难题。其“不浪费任何一张标签”的核心理念,以及在精度、速度和灵活性上取得的极致平衡,使其不仅仅是一个优秀的算法模型,更是一个真正具备大规模工业落地潜力的成熟解决方案。

这项工作的影响是深远的。它极大地降低了企业部署AI质检系统的门槛,使得无论处于哪个发展阶段、拥有何种数据状况的工厂,都能从中受益。它所倡导的统一多监督范式,很可能成为未来工业AI系统设计的主流趋势。

说到底,SuperSimpleNet不仅仅是一个技术产品,更是一种思维方式的体现。它告诉我们,面对工业应用的复杂性和多样性,最有效的解决方案,往往不是堆砌更复杂的模型,而是回归问题的本质,用最简洁、最巧妙的设计,去应对最实际的挑战。随着这项技术的开源和推广,我们有理由相信,一个更智能、更高效、更高质量的制造业新时代,正在加速到来。

📢💻 【省心锐评】

SuperSimpleNet用一个模型干了四个模型的活,还干得又快又好。它不是在优化算法,它是在优化部署逻辑,这才是真正能让工厂老板点头掏钱的技术。

.png)

评论